FluxMusic:昆仑推出的一款文本到音乐生成模型

FluxMusic简介

FluxMusic是由昆仑推出的一款创新的文本到音乐生成模型,它基于扩散修正流变换器技术构建,能够在潜在的变分自编码器空间中将文本描述转换为音乐。该模型通过整合先进的注意力机制和预训练的文本编码器,有效地捕捉文本的语义信息,以生成与文本描述相匹配的音乐作品。FluxMusic在多个自动评估指标和人类评审中展现出色的表现,标志着音乐生成技术的重要进步。

FluxMusic主要功能

- 文本到音乐生成: 将文本描述直接转换成音乐,使用户能够通过文字描述来创造音乐。

- 语义理解: 利用预训练的文本编码器捕捉文本中的语义信息,确保生成的音乐与文本描述的情感和风格相匹配。

- 灵活的推理: 通过多个文本编码器的组合,提供灵活的推理选项,以适应不同的生成需求。

- 高效训练: 采用修正流训练方法,提高模型训练的效率和生成音乐的质量。

FluxMusic技术原理

- 扩散模型: 基于扩散模型,通过逐步逆转数据从有序状态到随机噪声的转换过程,来生成音乐。

- 修正流(Rectified Flow): 利用修正流技术优化数据和噪声之间的连接,提高理论属性和生成效果。

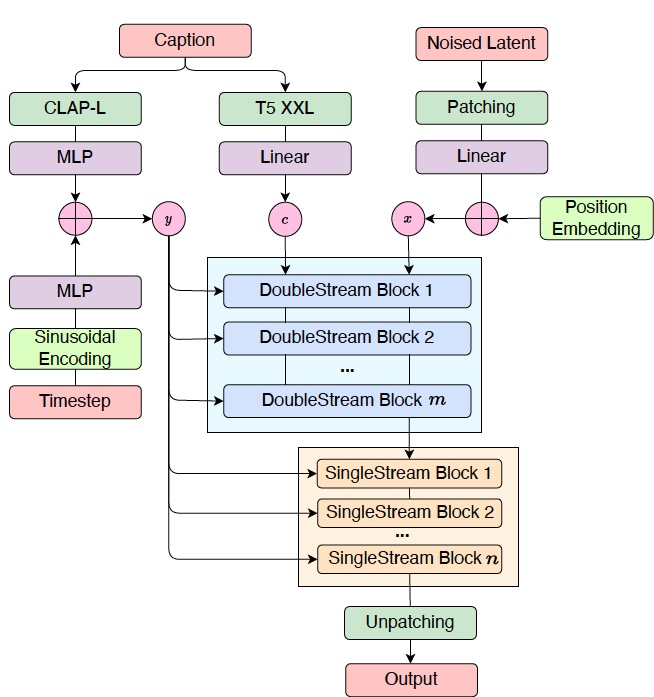

- 双流注意力机制: 在模型初期使用双流注意力机制处理文本和音乐的联合序列,实现信息的双向流动。

- 堆叠单流块: 在文本流被丢弃后,使用堆叠的单音乐流块专注于音乐序列建模。

- 变分自编码器(VAE): 将音乐压缩成潜在空间表示,作为噪声添加和模型训练的基础。

- 梅尔频谱: 将音频信号转换为梅尔频谱,作为音乐表示和生成过程的一部分。

- 预训练文本编码器: 使用如T5 XXL和CLAP-L等预训练模型提取文本特征,增强模型对文本描述的理解能力。

- 调制机制: 结合粗略文本信息和时间步嵌入,用于调整音乐生成过程。

- 细粒度文本细节: 将细粒度文本信息与音乐补丁序列结合,作为模型输入,提高生成音乐的准确性和丰富性。

FluxMusic应用场景

- 音乐创作辅助: 帮助音乐家和作曲家通过文本描述快速生成音乐创意,加速音乐创作过程。

- 多媒体制作: 在电影、游戏和广告制作中,根据场景描述自动生成符合氛围和情感需求的背景音乐。

- 音乐教育: 作为教学工具,让学生通过文本描述来理解和学习音乐创作的基本原则和技巧。

- 虚拟助手: 集成到智能设备中,根据用户的心情或活动自动创作个性化的音乐播放列表。

- 互动娱乐: 在虚拟现实(VR)或增强现实(AR)体验中,根据用户的互动实时生成音乐,提升沉浸感。

- 音乐治疗: 为治疗师和患者创作个性化的音乐,以支持放松、减压或情绪调节的治疗过程。

FluxMusic项目入口

- GitHub源码库:https://github.com/feizc/FluxMusic

- arXiv研究论文:https://arxiv.org/pdf/2409.00587

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号