M2UGen简介

M2UGen是一个由腾讯PCG ARC实验室与新加坡国立大学联合推出的多模态音乐理解和生成框架。该框架利用大型语言模型的强大推理能力,通过整合音乐、图像和视频等多种模态的输入,解锁创意潜力,实现音乐的深入理解和高质量生成。M2UGen专为音乐艺术创作提供辅助,通过预训练的MERT、ViT和ViViT模型,以及AudioLDM 2和MusicGen等音乐生成技术,推动音乐AI领域的创新和发展。

M2UGen主要功能

- 多模态音乐理解:M2UGen能够理解音乐、图像和视频等多种模态的数据,提供深层次的音乐内容理解。

- 音乐生成:从文本、图像和视频等多种模态输入生成音乐,支持创意音乐制作。

- 音乐编辑:根据自然语言提示对现有音乐进行编辑,实现音乐风格的调整和修改。

- 跨模态交互:用户可以通过文本、图像或视频与系统交互,获取相应的音乐输出或对音乐进行操作。

M2UGen技术原理

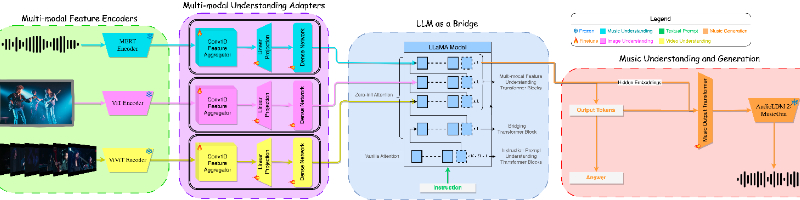

- 预训练模型集成:

- MERT模型:用于音乐编码,处理音乐理解任务。

- ViT模型:用于图像编码,提取图像特征。

- ViViT模型:用于视频编码,捕捉视频的时空特征。

- 多模态理解适配器:将不同模态的特征表示适配到LLaMA 2模型,以实现模态间的信息融合。

- LLaMA 2模型:作为桥梁,整合多模态信息,执行下游任务如音乐问答和音乐生成的指导。

- 音乐解码器:

- AudioLDM 2:一种基于扩散过程的通用音频生成模型。

- MusicGen:一个自回归Transformer解码器,专注于音乐生成。

- 数据集生成:使用MU-LLaMA和MPT-7B模型生成大规模多模态音乐指导数据集,支持模型训练。

- 训练方法:

- LoRA微调:降低计算成本,提高训练效率。

- 双损失策略:结合交叉熵损失和均方误差,优化文本生成和音乐生成任务。

- 条件嵌入生成:通过输出投影层生成条件嵌入,用于指导下游音乐生成模型。

- 主观和客观评估:通过一系列客观指标和用户研究,评估模型在音乐理解、生成和编辑任务上的性能。

M2UGen应用场景

- 音乐制作辅助:音乐家和制作人可以使用M2UGen生成特定风格的音乐,作为新作品的灵感或基础。

- 视频配乐:为视频内容自动生成匹配其情感和节奏的背景音乐,提升观看体验。

- 游戏音乐设计:在游戏开发中,根据游戏场景和玩家行为动态生成音乐,增强沉浸感。

- 教育和学习:在音乐教育中,帮助学生理解音乐理论和创作过程,通过实践学习音乐制作。

- 广告和营销:为广告和营销视频生成吸引人的音乐,以增强品牌信息的传达和记忆。

- 社交媒体内容创作:用户可以为社交媒体上的视频和图像内容创作个性化音乐,增加互动和分享。

M2UGen项目入口

- 官方网站:https://crypto-code.github.io/M2UGen-Demo

- GitHub代码库:https://github.com/shansongliu/M2UGen

- HuggingFace模型:https://huggingface.co/M2UGen

- arXiv技术论文:https://arxiv.org/pdf/2311.11255

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号