MIMO:具有空间分解建模的可控角色视频合成框架

MIMO简介

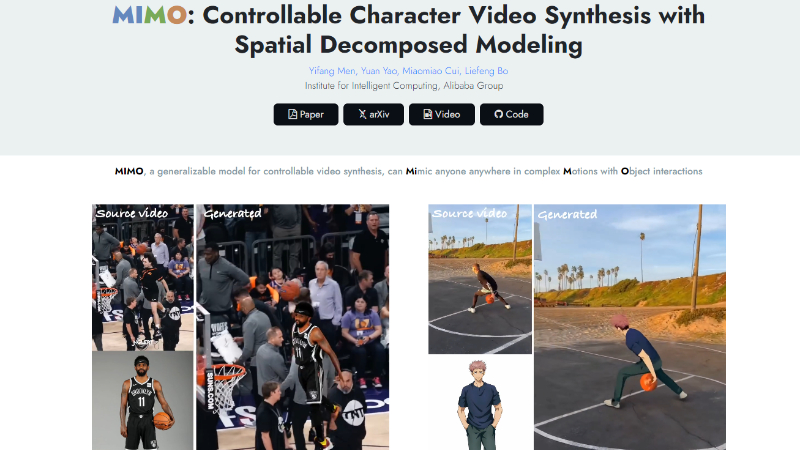

MIMO 是由阿里巴巴集团智能计算研究所推出的角色可控视频合成框架。它能够根据用户简单的输入,如单一图像、姿势序列或单一视频/图像,合成具有控制属性(例如角色、动作和场景)的逼真角色视频。MIMO通过将2D视频转换为3D空间代码,并在层次结构中分解视频,实现对任意角色的可扩展性、对新颖3D动作的普遍性以及对交互式现实世界场景的适用性,从而在统一框架内提供灵活的用户控制和复杂的动作表达。

MIMO主要功能

- 可控属性合成: 用户可以通过简单的输入(如单张图片、姿势序列或视频/图像)来控制生成视频的角色、动作和场景。

- 任意角色的可扩展性: 能够合成任意角色的动画,包括真实人物、卡通角色和拟人化角色。

- 新颖3D动作的普遍性: 支持对新颖和复杂3D动作的合成,包括极端动作和复杂物体交互。

- 交互式现实世界场景的适用性: 可以将角色无缝地融入真实世界的场景中,实现自然的对象交互。

- 分层视频合成: 能够处理具有遮挡对象交互的复杂场景。

MIMO技术原理

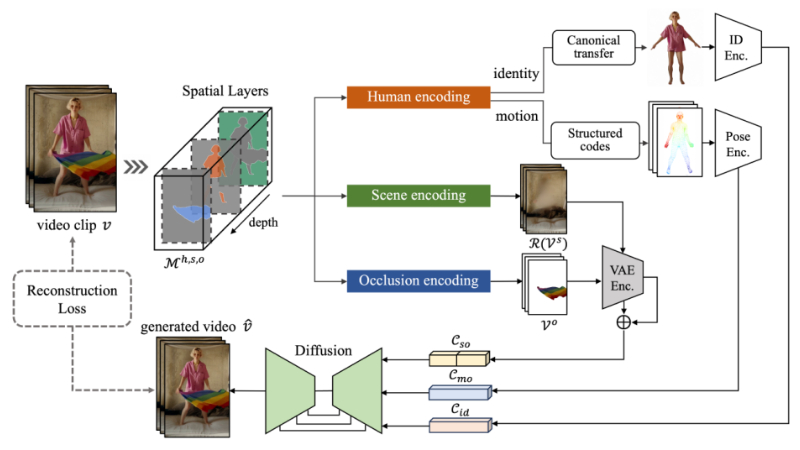

- 空间分解建模: 将2D视频提升到3D,并基于3D深度信息将视频分解为主体人物、底层场景和浮动遮挡三个空间组件。

- 层次化空间层分解: 自动将视频分解为三个主要组件,每个组件代表视频中的不同层次。

- 人体编码的解耦: 通过规范的身份代码和结构化的运动代码来分别编码人物的身份和动作属性。

- 场景和遮挡编码: 使用共享的VAE编码器将场景和遮挡组件嵌入到潜在空间中,形成完整的场景代码。

- 组合解码: 将分解得到的潜在代码作为条件输入到基于扩散的解码器中,以重建视频剪辑。

- 训练过程: 使用扩散噪声预测损失来优化去噪U-Net、姿势编码器和参考网络,实现高质量的视频合成。

- 数据集构建: 创建了一个包含真实和合成角色视频的数据集HUD-7K,用于训练模型,其中合成视频具有准确的标注。

MIMO应用场景

- 电影和视频制作: 利用MIMO生成高质量的动画角色,减少传统动作捕捉的需求,加速视频内容制作流程。

- 虚拟现实(VR): 在VR环境中创建逼真的虚拟角色,提升用户体验,用于游戏、模拟训练等场景。

- 增强现实(AR): 将虚拟角色无缝集成到真实世界中,适用于广告、展览和教育等领域。

- 社交媒体: 用户可以创建个性化的虚拟形象,用于直播、视频聊天或社交媒体平台。

- 教育培训: 合成教师或历史人物的动态视频,用于教育课件,提高学习兴趣和效果。

- 客户服务: 在线上客服或虚拟助手中使用合成角色,提供更亲切、专业的服务体验。

MIMO项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号