Emu3简介

Emu3是由BAAI推出的一款多模态模型,它通过单一的Transformer架构和next-token prediction方法,在视频、图像和文本的生成与感知任务上取得了突破性进展。该模型能够将多模态数据token化,并在无需复杂的扩散模型或组合方法的情况下,实现了对多种任务的卓越处理能力,包括高质量的视频生成。Emu3的创新之处在于它简化了多模态模型的设计,通过集中于token的预测,展现了构建通用多模态智能的潜力。

Emu3主要功能

- 多模态处理: Emu3能够处理和理解视频、图像和文本数据。

- 文本到图像生成: 利用预训练的模型,可以将文本提示转换成图像。

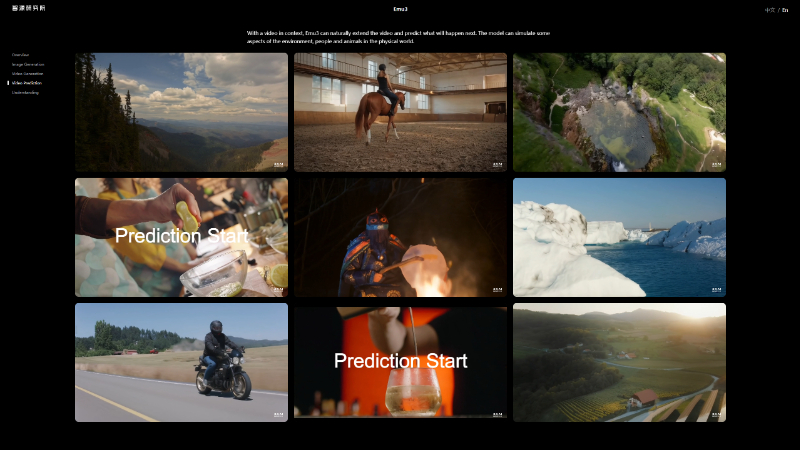

- 视频生成: 模型能够生成高保真度的视频,包括从文本提示生成视频和视频的连续性预测。

- 视觉-语言理解: 在多种公共视觉-语言基准测试中,Emu3展现出强大的理解能力。

- 自我监督学习: 通过next-token prediction进行自我监督预训练,无需额外的标注数据。

Emu3技术原理

- Tokenization(Token化): 将图像和视频数据编码成序列化的token,以便模型能够处理。

- 单一Transformer架构: 使用一个统一的Transformer模型来处理所有类型的数据。

- Next-Token Prediction(下一个Token预测): 模型被训练来预测序列中的下一个token,无论是文本、图像还是视频数据。

- 离散空间表示: 图像和视频数据被映射到一个离散的token空间,使得可以像处理文本一样处理它们。

- 预训练和微调: 模型首先在多模态数据集上进行预训练,然后在特定任务上进行微调以提高性能。

- 视觉Tokenizer: 一个基于SBER-MoVQGAN的视觉Tokenizer,用于将视觉数据压缩成token。

- 模型配置: Emu3模型采用了大规模语言模型(LLMs)的架构,并对嵌入层进行了扩展,以适应视觉token。

- 质量微调(Quality Fine-Tuning): 在预训练之后,使用高质量数据进行额外训练,以提升生成的视觉内容的质量。

- 直接偏好优化(Direct Preference Optimization, DPO): 利用人类评价数据来优化模型,使其更好地符合人类的偏好。

Emu3应用场景

- 内容创作:自动生成文章配图或视频内容,提高媒体和娱乐产业的创作效率。

- 教育辅助:生成教育材料中的图解和示例视频,增强学习体验。

- 虚拟助手:提供基于文本描述的图像和视频信息,帮助用户更直观地获取答案。

- 设计和建筑:根据文本描述生成设计概念图或建筑可视化,辅助规划和决策。

- 游戏开发:快速生成游戏资产,如背景、角色和动画,加速游戏设计过程。

- 数据增强:为机器学习模型生成额外的训练数据,提高模型的泛化能力。

Emu3项目入口

- 官方项目主页:https://emu.baai.ac.cn/about

- GitHub源码库:https://github.com/baaivision/Emu3

- arXiv研究论文:https://arxiv.org/pdf/2409.18869

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号