Stable Video Portraits:创建逼真的谈话面部视频,具有照片级真实感

Stable Video Portraits简介

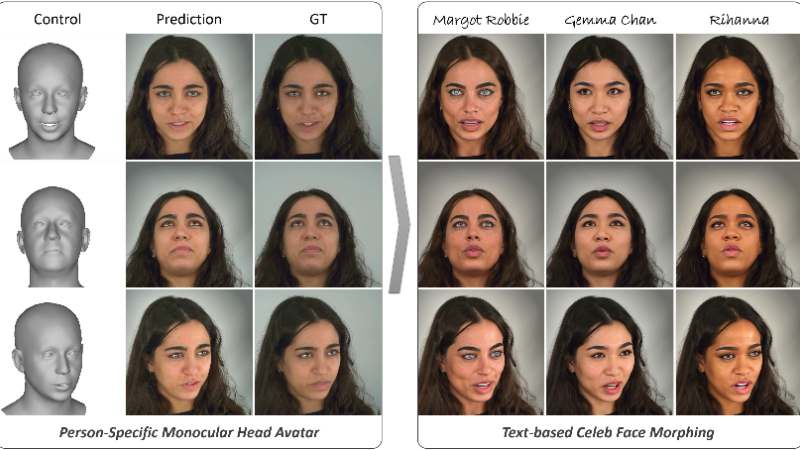

Stable Video Portraits 是由德国马克斯·普朗克智能系统研究所和达姆施塔特工业大学的团队开发的一种创新技术。这项技术能够生成高保真的2D/3D混合人头化身视频,利用大型预训练的文本到图像模型和3D形态模型,实现对头部姿态和表情的精细控制。通过一种新颖的去噪算法,该技术能够在保持时间连贯性的同时,生成逼真的视频肖像,并且能够在无需额外训练的情况下,通过文本指令将人物面部特征变形为指定名人的面貌。

Stable Video Portraits主要功能

- 高保真视频生成: 创建逼真的谈话面部视频,具有照片级真实感。

- 个性化化身控制: 允许用户通过3D形态模型(3DMM)参数控制头部姿态和面部表情。

- 文本驱动的面部变形: 用户可以通过文本指令在不需要额外训练的情况下,将视频中人物的面部外观变形为特定的名人面貌。

- 时间连贯性: 引入了新的去噪过程,确保视频中的面部动作和表情在时间上保持连贯和平滑。

- 无需微调: 在测试时对特定文本定义的名人面貌进行面部变形,无需对模型进行微调。

Stable Video Portraits技术原理

- 混合2D/3D生成方法: 结合了2D图像生成模型(如Stable Diffusion)和3D形态模型来生成视频。

- 人特定微调: 对通用的2D稳定扩散模型进行微调,以适应特定人物的面部特征。

- 3DMM参数化控制: 使用3D形态模型来控制头部姿态和表情,提供细粒度的控制。

- 时间序列去噪: 在推断过程中,通过考虑前一帧的信息来改进去噪过程,增强视频的时间连贯性。

- 文本到图像的转换: 利用大型预训练的文本到图像模型来生成与文本描述相匹配的面部图像。

- 面部解析图生成: 利用生成的图像来训练面部解析图的模型,用于后续的视频生成控制。

- 时间条件控制: 通过将时间条件整合到ControlNet中,使用一系列网格作为输入,来增强模型的时间连贯性。

- 潜在表示的整合: 在推断过程中整合前一帧的潜在表示,以生成更加稳定和视觉连贯的预测。

Stable Video Portraits应用场景

- 增强现实(AR)和虚拟现实(VR): 在虚拟环境中为用户提供高度个性化的头像,提升沉浸式体验。

- 视频会议和远程呈现: 创建逼真的数字化分身,用于远程交流和会议,提高互动质量。

- 内容创作: 为电影、游戏和在线娱乐制作高质量的数字化角色和动画。

- 社交媒体和娱乐: 允许用户创建和分享个性化的视频内容,增加互动性和娱乐性。

- 教育和培训: 制作虚拟教师或培训员,提供互动式学习体验。

- 个性化广告: 利用个人化的视频肖像技术,为用户定制更具吸引力的广告内容。

Stable Video Portraits项目入口

- 官方项目主页:https://svp.is.tue.mpg.de/

- arXiv研究论文:https://arxiv.org/abs/2409.18083

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号