Oryx MLLM简介

Oryx MLLM是由清华大学、腾讯公司以及南洋理工大学S-Lab联合开发的多模态大型语言模型。该模型通过创新的预训练OryxViT视觉编码器和动态压缩模块,能够灵活高效地处理不同空间尺寸和时间长度的视觉输入,包括图像、视频和3D场景。Oryx MLLM在多模态理解方面展现了卓越的性能,尤其在长视频理解和3D空间意识任务中表现突出,为多模态人工智能领域提供了新的研究方向和应用潜力。

Oryx MLLM主要功能

- 空间-时间理解:能够理解图像、视频和多视图3D场景中的空间和时间信息。

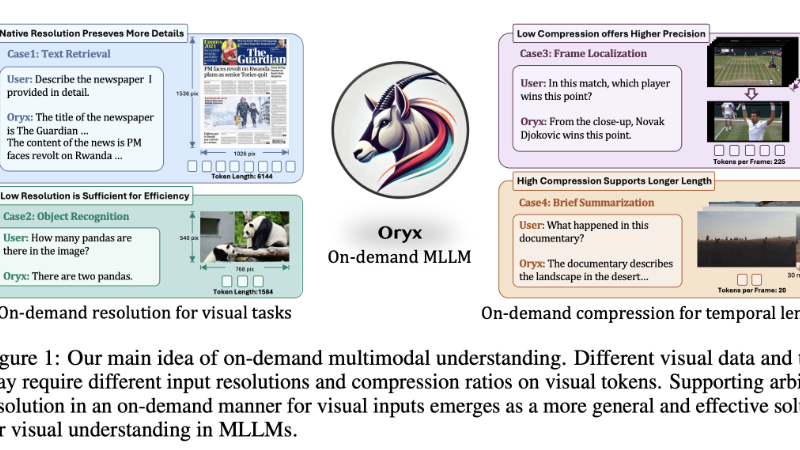

- 任意分辨率处理:支持对视觉输入进行原生分辨率编码,无需标准化到固定分辨率。

- 动态压缩:根据需求对视觉标记进行可变比例的压缩,以处理不同长度的视觉内容。

- 多模态理解:集成视觉和语言输入,以生成连贯和上下文相关的回应。

- 长视觉内容处理:特别优化以处理长视频等长视觉内容,同时保持高压缩率和高识别精度。

- 3D空间意识:通过粗略对应标记增强对3D环境的理解。

Oryx MLLM技术原理

- 预训练的OryxViT模型:

- 利用可适应不同分辨率的视觉编码器,为语言模型生成友好的视觉表示。

- 使用自适应位置嵌入和可变长度的自注意力机制,高效处理不同尺寸的视觉数据。

- 动态压缩模块:

- 根据视觉输入的长度和需求动态调整下采样比例。

- 通过共享投影器融合信息,支持从1x到16x的压缩。

- 原生分辨率和压缩优化:

- 为文本相关任务保留高分辨率以捕捉更多细节,同时为效率任务使用低分辨率。

- 通过优化分辨率和压缩比例,提高效率并满足实际需求。

- 数据策划和训练策略:

- 增强数据策划,专门针对长上下文检索和空间感知数据进行训练。

- 通过统一的训练策略,使模型能够同时适应任意输入分辨率和任务。

- 多模态数据理解:

- 通过统一的架构设计,处理视觉内容的不同形式和完成更具挑战性的多模态理解问题。

- 在模型训练中结合图像、视频和3D数据,以实现多模态理解。

- 长视频理解训练:

- 使用长视频数据集进行训练,以提高模型在处理极长视频内容时的能力。

- 3D空间理解训练:

- 引入粗略对应标记,以增强模型对3D环境的空间相关性理解。

Oryx MLLM应用场景

- 视频内容分析:自动化分析监控视频中的事件,进行安全监控或异常行为检测。

- 智能助理:提供基于视频内容理解的交互式问答,增强用户体验。

- 教育和培训:通过分析教育视频来增强学习体验,提供个性化反馈。

- 自动驾驶:理解道路场景视频,辅助自动驾驶系统的决策过程。

- 内容推荐系统:根据用户观看的视频内容和习惯,推荐相关视频或多媒体内容。

- 3D建模和游戏:在3D建模和游戏开发中,提供对复杂场景的深入理解,以增强虚拟环境的互动性。

Oryx MLLM项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号