Animate-X:从参考图像和目标姿势序列生成高质量的视频

Animate-X简介

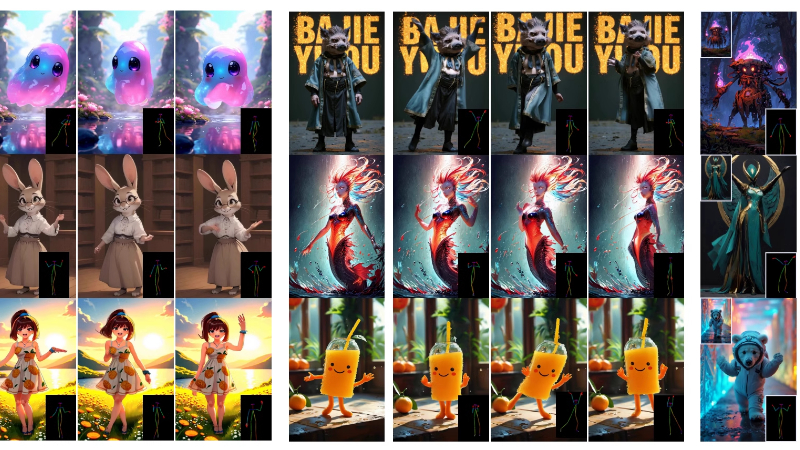

Animate-X是由蚂蚁集团和阿里巴巴集团的研究人员共同开发的一种先进的角色图像动画技术。这项技术通过引入创新的姿势指示器(Pose Indicator),能够捕捉和模拟复杂的运动模式,从而将静态图像转化为生动的视频动画。Animate-X不仅适用于人类角色,还能处理各种拟人化角色,如游戏和动画中的卡通形象,极大地扩展了角色动画的应用范围。此外,该团队还创建了一个新的评估基准A2Bench,进一步证明了Animate-X在多样性和泛化能力方面的优势。

Animate-X主要功能

- 高质量视频生成:从参考图像和目标姿势序列生成高质量的视频。

- 广泛的适用性:适用于多种角色类型,包括人类和拟人化角色(如卡通、游戏角色)。

- 身份保持与运动一致性:在动画过程中保持角色身份的同时,确保运动的连贯性。

- 通用性:不依赖于严格的姿势对齐,可以处理各种姿势输入,包括非人类角色。

- 性能评估:通过新提出的Animated Anthropomorphic Benchmark (A2Bench) 评估模型性能。

Animate-X技术原理

- Latent Diffusion Model (LDM):使用预训练的变分自编码器(VAE)将输入数据编码到低维潜在空间,通过噪声添加和逆向去噪过程生成数据。

- Pose Indicator:

- 隐式姿势指示器(Implicit Pose Indicator, IPI):利用CLIP视觉特征提取驱动视频的隐式运动特征,捕捉整体运动模式和时间关系。

- 显式姿势指示器(Explicit Pose Indicator, EPI):通过预先模拟可能在推理过程中出现的输入,增强模型对姿势的理解和表示,提高泛化能力。

- 3D-UNet架构:作为去噪网络,接收运动特征和身份特征作为条件,生成动画视频。

- 跨注意力和前馈网络:在隐式姿势指示器中使用,以提取关键的运动特征。

- 姿势变换方案:包括姿势重对齐和姿势重缩放,模拟训练期间的参考图像和姿势图像之间的错位,增强模型对错位情况的鲁棒性。

- 多步噪声添加:在潜在空间中逐步添加高斯噪声,模拟数据生成过程,降低计算需求同时保持生成能力。

- 条件损失优化:使用L2损失减少预测噪声和真实噪声之间的差异,优化去噪过程。

- VAE解码器:将生成的潜在表示映射回像素空间,重建预测视频。

Animate-X应用场景

- 游戏开发:为游戏中的非人类角色生成动态动画,提升游戏的互动性和沉浸感。

- 电影和视频制作:快速生成拟人化角色的动画,减少传统动画制作的时间与成本。

- 虚拟主播和直播:创建虚拟主播进行直播,无需真人出演,提高内容生产的灵活性。

- 教育和培训:生成教育内容中的角色动画,使学习材料更加生动有趣。

- 广告和营销:设计吸引人的拟人化角色动画,用于广告宣传,增强品牌形象。

- 社交媒体内容创作:允许用户为社交媒体平台创作个性化的拟人化角色视频内容,增加互动和娱乐性。

Animate-X项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号