GAGAvatar简介

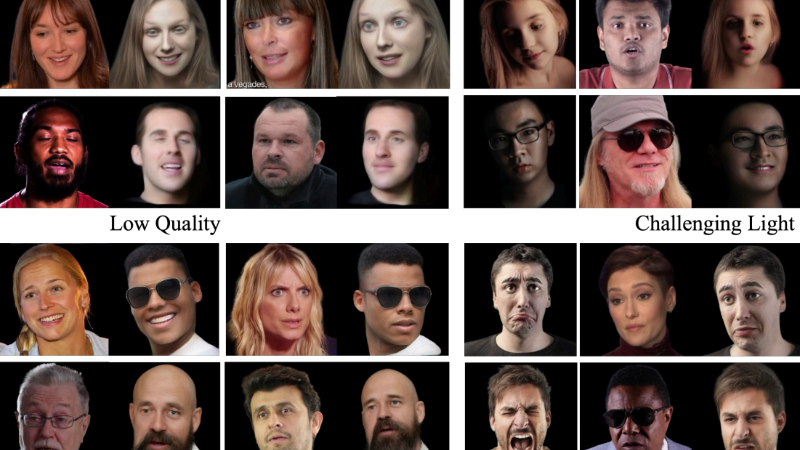

GAGAvatar是由东京大学的研究团队开发的一种创新的一次性可动画化头部头像重建方法。这项技术通过单张图像生成3D高斯参数,能够实现快速的表情控制和渲染,解决了以往方法中渲染消耗大和重演速度慢的问题。GAGAvatar采用了一种新颖的双提升方法来重建3D高斯,利用全局图像特征和3D可变形模型来控制表情,使得重建的头像在不同视角下都能保持高度的一致性和真实感。该技术在重建质量和表情准确性方面均优于现有方法,并且能够实现实时的重演速度,为数字虚拟形象的研究和应用开辟了新的可能性。

GAGAvatar主要功能

- 一次性头像重建: GAGAvatar能够从单张图像中重建出可动画化的3D头像。

- 实时重演速度: 该技术能够在实时速度下进行头像的动态表情重演。

- 跨身份泛化: 训练后的模型能够泛化到未见过的面孔身份,无需针对特定身份的优化。

- 高质量重建: 通过双提升方法和3D可变形模型,GAGAvatar能够生成高保真的3D头像,捕捉到丰富的面部细节和表情。

- 表情控制: 结合3D可变形模型,GAGAvatar能够对重建的头像进行精确的表情控制。

GAGAvatar技术原理

- 3D Gaussians生成: 从单张图像生成3D高斯参数,这是通过预测每个像素相对于图像平面的提升距离来实现的。

- 双提升方法(Dual-lifting Method): 通过分别预测向前和向后的提升距离,从单张图像中重建出完整的3D结构。

- 3D Morphable Model(3DMM): 利用3DMM的先验知识来约束提升过程,帮助模型捕获源图像中的细节,并用于表情控制。

- 全局图像特征: 结合全局图像特征和3DMM可学习特征,构建用于控制表情的3D高斯。

- 神经渲染器(Neural Renderer): 使用神经渲染器来细化由3D高斯渲染的粗糙图像,生成最终的精细重演图像。

- 损失函数设计: 引入了一个基于3DMM先验的lifting距离损失函数,以确保预测的提升距离尽可能接近3DMM顶点。

- 高效训练策略: 模型主要从单目肖像图像中学习,能够在训练后泛化到未见过的面孔身份。

GAGAvatar应用场景

- 虚拟现实(VR): GAGAvatar可以用于创建虚拟现实中的用户头像,提供更加真实和个性化的沉浸式体验。

- 增强现实(AR): 在增强现实应用中,该技术可以用来生成与现实世界中的人物表情同步的虚拟形象。

- 视频会议: 提供实时的面部表情捕捉和头像替换,增强远程沟通中的非语言交流,使在线会议更加自然。

- 游戏和娱乐: 在游戏或电影制作中,GAGAvatar可以用于快速生成具有高度细节和表情的虚拟角色,降低传统动作捕捉的成本。

- 社交媒体: 用户可以创建个性化的动画头像,用于社交媒体平台,增加互动性和表达自我的方式。

- 教育培训: 在线上教育或培训中,GAGAvatar可以作为虚拟讲师或学员的头像,提供更加生动和互动的学习体验。

GAGAvatar项目入口

- 官方项目主页:https://xg-chu.site/project_gagavatar/

- GitHub源码库:https://github.com/xg-chu/GAGAvatar

- arXiv研究论文:https://arxiv.org/pdf/2410.07971

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号