CAMI2V:根据文本提示精确控制视频中的相机姿态

CAMI2V简介

CAMI2V是由浙江大学计算机科学与技术学院的研究团队开发的先进图像到视频扩散模型,它通过引入极线注意力机制和注册令牌,显著提升了相机控制的精确性和视频生成的3D一致性。该模型不仅在RealEstate10K数据集上实现了25.5%的相机可控性提升,还能有效处理快速相机移动、动态对象和遮挡等情况。研究团队计划发布相关代码和预训练模型,以促进该领域的进一步研究。

CAMI2V主要功能

- 相机控制: CAMI2V能够根据文本提示精确控制视频中的相机姿态,包括旋转和平移,实现用户友好的相机操作。

- 图像到视频的转换: 该模型可以将静态图像转换为动态视频,同时保持与文本描述的一致性。

- 多帧关系建模: 通过极线注意力机制,模型能够捕捉不同视频帧之间的空间关系,增强视频的3D一致性。

- 跨帧特征跟踪: 在高噪声条件下,模型仍能跟踪跨帧移动的特征,保持视频内容的连贯性。

- 领域外泛化: 模型不仅在特定数据集上表现良好,还能泛化到未见过的领域,如油画、摄影和动画等。

- 高效的内存使用: 在训练和推理过程中,模型只需要相对较低的GPU内存,便于在资源有限的环境中部署。

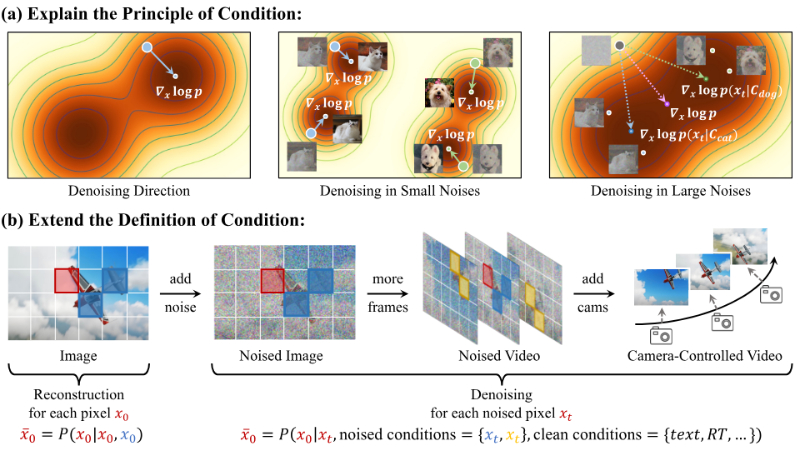

CAMI2V技术原理

- 极线注意力机制: 通过极线约束来聚合特征,确保即使在高噪声条件下,也只聚合沿着极线的特征,从而增强跨帧的3D一致性。

- Plücker坐标: 作为3D射线嵌入,用于隐式学习3D空间,为模型提供全局位置编码。

- 注册令牌: 用于处理帧间无交集的情况,如快速相机移动、动态对象或遮挡,增强模型的适应性和鲁棒性。

- 多尺度引导: 通过独立控制图像、文本和相机的引导尺度,实现对生成视频的精确控制。

- 稳健的评估流程: 建立了一个更稳健、准确和可复现的评估流程,使用全局结构从运动方法来验证相机姿态的一致性。

- 扩散模型: 基于扩散模型的原理,通过逐步去噪的方式,从噪声数据中恢复出清晰的视频内容。

CAMI2V应用场景

- 影视制作: 用于生成高质量的动态场景,帮助导演和制片人快速实现创意构思。

- 游戏开发: 在游戏中生成动态视频内容,提升游戏的沉浸感和视觉效果。

- 虚拟现实(VR): 为VR应用生成真实感强的环境视频,增强用户体验。

- 广告创意: 制作富有创意的广告视频,通过图像和文本描述快速生成吸引观众的内容。

- 教育培训: 制作教学视频,帮助学生更好地理解复杂概念,通过动态演示增强学习效果。

- 艺术创作: 在数字艺术中生成动画作品,艺术家可以通过图像和文本自由创作动态艺术。

CAMI2V项目入口

- 官方项目主页:https://zgctroy.github.io/CamI2V/

- GitHub源码库:https://github.com/ZGCTroy/CamI2V

- arXiv研究论文:https://arxiv.org/pdf/2410.15957

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号