VILA-U简介

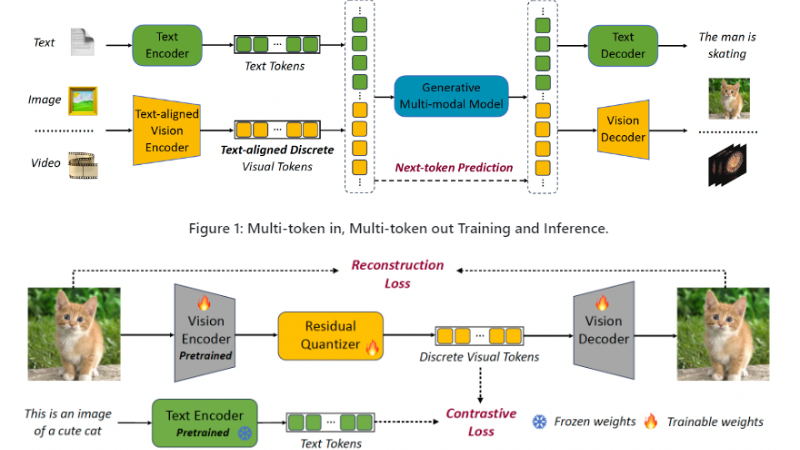

VILA-U是一个创新的统一视觉语言模型,它整合了视频、图像和语言的理解和生成能力。与传统视觉语言模型不同,VILA-U采用单一的自回归下一个token预测框架,简化了模型结构,同时接近最先进的性能水平。其成功归功于统一的视觉塔和高质量的数据集,使得自回归图像生成能够达到与扩散模型相似的质量。VILA-U在多模态任务中展现出强大的性能,为视觉语言研究提供了一个高效且简洁的解决方案。

VILA-U主要功能

- 视觉语言理解:VILA-U能够理解和处理涉及图像和语言的任务,如图像字幕生成和视觉问题回答。

- 视觉内容生成:模型能够根据文本提示生成图像和视频内容。

- 多模态学习:通过整合视觉和语言数据,VILA-U在预训练阶段学习跨模态关联,以提升理解和生成能力。

- 零样本学习:VILA-U在没有明确训练的情况下,能够处理和理解新的图像和语言任务。

VILA-U技术原理

- 统一的自回归框架:VILA-U使用单一的自回归下一个token预测框架来处理视觉和文本输入,简化了模型结构。

- 统一视觉塔(Unified Vision Tower):

- 特征提取:将图像和视频转换为视觉特征。

- 向量量化(VQ):通过向量量化将连续的视觉特征转换为离散的token。

- 对比学习:在预训练阶段,通过对比学习将视觉token与文本输入对齐,增强视觉感知能力。

- 多模态训练:

- 数据融合:将视觉token和文本token组合成一个多模态序列进行训练。

- 特殊token:使用特殊的开始和结束token(如

<image_start>和<image_end>)来标记视觉内容的边界。

- 深度自回归预测:

- 文本token:使用传统的语言模型损失函数来预测文本token。

- 视觉token:对于视觉token,考虑到向量量化引入的深度结构,使用深度自回归模型来预测每个深度的残差token。

- 预训练数据形式:使用不同的文本和视觉token组合形式,以促进理解和生成任务。

- 分类器自由引导(Classifier-free Guidance, CFG):在视觉内容生成过程中,使用CFG来优化生成质量。

VILA-U应用场景

- 图像字幕生成:自动为图片生成描述性文字,适用于社交媒体图片描述和视觉障碍人士的辅助工具。

- 视觉问题回答(Visual QA):根据图像内容回答相关问题,应用于教育软件和智能助手。

- 内容审核:自动识别和过滤不适宜的内容,用于社交媒体和在线平台的内容管理。

- 图像和视频搜索:通过文本查询检索相关图像或视频,改善搜索引擎的多媒体搜索功能。

- 虚拟助手和聊天机器人:提供基于图像和语言交互的虚拟助手服务,增强用户体验。

- 自动化设计和创意生成:根据文本描述自动创建图形设计或艺术作品,辅助设计师和艺术家。

VILA-U项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号