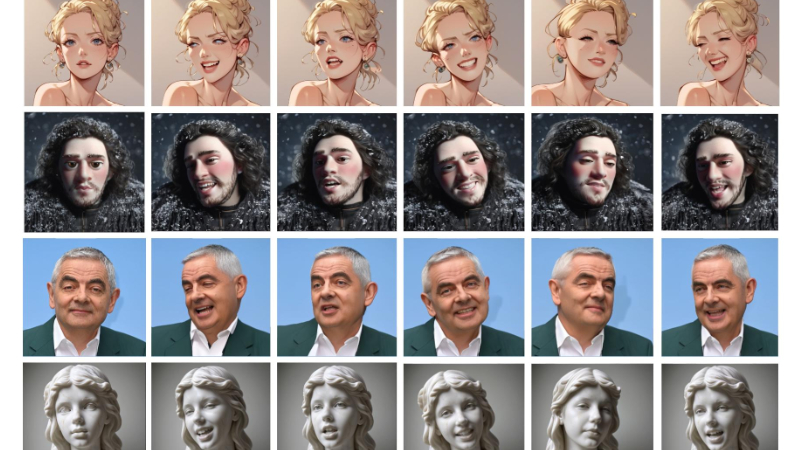

HelloMeme:能够处理夸张的面部表情和头部姿势

HelloMeme简介

HelloMeme是一种创新的方法,通过在文本到图像基础模型中插入适配器,利用空间编织注意力机制来增强模型性能,从而实现复杂的下游任务。该方法在生成梗视频时表现出色,能够处理夸张的面部表情和头部姿势,同时保持模型的泛化能力。HelloMeme由三个主要模块组成:HMReferenceNet用于提取参考图像的高保真特征,HMControlNet用于提取头部姿势和面部表情等高层次特征,HMDenoisingNet则负责核心去噪功能。实验结果表明,HelloMeme在自我重演和跨重演任务中均优于现有方法,展示了其在保持高保真度和生成多样性方面的优势。

HelloMeme主要功能

- 生成梗视频:通过处理夸张的面部表情和头部姿势,实现高质量的梗视频生成。

- 保持模型泛化能力:在执行复杂下游任务的同时,不牺牲基础文本到图像模型的泛化能力。

- 高保真特征提取:提取参考图像中的高保真特征,确保生成的图像和视频具有高质量和细节。

- 多样化内容生成:利用Stable Diffusion模型的丰富定制方法,增强内容生成的多样性。

HelloMeme技术原理

- 空间编织注意力机制(Spatial Knitting Attentions):

- 通过行列交替的方式进行注意力操作,保留2D特征图的空间结构信息,避免了直接展平特征图带来的空间信息丢失。

- 模块设计:

- HMReferenceNet:用于从参考图像中提取高保真特征,基于完整的SD1.5 UNet,仅在推理时执行一次。

- HMControlNet:提取头部姿势和面部表情等高层次特征,并将这些特征映射到UNet的不同尺度的潜在空间中。

- HMDenoisingNet:核心去噪模型,基于完整的SD1.5 UNet,接收HMReferenceNet和HMControlNet传递的特征,生成具有新头部姿势和面部表情的图像。

- 融合机制:

- 使用SKCrossAttention机制将头部姿势和面部表情特征融合到三种尺度的特征图中,传递给HMDenoisingNet。

- 训练与优化:

- 通过固定SD1.5 UNet的权重,仅优化插入模块的参数,确保与SD1.5派生模型的兼容性。

- 使用加权损失函数增强对夸张面部表情的表示能力,特别是在眼睛和嘴巴区域。

- 视频生成:

- 采用两阶段方法生成视频帧,首先逐帧生成初始视频,然后通过引入运动模块(Animatediff)进行再噪声处理,改善帧间连续性和保真度。

HelloMeme应用场景

- 社交媒体内容创作:用户可以利用HelloMeme生成个性化的梗视频,用于社交媒体平台,增加互动和娱乐性。

- 广告与营销:企业可以创建吸引人的广告视频,通过夸张的面部表情和动作来吸引观众注意力,提升品牌影响力。

- 教育与培训:在教育领域,可以制作教学视频,通过夸张的表情和动作来解释复杂概念,提高学习效率。

- 虚拟主播与直播:利用HelloMeme技术,可以生成虚拟主播,进行24小时不间断的直播,提供新闻、娱乐等内容。

- 电影与游戏制作:在电影或游戏制作中,HelloMeme可以用于生成或增强角色的面部表情和动作,提高制作效率和真实感。

- 个性化娱乐:用户可以根据自己的喜好,生成具有特定风格和表情的虚拟形象,用于个人娱乐或作为虚拟助手。

HelloMeme项目入口

- 官方项目主页:https://songkey.github.io/hellomeme/

- GitHub源码库:https://github.com/HelloVision/HelloMeme

- arXiv研究论文:https://arxiv.org/pdf/2410.22901

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号