WEBRL:清华与智谱AI联合推出的自进化在线课程强化学习框架

WEBRL简介

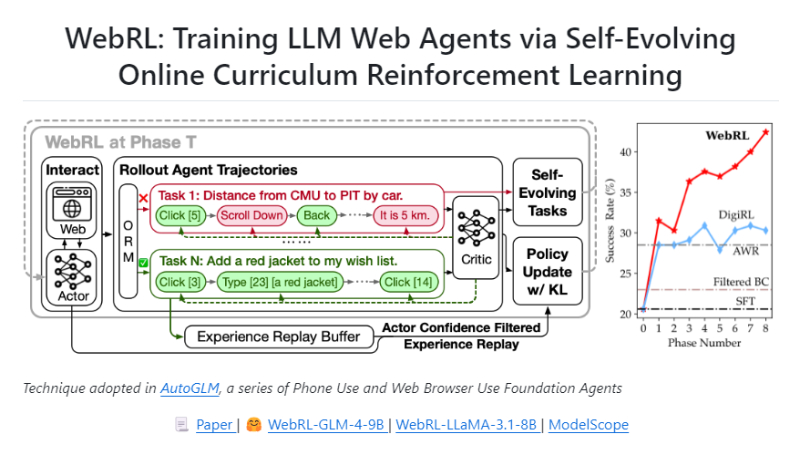

WEBRL是由清华大学与智谱AI联合开发的自进化在线课程强化学习框架,旨在训练基于大型开放语言模型的高性能网络代理。通过解决训练任务稀缺、反馈信号稀疏和在线学习中的策略分布漂移等挑战,WEBRL显著提升了网络代理在复杂网络任务中的表现,使其在多个基准测试中超越了专有的大型语言模型API和先前的最先进水平。

WEBRL主要功能

- 自进化课程学习:WEBRL能够根据模型在前一阶段的失败尝试自动生成新任务,从而不断适应和提升模型的处理能力。

- 结果监督奖励模型(ORM):通过训练一个LLM来评估任务执行的成功与否,提供反馈信号,指导模型学习。

- 自适应强化学习策略:采用KL散度约束和经验回放缓冲区等技术,确保模型在新任务学习中保持稳定性,避免策略分布漂移。

- 经验回放缓冲区:存储成功的任务执行轨迹,并使用演员置信度过滤策略来筛选用于训练的数据,以提高学习效率。

- 持续性能提升:通过迭代的自我进化,WEBRL能够持续提升模型在各种网络任务中的表现。

WEBRL技术原理

- 有限视界马尔可夫决策过程(MDP):将网络任务建模为MDP,其中状态由当前网页的HTML内容和历史动作组成,动作是在网页上执行的操作。

- ORM训练:利用LLM对代理的执行轨迹进行评估,确定任务是否成功完成,并据此提供奖励信号。

- KL散度约束的策略更新:在策略更新过程中引入KL散度约束,以控制新旧策略之间的差异,减少策略分布的漂移。

- 经验回放与置信度过滤:通过存储成功的执行轨迹,并基于演员模型的置信度对这些轨迹进行过滤,选择适合当前模型能力的训练数据。

- 自进化新指令生成:根据模型当前的技能水平动态调整任务的复杂度,生成新的任务指令,以促进模型的持续学习。

- 强化学习算法:使用强化学习算法来优化模型的决策过程,使得模型能够在长期累积奖励最大化的同时,逐步提升其在网络任务中的表现。

WEBRL应用场景

- 网络数据提取:WEBRL可以用于自动化从网站提取特定数据,例如财务报告中的销售数据或社交媒体上的用户评论。

- 在线购物助手:作为电子商务平台的购物助手,帮助用户通过语音或文本指令完成商品搜索、比较和购买。

- 客户服务自动化:在客户支持平台中,WEBRL可以自动处理常见的查询和任务,如订单状态更新和问题解答。

- 内容管理系统(CMS)交互:WEBRL能够与CMS接口,自动更新内容、发布文章或管理用户权限。

- 自动化办公任务:在办公环境中,WEBRL可以用于自动化执行如日程安排、电子邮件分类和数据录入等任务。

- 智能搜索引擎优化(SEO):WEBRL可以帮助网站管理员优化搜索引擎排名,通过自动调整元标签和关键词密度来提高网站可见性。

WEBRL项目入口

- GitHub仓库:https://github.com/THUDM/WebRL

- arXiv技术论文:https://arxiv.org/pdf/2411.02337v1

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号