iDP3:斯坦福大学等联合推出的3D视觉动作策略

iDP3简介

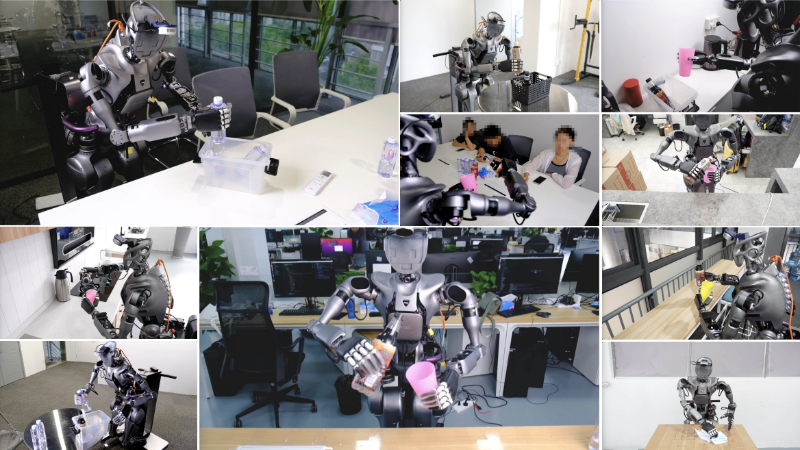

iDP3(Improved 3D Diffusion Policy)是由斯坦福大学、西蒙弗雷泽大学、宾夕法尼亚大学、伊利诺伊大学香槟分校和卡内基梅隆大学联合开发的一种先进的3D视觉动作策略。该策略通过利用自我中心的3D视觉表示,消除了对相机校准和点云分割的依赖,使得仿人机器人能够在多样化的真实世界环境中执行复杂的操控任务。iDP3在单一场景中训练,展现出了卓越的泛化能力和对新场景的适应性,显著提高了机器人在现实世界部署的效率和效果。

iDP3主要功能

- 泛化能力:iDP3能够使仿人机器人将在单一场景中学习到的技能泛化到多样化的未见场景中。

- 自我中心3D视觉表示:通过使用自我中心的3D视觉表示,iDP3能够在不依赖精确相机校准的情况下工作。

- 消除点云分割需求:iDP3不需要对点云进行精细分割,简化了对复杂环境的处理。

- 视图不变性:iDP3展现出对视点变化的鲁棒性,能够在不同视角下执行任务。

- 对象泛化:iDP3能够处理在训练中未见过的新对象,显示出良好的对象泛化能力。

- 场景泛化:iDP3能够在不同的现实世界场景中部署,显示出跨场景的泛化能力。

iDP3技术原理

- 3D视觉动作策略:iDP3结合了3D视觉表示和扩散策略,以实现对机器人动作的控制。

- 自我中心3D视觉表示:iDP3使用从相机帧中直接获取的3D表示,而不是依赖于世界帧中的表示,从而减少了对相机校准的依赖。

- 扩展视觉输入:通过增加样本点的数量,iDP3能够捕获整个场景,提高了对场景的理解和处理能力。

- 改进的视觉编码器:iDP3使用金字塔卷积编码器替换了原有的MLP视觉编码器,以提高从人类数据中学习时的平滑性和准确性。

- 更长的预测视野:通过延长预测视野,iDP3能够更有效地处理人类专家的抖动和传感器噪声。

- 优化和训练:iDP3使用AdamW进行训练,并通过DDIM进行扩散过程,以实现更好的策略学习。

- 点云采样:iDP3采用体素采样和均匀采样的级联,替代了DP3中使用的最远点采样,以确保样本点覆盖3D空间的同时提高推理速度。

iDP3应用场景

- 家庭服务:在家庭环境中执行日常任务,如收拾物品、倒水和擦桌子,提升家居自动化水平。

- 餐饮服务:在餐厅中进行端盘、倒饮料等任务,减少服务员的工作负担,提高服务效率。

- 工业制造:在生产线上进行精确的零件装配和物料搬运,提高生产效率和安全性。

- 医疗辅助:在医院或诊所中协助护士进行物品传递和简单的护理工作,减少医护人员的工作量。

- 仓库物流:在仓库中进行货物的分拣、搬运和存储,提高物流效率,降低人工成本。

- 灾难救援:在灾难现场进行搜救和物资搬运,减少救援人员的风险,提高救援效率。

iDP3项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号