ShowUI:新加坡国立大学和微软共同推出的视觉-语言-动作模型

ShowUI简介

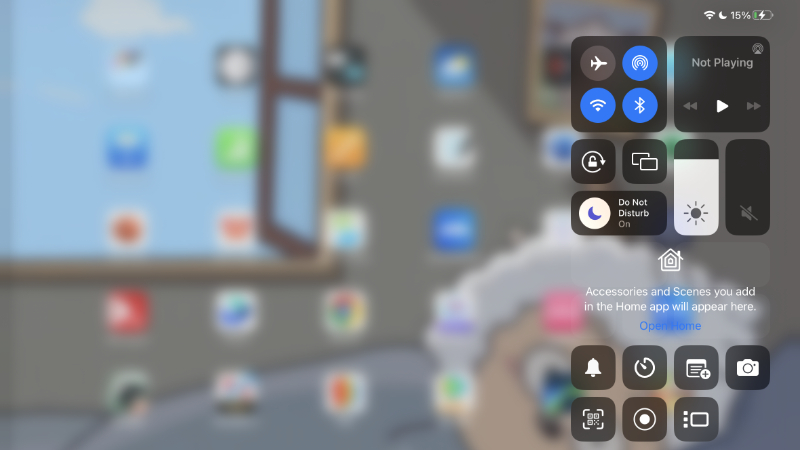

ShowUI是由新加坡国立大学Show Lab和微软共同开发的一个创新的视觉-语言-动作模型,旨在提升图形用户界面(GUI)自动化的效率和效果。该模型通过UI引导的视觉令牌选择、交错的视觉-语言-动作流处理以及精选的GUI指令遵循数据集,实现了在高分辨率屏幕截图上的高效视觉建模,并有效管理跨模态的复杂交互。ShowUI在零样本屏幕截图定位任务中表现出色,准确率高达75.1%,展现了其在GUI视觉代理领域的潜力。

ShowUI主要功能

- GUI自动化: ShowUI能够理解和执行与图形用户界面相关的任务,如导航和元素定位,从而自动化用户在数字世界中的交互。

- 视觉-语言-动作集成: 该模型能够处理视觉输入(屏幕截图)、语言指令(用户命令)和动作输出(界面操作),实现三者之间的无缝集成。

- 零样本学习: ShowUI在零样本屏幕截图定位任务中表现出色,能够在没有额外训练数据的情况下识别和执行任务。

- 跨平台导航: 模型在网页、移动设备和在线环境中均展现出有效的导航能力,显示了其跨平台的适用性。

- 数据集优化: 通过精心策划和重采样策略,ShowUI能够处理不平衡的数据类型,提高模型性能。

ShowUI技术原理

- UI-Guided Visual Token Selection:

- 将屏幕截图视为UI连接图,通过识别视觉元素的冗余关系来减少计算成本。

- 在自注意力模块中,根据UI连接图选择性地处理视觉令牌,以提高效率。

- Interleaved Vision-Language-Action Streaming:

- 结构化GUI动作,并以JSON格式记录,以标准化不同设备上的动作。

- 通过交替处理视觉和动作信息,管理复杂的交互历史,提高训练效率。

- Well-selected Instruction-following Dataset:

- 通过深入分析数据类型,选择代表性的GUI数据集进行训练。

- 引入重采样策略,平衡不同数据类型在训练中的比例,确保模型在不同设置下的性能一致性。

- Efficient Visual Modeling:

- 利用UI连接图减少冗余的视觉令牌,同时保留关键的视觉元素,以优化模型处理高分辨率图像的能力。

- Modeling Actions with Visual and Query Data:

- 将动作与视觉数据和查询数据结合,使模型能够理解动作与视觉元素之间的关系,并在多轮对话中预测动作。

- Zero-Shot Screenshot Grounding:

- 利用轻量级的2B模型和256K数据实现75.1%的准确率,展示了在没有额外训练数据的情况下执行任务的能力。

ShowUI应用场景

- 网页自动化操作: ShowUI可以自动执行网页上的点击、输入等操作,如填写表单、购买商品或浏览内容,提高网页交互的自动化水平。

- 移动应用测试: 在移动应用测试中,ShowUI能够模拟用户操作,如点击按钮、滑动页面,帮助开发者发现界面问题和改进用户体验。

- 桌面软件交互: ShowUI能够与桌面软件的图形界面进行交互,执行如打开文件、编辑文档等任务,提升工作效率。

- 在线客服助手: 通过理解用户的问题和操作指令,ShowUI可以在在线客服系统中自动引导用户解决问题,减少客服工作量。

- 智能助手开发: ShowUI可以集成到智能助手中,帮助用户通过语音或文本命令控制智能家居设备,实现更智能的家居自动化。

- 教育和培训模拟: 在教育领域,ShowUI可以模拟软件操作流程,为学生提供交互式学习体验,尤其在编程和设计软件的教学中。

ShowUI项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号