OneDiffusion:能够实现图像合成和理解的双向任务

OneDiffusion简介

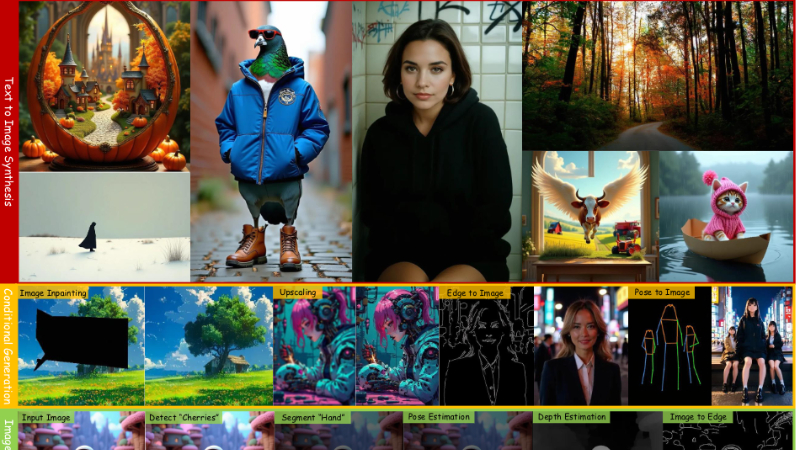

OneDiffusion是由AI2团队开发的一款多功能大规模扩散模型,它能够实现图像合成和理解的双向任务,覆盖文本到图像的生成、条件图像生成、图像理解等多个领域。该模型通过将所有任务视作具有不同噪声尺度的帧序列,支持多任务训练,并能适应任意分辨率,展现出在文本到图像、多视图生成等任务上的强大性能。OneDiffusion的代码和模型权重已在GitHub上公开,供研究和应用使用。

OneDiffusion主要功能

- 文本到图像合成:根据文本提示生成相应的图像。

- 条件图像生成:基于输入图像和其他条件(如深度、姿态)生成新的图像。

- 图像理解:执行如深度估计、图像分割等理解任务。

- 多视图生成:从单一视图生成多个不同视角的图像。

- 即时个性化:使用序列图像输入进行个性化生成。

- ID定制化:根据特定身份信息定制图像。

OneDiffusion技术原理

- 流匹配:通过学习时间依赖的向量场来转换概率分布,用于训练连续时间生成模型。

- 序列建模:将所有条件和目标图像建模为具有不同噪声水平的“视图”序列。

- 灵活的框架:允许在推理时选择任意子集的视图作为条件生成剩余视图。

- 训练流程:独立采样不同噪声水平的视图,并应用基于插值的前向过程。

- 推理流程:初始化目标视图为高斯噪声,通过时间依赖的向量场生成感兴趣的条件样本。

- 模型架构:采用基于Transformer的架构,支持不同数量的视图,使用VAE tokenizer独立编码每个图像和条件。

- 3D RoPE:用于位置编码,以支持不同分辨率和宽高比的图像生成。

OneDiffusion应用场景

- 艺术创作与设计:利用文本描述生成创意图像,辅助艺术家和设计师快速实现视觉概念。

- 广告与营销:根据产品特点或营销文案生成吸引人的广告图像,提高广告的吸引力和效果。

- 游戏开发:生成游戏内的角色、场景和物品图像,加速游戏资产的创建过程。

- 虚拟现实与增强现实:在VR/AR应用中生成逼真的三维图像和环境,提升用户体验。

- 媒体与娱乐:为电影、电视剧制作提供快速原型设计,包括场景重建和特效预览。

- 教育与培训:生成教学材料中的图像,如历史场景重现,帮助学生更好地理解和学习。

OneDiffusion项目入口

- GitHub代码库:https://github.com/lehduong/OneDiffusion/

- arXiv技术论文:https://arxiv.org/pdf/2411.16318

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号