Generative Omnimatte:谷歌推出的的视频分解技术

Generative Omnimatte简介

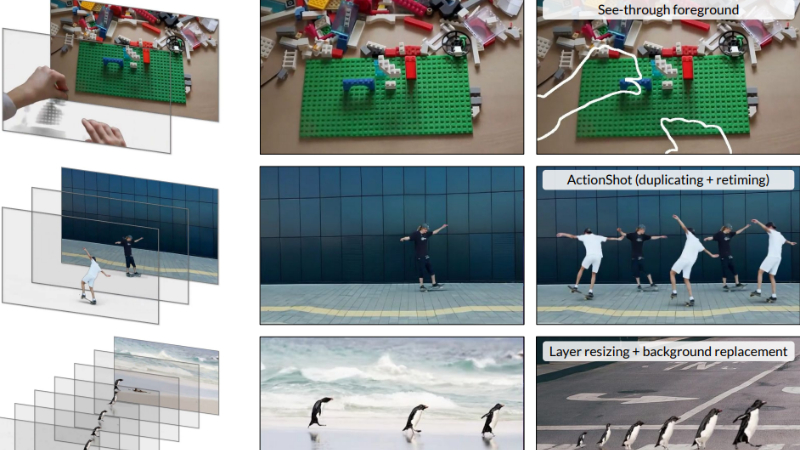

Generative Omnimatte是由Google DeepMind团队开发的一种创新视频分解技术,它能够将视频解析成包含独立对象及其相关效果(如阴影和反射)的RGBA omnimatte层。这一方法通过引入生成式视频先验,改进了现有工作,使其能够在不依赖静态背景或精确相机姿态估计的情况下,完成被遮挡区域的动态效果,并处理复杂场景。该技术为视频编辑和视觉效果制作提供了新的可能,允许用户进行对象移除、层编辑和动作复制等多种创意操作。

Generative Omnimatte主要功能

- 视频分解:将视频分解成多个语义层,每个层包含一个完整的对象及其相关效果,如阴影和反射。

- 对象移除:从视频中移除指定对象,并保留其相关的视觉效果,如阴影和反射。

- 层编辑:允许对分离出来的每个视频层进行编辑,包括调整大小、替换背景、改变动作等。

- 动作复制和重定时:复制视频中的动作并调整其速度,实现动作的重定时。

- 动态背景处理:能够处理动态背景的视频,无需假设背景是静态的。

- 不完全遮挡区域的完成:对于被遮挡的对象,能够生成完整的视频层。

Generative Omnimatte技术原理

- 生成式视频先验:利用预训练的视频扩散模型,该模型内部特征揭示了对象与其效果之间的联系,可以通过微调来暴露这些联系。

- 对象效果去除模型(Casper):基于视频修复模型微调而来,用于识别和移除特定对象及其效果。

- Trimask条件:使用三值掩码(trimask)来指定保留区域、移除区域以及可能包含不确定对象效果的区域。

- 两步重建过程:

- 第一步:创建干净的背景视频和单对象视频。

- 第二步:通过测试时优化从这些视频中重建前景层。

- 自注意力模式分析:通过分析预训练模型的自注意力权重,确认模型能够关联对象和它们的效果。

- 训练数据集:使用真实和合成的视频数据集进行微调,包括Omnimatte、Tripod、Kubric和Object-Paste数据。

- 优化和重建:使用U-Net生成平滑的alpha通道,并直接优化RGB值以提高效率,同时应用稀疏正则化和掩码监督损失来优化alpha网络。

- 分辨率提升和细节转移:使用Lumiere的SSR阶段上采样基础模型输出,并应用细节转移步骤以增强完全不透明区域的细节。

Generative Omnimatte应用场景

- 电影和视频制作:在电影后期制作中,用于分离和编辑电影场景中的特定对象,如移除不需要的物体或添加特效。

- 视频剪辑:在视频剪辑中,允许编辑者移除或替换视频中的元素,例如替换产品展示视频中的背景或移除穿帮镜头。

- 增强现实(AR):在AR应用中,将现实世界的对象与虚拟信息结合,如在实景中添加虚拟广告或游戏元素。

- 交互式媒体:在交互式媒体中,用户可以与视频内容互动,例如在音乐视频中分离和重新编排表演者。

- 安全监控:在监控视频中移除遮挡物或干扰元素,以便更清晰地识别和追踪目标。

- 教育和培训:在教育视频中,通过分离和强调特定对象或效果,提高学习材料的互动性和教育效果。

Generative Omnimatte项目入口

- 项目主页:https://gen-omnimatte.github.io/

- arXiv研究论文:https://arxiv.org/pdf/2411.16683

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号