EfficientTAM:Meta AI团队推出的轻量级视频对象分割和跟踪模型

EfficientTAM简介

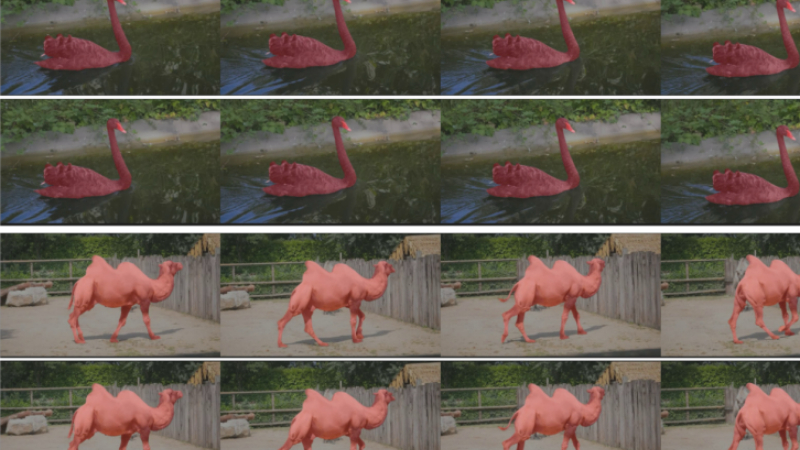

EfficientTAM是由Meta AI团队开发的一种轻量级视频对象分割和跟踪模型,旨在解决现有技术在移动设备上应用时面临的高计算复杂性问题。该模型通过采用非层次化的Vision Transformer作为图像编码器,并引入一个高效的内存模块,显著降低了计算复杂性,同时保持了与SAM 2相当的性能。EfficientTAM在多个视频分割基准测试中展现出优异的效率和准确性,能够在移动设备上以合理的质量运行视频对象分割,具有实际部署的潜力。

EfficientTAM主要功能

- 视频对象分割:EfficientTAM能够识别和分割视频中的特定对象,即使在复杂场景中也能准确地跟踪和分割目标对象。

- 实时跟踪:模型能够在视频帧之间保持对目标对象的一致性跟踪,即使对象发生移动或被遮挡。

- 轻量化设计:专为移动和资源受限的环境设计,以低延迟和较小的模型大小实现高质量的分割结果。

- 高效计算:通过优化的算法减少了计算资源的需求,使得模型能够在移动设备上实时运行。

- 跨平台部署:能够在不同的硬件平台上部署,包括高端服务器(如NVIDIA A100 GPU)和移动设备(如iPhone)。

EfficientTAM技术原理

- 非层次化Vision Transformer(ViT):EfficientTAM使用轻量级的ViT作为图像编码器,与传统的层次化编码器相比,ViT提供了更高效的特征提取。

- 高效记忆模块:通过利用记忆空间令牌的局部性,EfficientTAM提出了一种高效的跨注意力方法,减少了记忆计算的复杂性。

- 特征提取优化:采用14×14非重叠窗口注意力和4个等间距全局注意力块,EfficientTAM能够高效地从高分辨率帧中提取特征。

- 粗化表示(Coarse Representation):通过平均池化操作,EfficientTAM将记忆空间令牌粗化为更少的代表性令牌,以减少计算量。

- 跨注意力近似:EfficientTAM提出了一种近似的跨注意力机制,通过构建粗化记忆令牌的代理来近似原始的跨注意力操作,从而减少计算成本。

- 模型训练和优化:在大规模数据集上进行预训练和微调,使用AdamW优化器和特定的学习率调度策略,以及损失函数的组合来优化模型性能。

- 输入分辨率调整:EfficientTAM支持不同输入分辨率的调整,以平衡性能和效率,特别是在资源受限的移动设备上。

EfficientTAM应用场景

- 移动视频编辑:用户可以在智能手机上直接对视频进行对象分割和编辑,如替换背景或突出特定人物。

- 监控安全:实时跟踪监控视频中的特定对象,如行人或车辆,以提高安全监控的效率和响应速度。

- 增强现实(AR):在AR应用中,对现实世界中的对象进行实时分割,为用户提供更丰富的交互体验和信息叠加。

- 自动驾驶:在自动驾驶系统中,对车辆、行人和其他道路使用者进行精确分割和跟踪,以提高导航和避障的准确性。

- 医疗影像分析:在医疗影像中分割和跟踪器官或病变区域,辅助医生进行诊断和治疗规划。

- 工业自动化:在生产线上对产品进行质量检测,通过分割和跟踪产品来识别缺陷或异常,提高生产效率和产品质量。

EfficientTAM项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号