One Shot, One Talk:单张图片生成全身可动虚拟人像技术

One Shot, One Talk简介

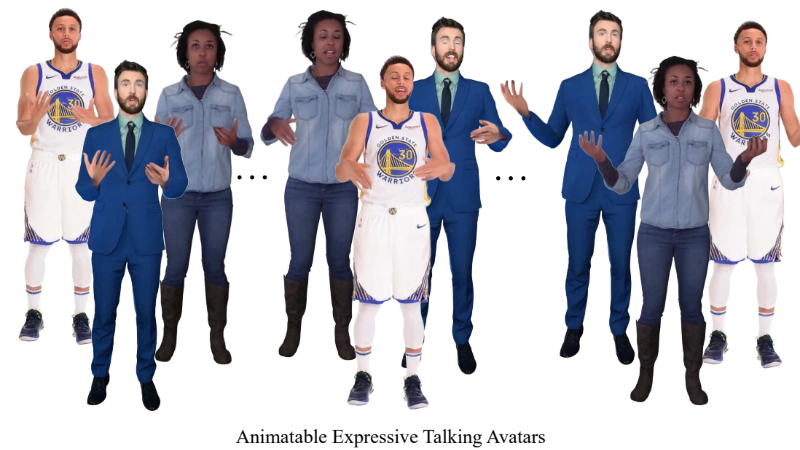

“One Shot, One Talk”是一种创新技术,能够从单张图片中创建出全身可动、表情丰富的虚拟人像。这项技术通过结合姿势引导的图像到视频扩散模型和3DGS-网格混合虚拟人像表示,解决了动态建模的复杂性和对新手势及表情的泛化问题。它不仅能够捕捉个性化细节,还支持逼真的动画效果,包括生动的肢体动作和自然的表情变化,为AR/VR应用如远程会议提供了巨大的潜力。

One Shot, One Talk主要功能

- 全身动态建模:能够从单张图片重建一个包含身体、手部和面部动作的全身虚拟人像。

- 真实感渲染:生成的虚拟人像能够进行真实感渲染,包括动态的服装和表情。

- 精确控制手势和表情:用户可以精确控制虚拟人像的手势和面部表情。

- 自然动画生成:支持生成具有自然表情变化和生动身体动作的动画。

- 单图像输入:只需要单张图片即可创建虚拟人像,降低了数据采集的复杂性和成本。

One Shot, One Talk技术原理

- 姿势引导的图像到视频扩散模型:利用这种模型生成不完美但可用的视频帧作为伪标签,帮助训练虚拟人像模型。

- 3DGS-网格混合虚拟人像表示:结合3D高斯模型(3DGS)和参数化网格模型(如SMPL-X),以增强表达力和真实感。

- 关键正则化技术:应用拉普拉斯平滑和法线一致性正则化,以减少由不完美标签引起的不一致性。

- 感知损失和像素级损失:使用感知损失(如LPIPS)和像素级损失(如L1损失)来训练模型,确保生成的虚拟人像在外观上与输入图像保持一致。

- TED Gesture Dataset:使用TED Gesture Dataset构建全身运动空间,为虚拟人像提供多样化的手势和表情。

- 预训练模型:使用预训练的全身视频扩散模型和3D面部动画模型来驱动输入单张图片,生成多样化的动态视频序列。

- 优化和训练:通过Adam优化器进行模型训练,使用特定的学习率和损失权重来优化模型性能。

- 跨身份动画:通过SMPL-X模型和3DGS-网格耦合表示,实现不同身份特征的准确动画驱动。

One Shot, One Talk应用场景

- 虚拟会议:在远程会议中创建真实感的虚拟人像,增强参与者的互动体验。

- 在线教育:为在线课程提供生动的虚拟讲师,提升学生的学习兴趣和参与度。

- 社交媒体:允许用户生成个性化的虚拟形象,用于社交平台的互动和内容创作。

- 游戏开发:为游戏角色提供动态表情和动作,使游戏体验更加真实和沉浸。

- 影视制作:在影视特效中使用虚拟人像,降低拍摄成本并提升制作效率。

- 虚拟助手:创建个性化的虚拟助手形象,提供更具人性化的用户交互体验。

One Shot, One Talk项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号