MEMO:根据输入的音频和参考图像生成逼真的说话视频

MEMO简介

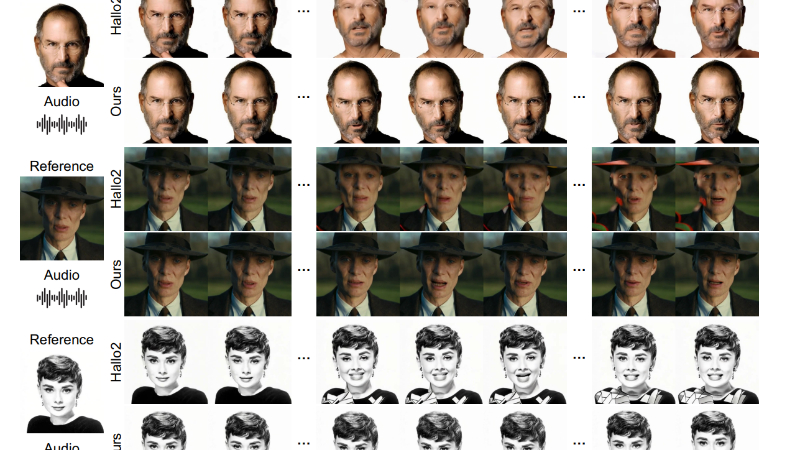

MEMO(Memory-guided EMOtionaware diffusion)是由Skywork AI与南洋理工大学以及新加坡国立大学合作开发的一种先进的音频驱动的肖像动画方法,旨在生成具有身份一致性和表情丰富性的逼真说话视频。该技术通过记忆引导的时间模块和情感感知的音频模块,有效提升了视频的长期身份一致性、音频-唇形同步以及表情与音频情感的对齐,超越了现有的视频生成方法。

MEMO主要功能

- 音频驱动的视频生成:MEMO能够根据输入的音频和参考图像生成逼真的说话视频。

- 身份一致性:在视频生成过程中保持与参考图像的长期身份一致性。

- 音频-唇形同步:确保生成的视频与输入音频在唇形动作上高度同步。

- 自然表情生成:视频中的角色表情与音频中的情感基调自然对齐。

- 多模态交互:通过音频和视频的深度交互提升生成视频的真实感和表现力。

MEMO技术原理

- 记忆引导的时间模块:

- 记忆状态:开发记忆状态以存储更长时间过去上下文的信息,用于指导时间建模。

- 线性注意力:使用线性注意力机制替代自注意力,以高效处理长期时间信息。

- 记忆更新机制:引入记忆更新机制,以衰减因子调制过去帧的影响,实现长期依赖关系的捕捉。

- 情感感知的音频模块:

- 多模态注意力:替代传统的交叉注意力,实现音频和视频输入的联合处理。

- 音频情感检测:动态检测音频中的情感线索,以情感嵌入的形式指导多模态注意力。

- 情感自适应层归一化:通过情感自适应层归一化细化面部表情,以实现与音频情感的对齐。

- 数据预处理流程:

- 场景转换检测:基于TransNet V2进行场景转换检测,裁剪视频片段。

- 人脸检测与裁剪:使用Grounding DINO进行人脸检测,提取人头。

- 图像质量评估:利用HyperIQA模型过滤低质量和低分辨率视频。

- 音频-唇形同步检测:使用SyncNet过滤音频-唇形不同步的视频片段。

- 训练策略分解:

- 面部领域适应:初始化参考网络和扩散网络的空间模块,适应面部特征。

- 情感解耦训练:在训练阶段,将参考图像的情感与音频情感解耦,以更好地细化面部表情。

MEMO应用场景

- 虚拟主播:在新闻播报或直播中,使用MEMO生成的虚拟形象可以24小时不间断地进行内容播报。

- 在线教育:创建虚拟教师形象,提供个性化和互动性强的在线学习体验。

- 娱乐与游戏:在视频游戏或虚拟现实中,MEMO可以生成逼真的角色动画,增强沉浸感。

- 社交媒体:用户可以利用MEMO生成自己的虚拟形象,用于视频内容创作和社交媒体互动。

- 客户服务:在客户服务领域,MEMO可以用于生成客服代表的虚拟形象,提供更亲切的客户体验。

- 电影和视频制作:在电影后期制作中,MEMO可以用于生成或替换角色的面部表情和口型,降低制作成本。

MEMO项目入口

- 项目主页:https://memoavatar.github.io/

- GitHub代码库:https://github.com/memoavatar/memo

- HuggingFace:https://huggingface.co/memoavatar/memo

- arXiv技术论文:https://arxiv.org/pdf/2412.04448

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号