CLEAR:提高预训练扩散变换器在超分辨率图像生成中的效率

CLEAR简介

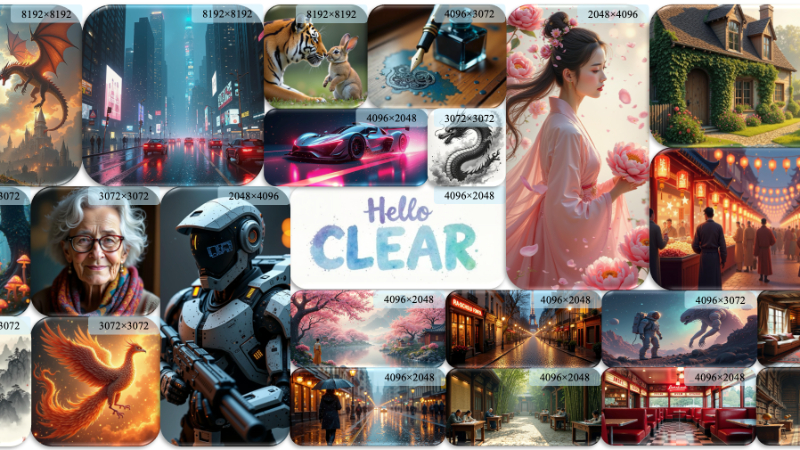

CLEAR是一种线性注意力机制,由新加坡国立大学的研究团队开发,旨在提高预训练扩散变换器(DiTs)在高分辨率图像生成任务中的效率。通过引入局部性、公式一致性、高秩注意力图和特征完整性四个关键因素,CLEAR策略将注意力计算的复杂度从二次降低到线性,显著减少了生成高分辨率图像时的延迟。该方法仅需在少量自生成样本上进行微调,便能实现与原始模型相媲美的性能,同时大幅降低计算资源消耗,为图像生成领域带来了突破性进展。

CLEAR主要功能

- 提高图像生成效率: CLEAR的主要功能是提高预训练DiTs在生成高分辨率图像时的效率,减少计算延迟。

- 降低计算复杂度: 通过线性注意力机制,CLEAR将DiTs的计算复杂度从二次降低到线性,适应高分辨率图像生成的需求。

- 保持生成质量: 在降低复杂度的同时,CLEAR能够保持与原始DiTs相当的图像生成质量。

- 跨分辨率泛化能力: CLEAR能够适应不同分辨率的图像生成,展现出良好的泛化能力。

- 跨模型/插件泛化: CLEAR训练得到的注意力层可以零样本地应用于其他DiTs模型和插件,无需额外适配。

- 支持多GPU并行推理: CLEAR的设计允许在多GPU环境下进行高效的并行推理,进一步提升处理速度。

CLEAR技术原理

- 线性注意力机制: CLEAR通过限制每个查询令牌仅与局部窗口内的键值令牌进行交互,实现了线性复杂度的注意力计算。

- 局部性(Locality): CLEAR仅考虑查询令牌周围的局部区域,这与预训练DiTs依赖局部特征管理令牌关系的特性相一致。

- 公式一致性(Formulation Consistency): CLEAR保持了与原始softmax-based attention相同的公式结构,以维持模型功能一致性。

- 高秩注意力图(High-Rank Attention Maps): CLEAR生成的注意力图能够捕捉复杂的令牌间关系,不假设注意力图的低秩性质。

- 特征完整性(Feature Integrity): CLEAR倾向于使用原始的查询、键和值特征,而不是压缩后的特征,以保持特征的完整性。

- 知识蒸馏(Knowledge Distillation): 在微调过程中,CLEAR使用知识蒸馏目标,以保持与原始DiTs在预测和注意力输出上的一致性。

- 多GPU并行推理优化: CLEAR通过局部注意力计算和特定的聚合策略,减少了多GPU并行推理时的通信开销。

CLEAR应用场景

- 高分辨率图像合成:CLEAR可以用于生成高分辨率的图像,如8K分辨率的图像,适用于需要超高清视觉效果的场景,例如电影制作和游戏开发中的高质量图像渲染。

- 虚拟现实内容创建:在虚拟现实应用中,CLEAR能够快速生成逼真的图像,提升虚拟环境的真实感和沉浸式体验。

- 艺术创作与数字绘画:艺术家和设计师可以利用CLEAR生成高分辨率的艺术作品,提高创作效率,实现更细腻的视觉表现。

- 广告与品牌视觉设计:CLEAR能够快速生成具有吸引力的高分辨率广告图像,帮助品牌在竞争激烈的市场中脱颖而出。

- 数据可视化:在需要将复杂数据以图像形式呈现的场景中,CLEAR可以生成清晰、详细的图表和信息图,提高数据的可读性和吸引力。

- 在线媒体与社交媒体:内容创作者和社交媒体平台可以利用CLEAR生成高质量的图像和视觉内容,吸引和保持用户的注意力。

CLEAR项目入口

- GitHub代码库:https://github.com/Huage001/CLEAR

- arXiv技术论文:https://arxiv.org/pdf/2412.16112

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号