RLCM:快速从文本提示生成高质量图像 显著减少推理时间

RLCM简介

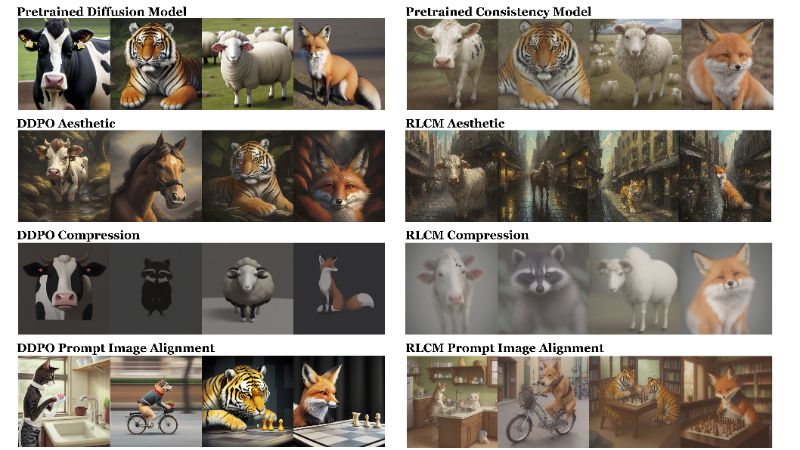

RLCM是由康奈尔大学计算机科学系的团队开发的一种新型强化学习框架,旨在通过直接优化奖励函数来微调一致性模型,实现快速的文本到图像的生成。该框架通过将一致性模型的推理过程建模为马尔可夫决策过程,显著提高了训练和推理速度,同时在多个任务中展现出优于现有方法的性能。RLCM不仅能够适应难以通过提示表达的目标,还保持了生成图像的高质量,是文本到图像生成领域的一项重要进展。

RLCM主要功能

- 快速文本到图像生成:RLCM能够快速从文本提示生成高质量图像,显著减少推理时间。

- 任务特定奖励优化:框架通过优化与特定任务相关的奖励函数来微调一致性模型,以适应不同的生成目标。

- 强化学习微调:使用强化学习(RL)方法对一致性模型进行微调,以提高生成图像与文本提示的对齐度。

- 多任务性能:RLCM在多个任务上表现出色,包括图像压缩性、不可压缩性、美学质量和文本图像对齐。

RLCM技术原理

- 一致性模型:RLCM基于一致性模型,这类模型能够直接将噪声映射到数据,减少了生成过程中的迭代步骤。

- 马尔可夫决策过程(MDP):将一致性模型的推理过程建模为一个多步MDP,允许使用RL技术进行优化。

- 策略梯度算法:RLCM使用策略梯度算法来优化模型,这使得它可以处理非可微的奖励函数。

- 快速训练和推理:由于MDP的较短时间范围,RLCM能够实现快速的在线数据生成和策略优化,从而加快训练速度。

- 奖励函数:RLCM通过奖励函数来指导图像生成,使其能够针对特定任务进行优化,如图像的美学质量或压缩性。

- 迭代推理过程:在一致性模型中,通过迭代推理过程逐步改善图像质量,RLCM通过RL来优化这一过程,以提高生成效率和质量。

RLCM应用场景

- 艺术创作辅助:利用RLCM快速生成与文本描述相匹配的艺术风格图像,辅助艺术家和设计师进行创作。

- 广告和营销:根据产品描述或营销文案生成吸引人的广告图像,提高广告的吸引力和效果。

- 游戏开发:在游戏设计中,根据文本提示快速生成游戏环境、角色或道具的图像,加速游戏开发流程。

- 虚拟试衣:在电子商务中,根据用户选择的服装描述生成虚拟试穿图像,提升在线购物体验。

- 教育和培训:生成与教学内容相关的图像,如历史场景重现或科学概念可视化,增强学习材料的吸引力和教育效果。

- 媒体和娱乐:在电影和视频制作中,根据剧本或故事板快速生成概念艺术,辅助前期制作和视觉效果设计。

RLCM项目入口

- 项目主页:https://rlcm.owenoertell.com/

- GitHub代码库:https://github.com/Owen-Oertell/rlcm

- arXiv技术论文:https://arxiv.org/pdf/2404.03673

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号