VideoAnydoor:香港大学联合阿里达摩院等推出的视频对象插入框架

VideoAnydoor简介

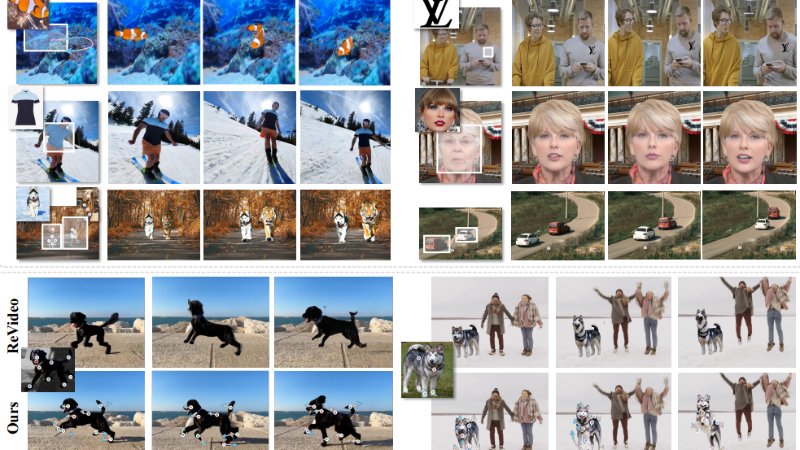

VideoAnydoor是由香港大学和阿里巴巴达摩院等机构联合开发的一个先进视频对象插入框架,它能够在视频中以高保真度插入给定对象,并实现精确的运动控制。该框架采用零样本学习方法,通过结合文本到视频的模型和ID提取器,以及一个创新的像素变形器技术,使得用户能够轻松控制对象的运动轨迹,同时保持对象细节和视频中未编辑区域的原始外观。VideoAnydoor在多个应用场景中展现出色性能,包括视频虚拟试穿、面部交换和多区域编辑等,无需针对特定任务的微调。

VideoAnydoor主要功能

- 高保真度视频对象插入:能够在视频中无缝地放置特定对象,并保持对象的外观细节。

- 精确运动控制:用户可以控制插入对象的运动轨迹,实现与视频内容的协调一致。

- 零样本学习:无需特定任务的微调,即可在多种应用场景中使用。

- 多区域编辑支持:允许对视频中的多个区域进行编辑,包括对象交换和插入。

- 下游应用广泛:适用于视频虚拟试穿、视频面部交换等多种实际应用。

VideoAnydoor技术原理

- 文本到视频模型:作为起点,将随机噪声、对象掩码和掩码视频作为输入,生成期望的合成视频内容。

- ID提取器:从无背景的参考图像中提取紧凑且具有区分性的ID标记,以保持对象的身份信息。

- 像素变形器(Pixel Warper):接收带有任意关键点的参考图像和相应的关键点轨迹,根据轨迹变形像素细节,并与扩散U-Net融合,以改善细节保留和运动控制。

- 框序列控制:使用框序列作为身份和运动的粗略指导,生成期望的合成视频。

- 扩散U-Net:与变形后的像素特征融合,以支持用户操作运动轨迹。

- 重新加权重建损失:通过区分边界框内外区域的贡献,增强关键点和轨迹周围区域的学习,同时保留原始扩散损失。

- 图像-视频混合训练策略:结合真实视频和图像模拟视频进行训练,以补偿高质量视频数据的稀缺性。

- 跨注意力模块:用于融合轨迹图和参考图像的特征,实现语义感知的融合。

- ControlNet:提取多尺度中间特征,用于运动和身份的精细注入。

VideoAnydoor应用场景

- 视频虚拟试穿:用户可以在视频中尝试不同的服装样式,无需实际穿戴,即可预览服装效果。

- 视频面部交换:在视频会议或娱乐内容中,用户可以替换或变换面部图像,增加互动性和趣味性。

- 视频内容编辑:允许编辑视频内容,如替换或添加特定对象,用于电影制作或广告插入。

- 多区域视频编辑:在复杂的视频场景中,对多个区域进行精确控制和编辑,实现更丰富的视觉效果。

- 视频对象替换:在历史影像修复或特效制作中,替换视频中的特定对象,如更换标志或移除不需要的元素。

- 视频增强现实:在增强现实应用中,将虚拟对象精确地融入真实世界的视频流中,提升用户体验。

VideoAnydoor项目入口

- 项目主页:https://videoanydoor.github.io/

- arXiv技术论文:https://arxiv.org/pdf/2501.01427

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号