VITA-1.5简介

VITA-1.5 是一款开源的多模态大型语言模型,旨在实现视频、图像、文本和音频模态的无缝融合与交互。基于 Mixtral 8×7B 语言模型,VITA-1.5 通过扩展中文词汇和双语指令微调,增强了其多语言理解能力。通过两阶段多任务学习,模型不仅具备了强大的多模态基础理解能力,还实现了无需唤醒词的交互和音频打断交互功能,显著提升了人机交互的自然性和灵活性。VITA-1.5 的开源特性为学术界和工业界提供了一个强大的多模态研究与应用平台,尽管其在某些方面与闭源模型相比仍有提升空间,但其在多模态理解和交互方面的创新为后续研究奠定了坚实基础.

VITA-1.5主要功能

- 多模态输入处理:能够同时接收和处理视频、图像、文本和音频等多种模态的输入,实现跨模态的信息理解和融合.

- 多语言理解与交互:支持中文和英文两种语言,可以流畅地进行多语言对话和回答问题,满足不同语言场景下的交互需求.

- 无需唤醒词的交互:具备自动过滤背景噪音的能力,能够识别出有效的用户查询音频,无需用户说出特定的唤醒词或按下按钮即可激活和响应.

- 音频打断交互:允许用户随时打断模型的生成过程,提出新的问题,模型能够立即停止当前任务,整合历史上下文信息,并快速响应用户的最新查询.

VITA-1.5技术原理

- 语言基础模型扩展:以 Mixtral 8×7B 为起点,通过扩展其词汇量和使用双语文本语料库进行指令微调,增强了模型的多语言表达和理解能力,使其能够更准确地处理中英文混合的多模态输入.

- 多模态特征对齐:采用两阶段多任务学习策略,首先对视觉和音频编码器进行训练,使其能够将不同模态的特征与文本特征空间对齐,为后续的多模态理解和交互打下基础.

- 状态标记与查询识别:在多模态指令微调阶段,引入状态标记(state token),通过在训练数据中插入不同的状态标记,使模型能够自动识别输入查询的类型(如查询音频、噪声音频或查询文本),从而实现无需唤醒词的交互和音频打断交互功能.

- 双模型部署架构:在模型部署时,采用双模型架构,一个模型负责生成对用户查询的响应,另一个模型持续监测环境输入,当检测到新的有效音频查询时,能够迅速切换角色,暂停当前生成过程并输出对新查询的响应,从而实现高效的音频打断交互.

VITA-1.5应用场景

- 智能客服机器人:在电商平台、金融行业或企业服务中,VITA-1.5 可以作为智能客服机器人,通过理解用户的语音、文字和上传的图片、视频等信息,准确识别用户需求,提供个性化的解答和推荐,提升客户服务效率和质量.

- 教育辅助工具:在在线教育平台或学习应用中,VITA-1.5 能够辅助学生学习,例如通过分析学生上传的学习资料(如课本图片、教学视频等),结合学生的提问,提供知识点讲解、习题解答等服务,帮助学生更好地理解和掌握知识.

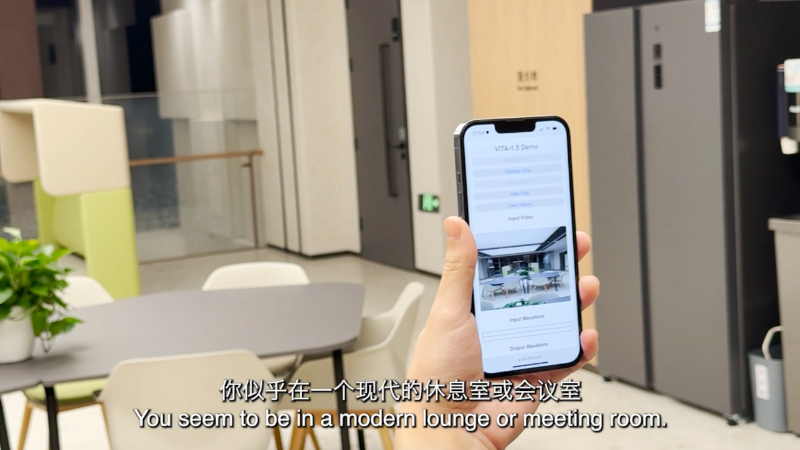

- 智能家居控制:在智能家居系统中,VITA-1.5 可以作为语音助手,用户可以通过语音指令控制家中的智能设备(如灯光、空调、电视等),同时,VITA-1.5 还能理解用户通过手机 App 发送的文字指令或上传的设备状态图片,实现更灵活的家居控制.

- 内容创作与审核:在媒体公司或自媒体平台,VITA-1.5 可以辅助内容创作者生成文章、视频脚本等,通过理解创作主题和风格要求,提供创意灵感和写作建议;同时,VITA-1.5 还能对上传的内容进行审核,识别其中的不合规信息(如违规图片、不当言论等),保障内容的合规性.

- 医疗健康咨询:在医疗健康领域,VITA-1.5 可以作为医疗健康咨询助手,通过分析用户的健康数据(如体检报告图片、健康监测视频等)和提问,提供健康建议、疾病预防知识等,辅助用户更好地管理自己的健康.

- 旅游信息查询与推荐:在旅游应用或景区服务中,VITA-1.5 能够根据用户的语音或文字查询,结合用户上传的旅游景点图片、视频等信息,提供景点介绍、旅游路线推荐、周边餐饮住宿信息等,帮助用户更好地规划和享受旅行体验.

VITA-1.5项目入口

- GitHub代码库:https://github.com/VITA-MLLM/VITA

- arXiv研究论文:https://arxiv.org/pdf/2408.05211

- Hugging Face模型:https://huggingface.co/VITA-MLLM

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号