VisionReward:清华联合智谱AI推出的视觉生成模型

VisionReward简介

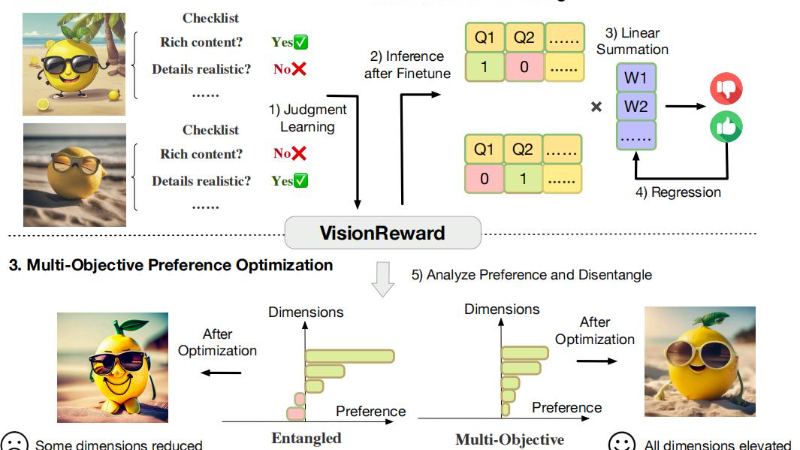

VisionReward是由清华大学和智谱AI的研究团队共同开发的视觉生成模型,旨在通过细粒度、多维度的人类偏好学习来对图像和视频生成模型进行对齐。该模型通过构建一个奖励模型,将人类对图像和视频的偏好分解为多个维度,并通过一系列判断性问题来量化这些偏好,最终通过线性加权求和得到一个可解释且准确的评分。VisionReward不仅在图像和视频评分方面超越了现有方法,还提出了一个多目标偏好学习算法(MPO),有效解决了偏好数据中的混杂因素问题,显著提升了视觉生成模型的性能。

VisionReward主要功能

-

人类偏好预测:VisionReward能够准确预测人类对图像和视频的偏好。它通过分解人类偏好为多个维度,并量化这些偏好,从而提供一个可解释且准确的评分系统。

-

多维度评估:该模型将人类偏好分解为多个维度,如对齐、构图、质量、保真度、安全性和情感等。每个维度通过一系列判断性问题来评估,使评估更加全面和细致。

-

视频质量评估:VisionReward特别擅长评估视频质量,能够处理视频的动态特性,如运动现实性和运动平滑性。它在这方面超越了现有的VideoScore模型,提高了17.2%的预测准确率。

-

优化视觉生成模型:基于VisionReward,研究团队开发了多目标偏好优化(MPO)算法,该算法能够稳定地优化视觉生成模型,避免过优化或优化不足的问题,显著提升了模型的性能。

VisionReward技术原理

-

细粒度和多维度偏好分解:

-

维度识别:识别出影响人类偏好的多个维度,如对齐、构图、质量、保真度、安全性和情感等。对于文本到图像生成,识别出5个维度;对于文本到视频生成,扩展到9个维度。

-

多选题设计:为每个维度设计多选题,允许标注者选择最符合图像或视频的选项。这些选项进一步分解为多个二元(是/否)问题,形成一个检查表,用于评估每个图像或视频。

-

-

数据标注和准备:

-

数据来源:从多个数据源采样,确保标注数据的多样性。图像数据来自ImageRewardDB、HPDv2和Pick-a-Pic等数据集;视频数据来自CogVideoX、Open-Sora和VideoCrafter2等数据集。

-

标注过程:通过细粒度的标注过程,编制了一个包含48k图像和33k视频的数据集,每个图像和视频都附带了详细的标注信息。

-

-

VisionReward训练:

-

检查表(Checklist):使用CogVLM2作为图像理解的基础模型,CogVLM2-Video作为视频理解的基础模型。通过平衡采样和指令微调数据集来训练模型,确保每个判断问题的正负样本数量大致相等。

-

线性加权求和(Linear Weighted Summarize):将“是”和“否”的回答映射到1和-1,构建特征向量,并使用线性权重来预测人类偏好。通过收集人类偏好数据集,计算特征差异,并使用逻辑回归模型来学习这些权重。

-

-

多目标偏好优化(MPO)算法:

-

问题定义:定义了如何通过VisionReward的奖励函数来选择图像或视频对。给定两个图像或视频,如果一个的奖励向量在所有维度上都不小于另一个,则认为它支配另一个。

-

优化过程:通过支配对来更新模型参数,确保每个维度的偏好不会被削弱。MPO算法通过这种方式,避免了在优化过程中某些维度的偏好被过度优化或削弱,从而实现了多目标优化。

-

VisionReward应用场景

-

内容创作:帮助内容创作者(如艺术家、设计师、视频制作者)生成更符合人类审美的图像和视频,提高作品的吸引力和质量。

-

广告营销:为广告公司和营销团队提供工具,生成更具吸引力和说服力的广告图像和视频,提升广告效果和用户参与度。

-

娱乐产业:在电影、电视剧、游戏等娱乐内容的制作中,用于生成高质量的视觉效果和动画,提升观众的视觉体验。

-

教育领域:辅助教育内容的制作,生成更生动、直观的教学图像和视频,提高学生的学习兴趣和效果。

-

社交媒体:帮助用户生成更优质、更具吸引力的社交媒体内容,增加内容的分享率和用户互动。

-

虚拟现实(VR)和增强现实(AR):在VR和AR应用中,生成更加真实和沉浸式的视觉内容,提升用户体验。

VisionReward项目入口

- GitHub代码库:https://github.com/THUDM/VisionReward

- arXiv研究论文:https://arxiv.org/pdf/2412.21059

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号