Sa2VA:融合了SAM2视频分割模型和LLaVA视觉语言模型

Sa2VA简介

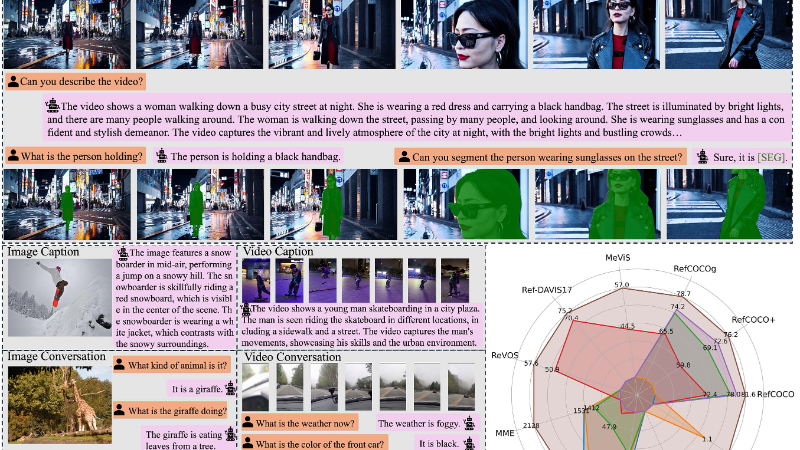

Sa2VA是一个创新的统一模型,它巧妙地融合了SAM2视频分割模型和LLaVA视觉语言模型,开创性地实现了对图像和视频的密集、基于文本的深入理解。这一模型通过单一指令调整,就能支持多种图像和视频任务,包括指代表达分割和对话,展现了强大的多功能性。Sa2VA的架构设计精巧,它利用LLMs的灵活token长度处理能力,将所有输入图像、视频和视觉提示视为视觉tokens,无需额外特定设计,通过联合训练,有效解决了基于文本的指令调整和对话任务之间的冲突。此外,Sa2VA还引入了解耦设计,冻结SAM2的解码器和记忆模块,既保留了SAM2的感知和跟踪能力,又使模型成为一个可插拔模块,能够与最新的MLLMs更新。在实验中,Sa2VA在多个图像和视频指代表达分割数据集以及聊天基准测试中取得了最先进的结果,特别是在Ref-SAV数据集上,其性能超越了以往的方法,充分展示了Sa2VA在复杂现实世界应用中的巨大潜力。

Sa2VA主要功能

-

图像和视频指代表达分割:给定一段描述特定对象的语言文本,Sa2VA能够准确地在图像或视频中分割出对应的对象区域。例如,根据描述“穿着红色连衣裙的女人”,从图像或视频中分割出该女人的轮廓。

-

图像和视频对话:Sa2VA可以与用户进行基于图像或视频内容的对话。用户可以询问图像或视频中的各种信息,如“图中的动物是什么?”或“视频中的人在做什么?”,Sa2VA能够给出准确的回答。

-

基于文本的标题生成:对于输入的图像或视频,Sa2VA能够生成描述其内容的标题或描述性文本,帮助用户快速了解图像或视频的主题和关键信息。

-

视觉提示理解:除了处理普通的文本和图像/视频输入,Sa2VA还能理解视觉提示,如图像中的特定区域或对象,并根据这些提示生成相应的分割掩码和文本描述。

Sa2VA技术原理

-

模型架构融合:

-

整合SAM2和LLaVA:Sa2VA将SAM2视频分割模型和LLaVA视觉语言模型相结合,创建了一个统一的框架。SAM2提供了强大的视频分割能力,能够生成精确的分割掩码;LLaVA则具备先进的视觉语言理解能力,能够处理复杂的语言指令和描述。

-

共享LLM token空间:Sa2VA将文本、图像和视频统一映射到一个共享的大型语言模型(LLM)token空间中,使得模型能够在一个统一的框架内处理多种模态的数据,实现跨模态的理解和交互。

-

-

指令调整与联合训练:

-

单一指令调整过程:Sa2VA将多种任务,如图像聊天、图像指代表达分割、视频聊天、视频对象分割和基于文本的标题生成等,都视为单一指令调整过程。通过利用LLMs的灵活token长度处理能力,将所有输入图像、视频和视觉提示视为视觉tokens,无需为每个任务设计特定的模型结构或调整策略。

-

多任务联合训练:模型采用多任务联合训练的方式,同时学习图像和视频的分割、对话以及标题生成等任务。这种联合训练方法能够有效解决基于文本的指令调整和对话任务之间的冲突,使模型在保持强大语言能力的同时,也具备出色的视觉理解能力。在训练过程中,模型通过优化一个综合损失函数,同时考虑文本预测损失、分割掩码损失等,实现了对多个任务的统一优化。

-

-

解耦设计与SEG token机制:

-

解耦设计:Sa2VA采用了解耦设计,将SAM2的解码器和记忆模块冻结,不将其输出tokens引入LLM。这样做的好处是简化了模型结构,避免了额外的计算成本和对齐过程,同时也使得Sa2VA能够作为一个可插拔模块,方便地与最新的MLLMs进行更新和替换。

-

SEG token引导分割:Sa2VA通过特殊的“[SEG]”token将LLM和SAM2的解码器连接起来。在训练和推理过程中,LLM会输出与“[SEG]”对应的隐藏状态,这些隐藏状态作为空间-时间提示输入到SAM2的解码器中,指导SAM2生成精确的分割掩码。这种设计充分利用了SAM2的分割能力和LLM的语言理解能力,实现了对静态和动态视觉内容的基于文本的精确分割。

-

-

Ref-SAV数据集与自动标注流程:

-

Ref-SAV数据集:为了提升模型在复杂视频场景中的指代表达分割性能,Sa2VA引入了Ref-SAV数据集。该数据集包含超过72k个对象表达,涵盖了复杂视频场景中的多种对象和表达方式。此外,还手动验证了2k个视频对象,为模型提供了一个高质量的基准测试数据集。

-

自动标注流程:Sa2VA设计了一个自动化的数据标注流程,用于生成SA-V数据集的指代表达对象文本表达。该流程分为三个阶段:对象/部件级标注、场景级标注和视频级标注。通过逐级细化和验证,生成了详细、准确的对象描述,为模型训练提供了丰富的标注数据,进一步提升了模型在复杂环境下的理解和分割能力。

-

Sa2VA应用场景

-

视频内容编辑:在视频制作过程中,Sa2VA可以帮助编辑人员快速定位和分割视频中的特定对象,如人物、动物或物品,以便进行特效添加、背景替换或对象移除等操作,提高视频编辑的效率和质量。

-

智能监控分析:在安防监控领域,Sa2VA能够实时分析监控视频,识别和跟踪特定目标,如入侵者或可疑物品,并及时发出警报。同时,它还可以根据预设的规则或指令,对监控场景进行语义理解,如检测异常行为或流量拥堵等。

-

自动驾驶辅助:对于自动驾驶系统,Sa2VA可以处理车载摄像头捕捉的图像和视频,实时识别道路标志、交通信号、行人和其他车辆等关键信息,为自动驾驶决策提供准确的视觉输入,增强车辆的安全性和可靠性。

-

虚拟现实(VR)和增强现实(AR):在VR和AR应用中,Sa2VA能够理解和分割用户视野中的虚拟或现实对象,实现更自然的交互体验。例如,在AR游戏中,根据玩家的指令快速识别和操作虚拟角色或道具,提升游戏的沉浸感和趣味性。

-

教育和培训:在教育领域,Sa2VA可以辅助教学视频的制作,根据教学内容自动标注和解释视频中的关键知识点或实验操作步骤,帮助学生更好地理解和学习。此外,它还可以用于在线培训,为学员提供实时的视觉反馈和指导。

-

医疗影像分析:虽然Sa2VA主要针对自然图像和视频,但其技术也可以拓展应用于医疗影像领域。例如,帮助医生分析医学影像,如X光、CT或MRI图像,快速定位病变区域或特定组织结构,辅助诊断和治疗规划。

Sa2VA项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号