Motion Dreamer:香港科技大学等推出的两阶段视频生成框架

Motion Dreamer简介

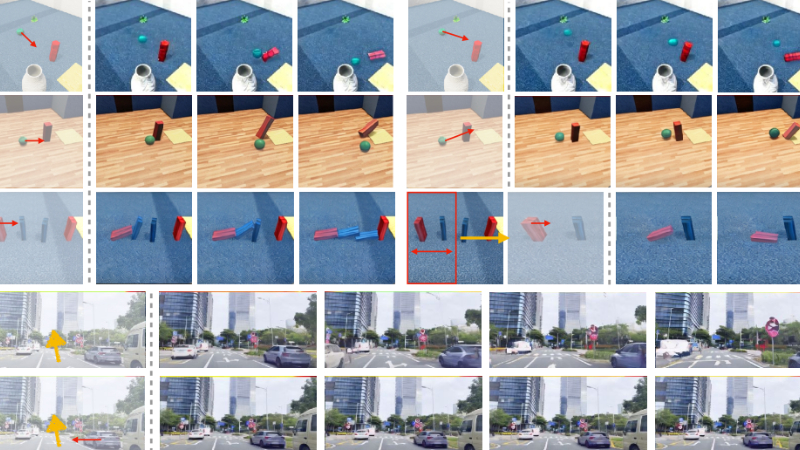

Motion Dreamer是由香港科技大学(广州)和诺亚方舟实验室的研究团队共同开发的一个创新的两阶段视频生成框架。该框架通过场景感知的运动推理,实现了物理上连贯的视频生成。Motion Dreamer的核心在于其独特的实例流(instance flow)技术,这是一种从稀疏到密集的运动模态,它允许用户通过简单的运动提示,如方向箭头,来控制视频中物体的运动。此外,该框架还引入了一种新颖的训练策略,通过随机掩蔽实例流来增强模型的推理能力,使其能够预测合理的运动轨迹。在Physion数据集和自动驾驶场景中的实验验证了Motion Dreamer在生成高质量、物理上合理的视频方面的能力,其性能优于现有的视频编辑和生成模型。该团队计划开源代码和数据集,以推动可控视频生成领域的发展。

Motion Dreamer主要功能

-

物理连贯的视频生成:能够基于初始帧和用户输入的运动提示,生成未来帧,这些帧在物理上是连贯的,遵循现实世界的物理规律。

-

场景感知的运动推理:通过分析场景中的物体运动和空间关系,模型可以推理出合理的运动轨迹,即使在复杂的交互场景中也能保持运动的逻辑性和物理合理性。

-

用户可控的视频生成:提供了一种直观的用户输入方式,允许用户通过稀疏的运动提示(如方向箭头)来控制视频中物体的运动,实现个性化的视频生成。

-

高质量视频合成:在保持运动连贯性的同时,生成具有丰富细节和高视觉质量的视频,适用于娱乐、虚拟现实、自动驾驶和机器人等领域。

Motion Dreamer技术原理

-

两阶段视频生成框架:

-

第一阶段:生成中间运动表示,如分割图、深度图等,专注于运动本身,捕获物体的运动和空间关系。

-

第二阶段:利用第一阶段生成的中间运动表示,生成最终的高细节视频,确保视频的视觉质量和运动连贯性。

-

-

实例流(Instance Flow):

-

训练时:计算每个物体的实例流,通过平均光流矢量来表示物体的运动,并在相应的物体掩码上传播这些矢量。

-

推理时:用户可以提供稀疏的运动提示,如方向箭头,结合实例分割掩码生成稀疏实例流,从而实现对特定物体运动的精细控制。

-

-

随机掩蔽训练策略:

-

在训练过程中,随机掩蔽部分实例流,要求模型根据不完整的运动信息重建完整的密集运动表示。这增强了模型的推理能力和泛化能力,使其能够处理稀疏输入并预测合理的运动轨迹。

-

-

运动增强损失(Motion Enhancement Loss):

-

通过定义运动掩码,保留具有显著运动的区域,并计算运动增强损失,确保生成的视频在这些区域与初始实例流保持一致,增强生成运动的保真度和连贯性。

-

-

视频解码器(Video Decoder):

-

利用预训练的SVD模型,将中间运动表示和初始帧作为条件,生成最终的RGB视频帧。视频解码器确保合成的帧在物体运动和空间一致性方面与初始帧和中间运动表示相匹配。

-

-

多尺度特征融合:

-

为了有效整合实例流,将实例流调整为不同尺度的特征图,并使用Softmax Splatting函数将特征图根据流场进行变形,将运动信息无缝整合到网络中,增强模型生成运动连贯中间表示的能力。

-

Motion Dreamer应用场景

-

自动驾驶模拟:生成各种驾驶场景的视频,用于训练和测试自动驾驶系统,提高其在复杂环境下的决策能力。

-

虚拟现实(VR)和增强现实(AR):创建逼真的虚拟环境和交互场景,提升用户的沉浸式体验。

-

娱乐和影视制作:生成特效视频、动画片段,降低制作成本,提高创作效率。

-

游戏开发:自动生成游戏中的动画和场景,丰富游戏内容,提升游戏的可玩性和视觉效果。

-

机器人仿真:模拟机器人在不同环境下的运动和交互,优化机器人的行为和路径规划。

-

教育和培训:生成教学视频,用于物理、工程等学科的教育,帮助学生更好地理解复杂的物理现象和机械运动。

Motion Dreamer项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号