LLaVA-Mini简介

LLaVA-Mini是由中国科学院计算技术研究所智能信息处理重点实验室、人工智能安全重点实验室以及中国科学院大学的研究团队共同开发的高效多模态模型。该模型通过模态预融合和压缩技术,将视觉输入压缩成极少量的视觉令牌,显著提高了计算效率,降低了响应延迟和GPU内存使用。在多个图像和视频理解基准测试中,LLaVA-Mini仅使用1个视觉令牌就达到了与使用576个视觉令牌的LLaVA-v1.5相当的性能,展现了其在实时多模态交互中的巨大潜力。

LLaVA-Mini主要功能

-

图像理解:

-

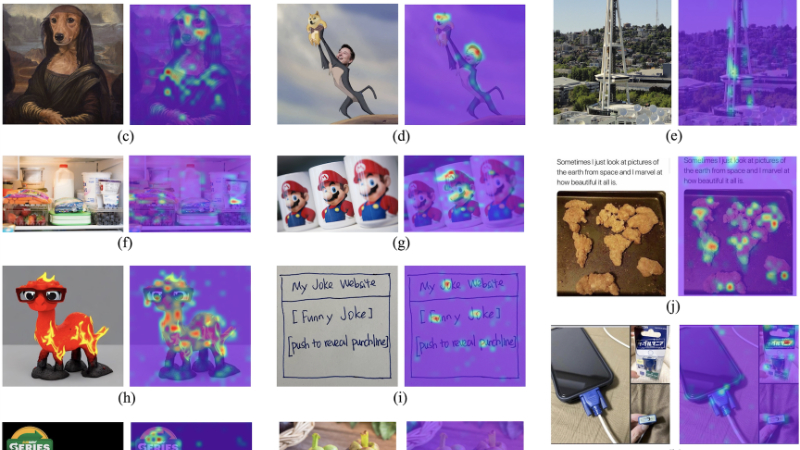

能够处理标准分辨率和高分辨率图像,通过将图像分割成子图像并分别处理,再融合全局和局部视觉信息,生成对图像内容的准确描述。

-

在多个图像基准测试中表现出色,如VQAv2、GQA等,能够准确回答有关图像内容的问题,识别图像中的物体、场景和活动。

-

-

视频理解:

-

可以处理长视频,通过每秒提取一帧图像并为每帧生成视觉令牌,再聚合这些令牌来理解视频内容。

-

在视频基准测试中,如MSVD-QA、MSRVTT-QA等,展现了优越的性能,能够准确回答视频相关问题,并生成详细的视频描述。

-

-

实时多模态交互:

-

由于其高效的计算能力和低延迟响应,LLaVA-Mini能够实现实时的多模态交互,为用户提供快速、准确的视觉和文本信息处理服务。

-

在处理高分辨率图像和长视频时,能够显著降低GPU内存使用,使得在资源受限的设备上也能高效运行。

-

LLaVA-Mini技术原理

-

模态预融合(Modality Pre-fusion):

-

在将视觉令牌输入到大型语言模型(LLM)之前,通过一个预融合模块将视觉信息提前融合到文本令牌中。

-

该模块由多个Transformer块组成,每个块的结构和超参数与LLM骨干网络相同,确保了视觉和文本信息的有效融合。

-

-

视觉令牌压缩(Vision Token Compression):

-

使用基于查询的压缩模块,通过交叉注意力机制选择性地提取重要的视觉信息,将多个视觉令牌压缩成一个或少数几个压缩视觉令牌。

-

引入2D正弦位置编码,以保留图像中的空间信息,确保压缩过程中视觉信息的完整性。

-

-

高效的视觉编码器(Efficient Vision Encoder):

-

使用预训练的CLIP视觉编码器提取图像特征,并通过投影层将这些特征映射到词嵌入空间,生成视觉令牌。

-

对于高分辨率图像,通过将图像分割成多个子图像并分别处理,再融合这些子图像的视觉令牌,生成更丰富的全局和局部视觉信息。

-

-

端到端训练(End-to-End Training):

-

LLaVA-Mini的训练过程分为两个阶段:视觉-语言预训练和指令微调。

-

在视觉-语言预训练阶段,模型学习对齐视觉和语言表示,主要训练投影模块,而视觉编码器和LLM保持冻结状态。

-

在指令微调阶段,模型基于最小视觉令牌执行各种视觉任务,引入压缩和模态预融合模块,并对所有模块(除了冻结的视觉编码器)进行端到端训练。

-

LLaVA-Mini应用场景

-

智能客服:能够理解和回答用户通过图像或视频提出的问题,提供更直观、准确的解答。

-

内容推荐:根据用户上传的图像或视频内容,推荐相关的文章、产品或服务。

-

教育辅导:辅助教学,通过图像和视频解释复杂的概念,提供更生动的学习体验。

-

医疗辅助:帮助医生分析医学影像,提供初步诊断建议,提高诊断效率。

-

安防监控:实时分析监控视频,自动检测异常行为或事件,提高安全防范能力。

-

智能驾驶:处理车辆摄像头捕捉的图像和视频,辅助驾驶决策,提高行车安全。

LLaVA-Mini项目入口

- GitHub代码库:https://github.com/ictnlp/LLaVA-Mini

- arXiv研究论文:https://arxiv.org/pdf/2501.03895

- Hugging Face模型:https://huggingface.co/ICTNLP/llava-mini-llama-3.1-8b

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号