Titans:Google开发的新型神经网络架构

Titans简介

Titans是由Google开发的一种新型神经网络架构,旨在通过引入长期记忆模块来提升模型在处理长序列数据时的性能。该架构通过学习在测试时记忆历史上下文,帮助注意力机制利用长期过去的信息,从而克服了传统Transformer在处理长序列时的扩展性限制。Titans架构包含三种变体,分别探讨了如何将记忆有效地整合到架构中,以实现更快的训练和更高的推理效率。实验结果表明,Titans在语言建模、常识推理、基因组学和时间序列预测等任务上均优于现有的Transformer和现代线性循环模型,展现了其在处理大规模数据集时的强大潜力。

Titans主要功能

-

处理长序列数据:Titans架构能够有效处理超过200万标记的长序列数据,这在传统的Transformer模型中是难以实现的,因为Transformer的计算成本随上下文长度呈二次方增长。

-

提高模型性能:在多种任务上,包括语言建模、常识推理、基因组学和时间序列预测等,Titans的性能优于现有的Transformer和现代线性循环模型。

-

增强记忆能力:通过引入神经长期记忆模块,Titans能够学习和记忆历史上下文信息,这对于需要长期依赖关系的任务尤为重要。

-

灵活的架构设计:Titans提供了三种变体(MAC、MAG、MAL),允许用户根据具体任务需求选择最适合的架构设计,以实现最佳性能。

Titans技术原理

-

神经长期记忆模块:

-

记忆存储:该模块能够在测试时学习如何将数据记忆存储到其参数中,类似于人类的长期记忆系统。它通过测量输入相对于关联记忆损失的神经网络梯度来定义输入的惊喜度,并据此更新记忆。

-

衰减机制:为了更好地管理有限的记忆,Titans引入了一种衰减机制,考虑记忆大小和数据惊喜的比例,从而更有效地管理记忆容量。

-

并行化训练:通过将训练过程张量化,利用硬件加速器(如TPUs和GPUs)进行并行计算,提高了训练效率。

-

-

注意力机制与记忆结合:

-

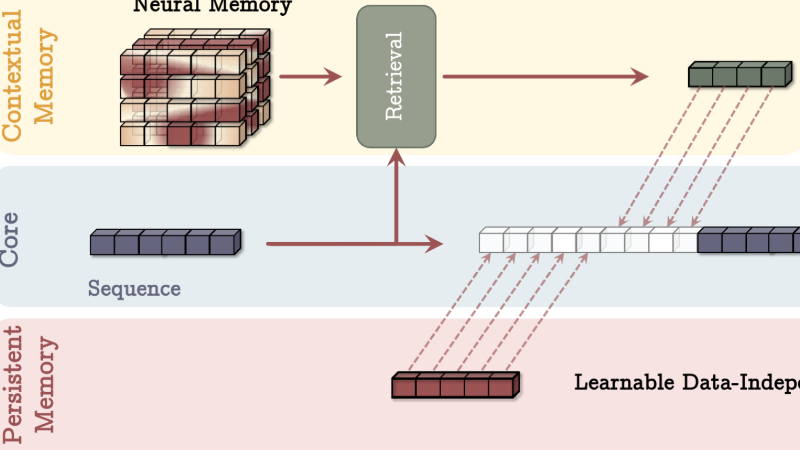

短期记忆与长期记忆:Titans将注意力机制视为短期记忆,负责处理当前上下文窗口内的信息,而神经长期记忆模块则负责存储和回忆长期历史信息。

-

多头架构:Titans的三种变体(MAC、MAG、MAL)分别探讨了如何将记忆模块与注意力机制结合,以实现不同的功能和性能优化。

-

MAC:将记忆作为当前信息的上下文,通过注意力机制决定是否需要长期记忆信息。

-

MAG:使用滑动窗口注意力作为短期记忆,神经记忆模块作为长期记忆,并通过门控机制结合两者。

-

MAL:将神经记忆模块作为深度神经网络的一层,先通过记忆层压缩过去和当前上下文,然后再应用注意力模块。

-

-

-

深度记忆模块:

-

多层结构:Titans的长期记忆模块采用多层结构(至少两层),这使得模型能够更有效地存储和回忆复杂的长期历史信息,与线性模型相比具有更高的表达能力。

-

动量更新规则:记忆更新规则基于动量,考虑了过去和当前的惊喜度,而不仅仅是当前的惊喜度,这有助于更好地管理记忆容量。

-

-

持续学习:

-

测试时学习:Titans的长期记忆模块在测试时仍然可以学习和更新,这意味着模型能够根据新的输入动态调整其记忆,从而提高泛化能力。

-

元学习:通过设计一个元模型,Titans能够在测试时学习如何记忆和遗忘数据,而不是仅仅依赖于训练数据,这使得模型在处理新的、未见过的数据时具有更好的适应性。

-

Titans应用场景

-

语言建模:用于生成自然语言文本,如自动写作、故事生成等,能够更好地捕捉长距离的语义依赖。

-

常识推理:在问答系统中,处理需要广泛背景知识和长上下文理解的问题,提高回答的准确性和相关性。

-

基因组学:分析DNA序列,识别基因变异和功能区域,辅助疾病诊断和药物研发。

-

时间序列预测:在金融、气象等领域,预测股票价格、天气变化等,处理长周期的数据模式。

-

视频理解:分析视频内容,理解视频中的事件和行为,支持视频摘要、监控等应用。

-

自然语言处理:在机器翻译、文本分类等任务中,处理长文本输入,提高模型的性能和鲁棒性。

Titans项目入口

- arXiv技术论文:https://arxiv.org/pdf/2501.00663v1

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号