Wear-Any-Way:通过高保真图像生成和可定制的穿着风格

Wear-Any-Way简介

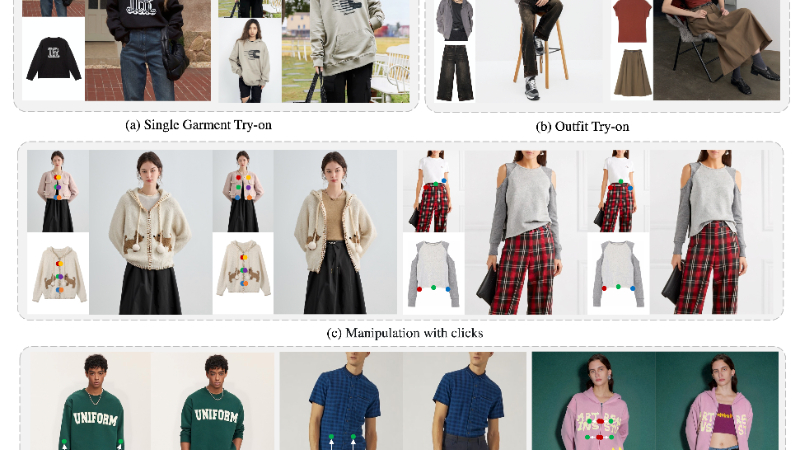

Wear-Any-Way 是由阿里巴巴集团开发的一种新型虚拟试穿框架,旨在通过高保真图像生成和可定制的穿着风格为用户提供沉浸式的时尚体验。该技术不仅支持单件或多件服装的虚拟试穿,还能在复杂场景下实现模型到模型的试穿效果。其核心创新在于稀疏对应对齐技术,用户可以通过简单的点击和拖动操作,精确控制服装的穿着方式,例如卷起袖子、打开外套或调整褶皱等。这一技术不仅在标准虚拟试穿任务中达到了行业领先水平,还为时尚产业带来了全新的交互形式,具有重要的应用价值和广阔的商业前景。

Wear-Any-Way主要功能

-

高保真虚拟试穿

支持单件或多件服装的虚拟试穿,并在复杂场景下生成高质量、高分辨率的试穿图像,同时保留服装的细节纹理。 -

可定制化穿着风格

用户可以通过点击和拖动等简单交互方式,精确控制服装的穿着方式,例如卷起袖子、打开外套、调整褶皱或改变服装的贴合度。 -

多场景支持

支持从简单背景到复杂街景的多样化试穿场景,同时兼容不同姿势和体型的人物模型。 -

实时交互与动态编辑

用户可以在生成的图像上实时调整服装的穿着效果,实现动态编辑,满足个性化需求。 -

多服装类别支持

支持多种类型的服装,包括外套、T恤、裤子、连帽衫等,适用于不同季节和风格的服装试穿。

Wear-Any-Way技术原理

-

双分支 U-Net 架构

采用主 U-Net 和参考 U-Net 的双分支结构。主 U-Net 负责生成试穿结果,参考 U-Net 提取服装的细节特征,并通过自注意力机制将特征注入到主 U-Net 中,从而保留服装的纹理和图案细节。 -

稀疏对应对齐(Sparse Correspondence Alignment, SCA)

通过点对控制实现可定制化试穿。用户在服装图像和人物图像上标记点对,模型通过学习这些点对的对应关系,将服装上的点对齐到人物图像上的目标位置,从而实现精确的穿着风格控制。 -

扩散模型基础

基于预训练的 Stable Diffusion 模型,利用其强大的生成能力和去噪过程,逐步从高斯噪声中重建出高质量的试穿图像。 -

姿态和语义控制

引入姿态图作为额外的控制信号,增强生成图像的自然性和一致性。同时,通过 CLIP 图像编码器提取服装的语义特征,确保生成结果与输入服装的风格一致。 -

训练点对收集

利用预训练的扩散模型提取特征,并通过计算特征图之间的余弦相似性来自动匹配服装和人物图像上的点对,从而为稀疏对应对齐提供训练数据。 -

优化策略

采用条件丢弃、零初始化和点加权损失等策略,增强模型对点对控制的学习能力,提高生成图像的准确性和可控性。

Wear-Any-Way应用场景

-

在线购物平台:消费者可以在网上试穿不同款式和尺码的服装,提升购物体验,减少因尺寸或风格不符导致的退货。

-

时尚设计与展示:设计师可快速展示服装设计效果,客户能直观看到不同穿着风格,助力设计优化与销售推广。

-

虚拟试衣间:在线下实体店中设置虚拟试衣镜,顾客无需实际试穿即可快速查看不同服装效果,节省时间和精力。

-

电商直播与营销:主播可实时展示服装的多种穿着风格,增强互动性和吸引力,提升销售转化率。

-

个性化定制服务:用户可根据自身喜好调整服装细节,如卷起袖子或调整褶皱,实现个性化定制,满足独特需求。

-

时尚教育与培训:学生和设计师可通过虚拟试穿学习不同服装的搭配和穿着效果,提升时尚设计和搭配能力。

Wear-Any-Way项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号