OmniManip:智元机器人联合北京大学推出的机器人操作框架

OmniManip简介

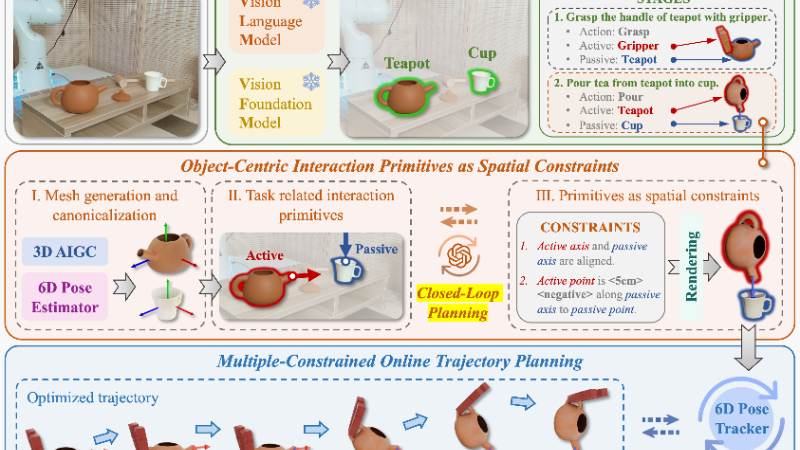

OmniManip是由北京大学和智元机器人联合开发的一种新型机器人操作框架。该方法通过基于对象中心的交互原语作为空间约束,弥合了视觉语言模型(VLM)的高级语义推理与机器人操作所需的精确3D空间理解之间的差距。OmniManip提出了一种双闭环系统,结合高级规划和低级执行,确保了无需VLM微调即可实现鲁棒的实时控制。它通过对象的规范空间定义交互原语,实现了高效、稳定的任务规划与执行,并在多种零样本操作任务中展现出强大的泛化能力。该方法为实现通用机器人操作提供了新的思路,尤其在非结构化环境中具有广阔的应用前景。

OmniManip主要功能

-

通用机器人操作:OmniManip能够实现多种复杂机器人操作任务,包括刚体操作(如倒茶、插入笔)和关节操作(如开抽屉、关闭笔记本电脑盖子),无需针对具体任务进行训练。

-

零样本泛化能力:通过利用视觉语言模型(VLM)的高级常识推理,OmniManip能够在未见过的任务场景中实现快速适应和执行,无需任务特定的数据或微调。

-

高效交互原语提取:OmniManip通过对象中心的交互原语(如点和方向)作为空间约束,将VLM的语义推理转化为可操作的3D空间约束,确保了交互的稳定性和效率。

-

双闭环控制:OmniManip设计了高级规划和低级执行的双闭环系统,通过交互渲染和姿态跟踪确保任务执行的鲁棒性和实时性。

-

自动化数据生成:OmniManip能够自动生成机器人操作的演示数据,为行为克隆和模仿学习提供支持,从而加速机器人的学习过程。

OmniManip技术原理

-

对象中心的交互原语表示:

-

OmniManip通过对象的规范空间定义交互原语,利用对象的功能性来描述交互点和方向。

-

这种表示方法将VLM的高级语义推理与低级的3D空间理解相结合,使得机器人能够更精准地执行操作任务。

-

-

双闭环系统设计:

-

高级规划闭环:通过交互渲染和原语重采样机制,OmniManip能够检测并修正VLM推理中的错误,确保规划结果的准确性。

-

低级执行闭环:利用6D姿态跟踪技术,OmniManip在执行阶段实时更新对象姿态,确保任务执行的鲁棒性。

-

-

3D空间约束优化:

-

OmniManip将任务分解为多个阶段,每个阶段通过交互原语定义空间约束(如距离和角度约束)。

-

通过优化这些约束,OmniManip能够生成精确的机器人末端执行器轨迹,确保任务的成功执行。

-

-

实时姿态估计与跟踪:

-

OmniManip使用通用的6D姿态估计模型对操作对象进行规范,并在执行过程中通过姿态跟踪技术实时更新对象姿态。

-

这种方法能够有效处理现实世界中的动态变化,如目标对象的移动或遮挡。

-

-

零样本泛化能力:

-

OmniManip利用VLM的高级语义推理能力,结合对象中心的交互原语表示,能够在未见过的任务场景中快速生成合理的操作策略。

-

这种能力使得OmniManip在多种复杂环境中展现出强大的泛化性能,无需针对每个任务进行数据收集和模型微调。

-

OmniManip应用场景

-

家庭服务机器人:完成家务任务,如倒茶、整理桌面、回收垃圾等。

-

工业自动化:在生产线中进行零部件装配、物料搬运和质量检测。

-

物流与仓储:实现货物的分拣、搬运和货架整理。

-

医疗辅助:协助医护人员进行手术器械传递、药品分发等操作。

-

零售服务:在超市或商场中进行商品补货、货架整理和顾客服务。

-

教育与研究:作为实验平台,用于机器人技术的教学和研究,探索新的操作策略和算法。

OmniManip项目入口

- 项目主页:https://omnimanip.github.io/

- GitHub代码库:https://github.com/pmj110119/OmniManip

- arXiv技术论文:https://arxiv.org/pdf/2501.03841

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号