X-Dyna:将单张人像图像通过驱动视频中的动作和表情动画化

X-Dyna 简介

X-Dyna 是由字节跳动、美国南加州大学、斯坦福大学、加州大学洛杉矶分校和加州大学圣地亚哥分校联合开发的一种新型零样本扩散模型框架,用于将单张人像图像动画化。它通过驱动视频中提取的身体动作和面部表情,生成逼真的动态视频,同时保留人物身份和背景信息。X-Dyna 的核心是 Dynamics-Adapter 模块,它能够高效整合参考图像的上下文信息,同时保留扩散模型生成复杂动态细节的能力。此外,该框架还通过混合人类运动视频和自然场景视频进行训练,进一步提升了动态效果的真实感。X-Dyna 在动态纹理生成、人物动作控制和身份保持等方面均展现出卓越性能,为数字内容创作、虚拟角色生成等领域提供了强大的技术支持。

X-Dyna 主要功能

-

单张人像动画化:将单张人像图像通过驱动视频中的动作和表情动画化,生成逼真的动态视频。

-

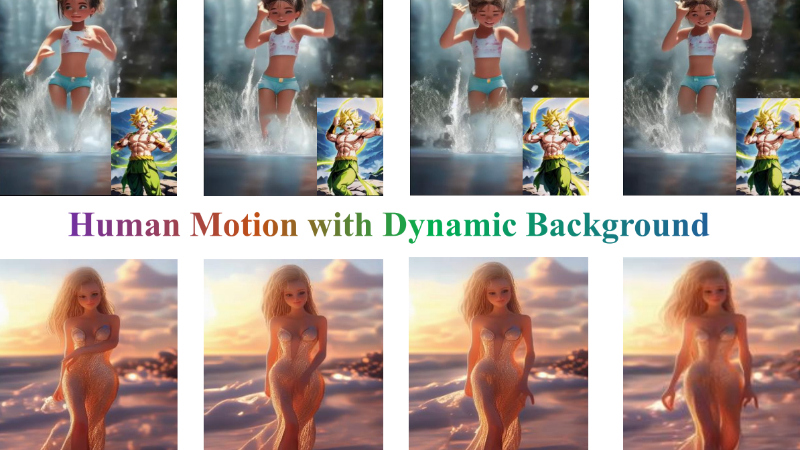

动态纹理生成:生成逼真的动态背景效果,如瀑布、火焰、飘动的头发等,增强视频的真实感。

-

身份保持与表情控制:在动画化过程中保持人物的身份特征,并精确控制面部表情,实现自然的表情转移。

-

零样本动画生成:不需要额外训练即可实现任意人物的动画化,支持跨身份的动作和表情驱动。

-

实时动态生成:支持实时生成动态视频,适用于社交媒体、虚拟角色等应用场景。

X-Dyna 技术原理

-

扩散模型框架:基于扩散模型(Diffusion Model)的生成框架,通过逐步去噪的方式从高斯噪声中生成图像和视频内容。

-

Dynamics-Adapter模块:通过轻量级的跨帧注意力机制,将参考图像的外观信息无缝整合到扩散模型的空间注意力中,同时保留模型生成动态细节的能力。

-

混合数据训练策略:结合人类运动视频和自然场景视频进行训练,使模型能够同时学习人物动态和背景动态,生成更逼真的视频效果。

-

局部面部表情控制:引入S-Face ControlNet模块,通过预训练的肖像重演网络实现身份无关的表情控制,增强表情的自然性和真实性。

-

时空一致性模块:集成时间注意力模块(如AnimateDiff),确保生成视频在时间维度上的连贯性和一致性。

-

身份保持机制:通过Dynamics-Adapter和局部控制模块,确保在动画化过程中保持人物的身份特征,避免身份信息的丢失。

-

零样本生成能力:利用预训练的扩散模型和模块化设计,实现无需额外训练即可对任意人物进行动画化,支持跨身份的动作和表情驱动。

X-Dyna 应用场景

-

虚拟角色动画:为虚拟主播、虚拟偶像等生成自然流畅的动作和表情,提升互动性和真实感。

-

社交媒体内容创作:用户可将静态照片转化为动态视频,丰富内容形式,增强趣味性和吸引力。

-

数字艺术与特效制作:在影视、广告和游戏制作中快速生成动态人物效果,降低制作成本,提升创作效率。

-

虚拟试衣与时尚展示:实现人物动态试衣效果,展示服装的动态美感,提升用户体验。

-

教育与培训:生成动态教学视频,通过虚拟人物演示动作和表情,增强教学的趣味性和直观性。

-

虚拟现实(VR)与增强现实(AR);在 VR/AR 场景中生成逼真的动态人物和环境,提升沉浸感和交互性。

X-Dyna 项目入口

- 项目主页:https://x-dyna.github.io/xdyna.github.io

- Github代码库:https://github.com/bytedance/X-Dyna

- HuggingFace:https://huggingface.co/Boese0601/X-Dyna

- arXiv技术论文:https://arxiv.org/pdf/2501.10021

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号