UI-TARS:字节联合清华大学推出的原生GUI代理模型

UI-TARS简介

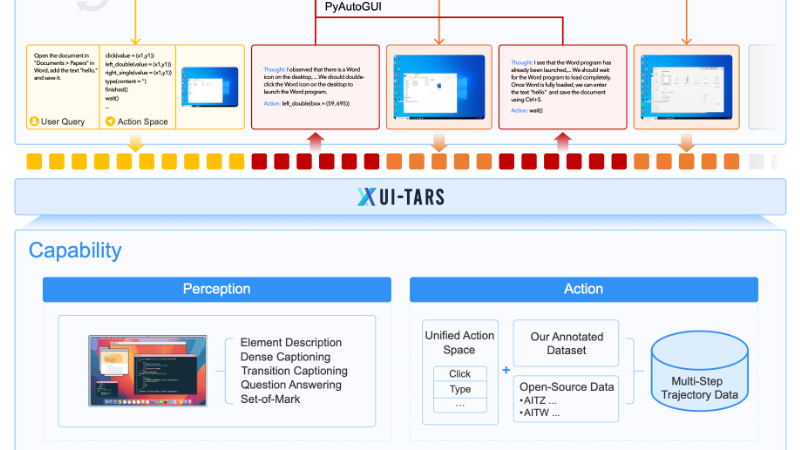

UI-TARS是由字节跳动与清华大学联合开发的原生GUI代理模型。它通过纯视觉输入(如屏幕截图)实现与图形用户界面的交互,无需依赖文本描述或系统级权限。UI-TARS在多个基准测试中展现了卓越性能,尤其是在感知、定位和复杂任务执行方面,超越了GPT-4o和Claude等现有模型。该模型通过增强感知能力、统一动作建模、系统2推理以及迭代训练等创新技术,实现了从错误中学习和适应新环境的能力。UI-TARS的开发标志着GUI代理从模块化框架向端到端模型的转变,为未来自主代理的主动和终身学习奠定了基础。

UI-TARS主要功能

-

自动化GUI交互:UI-TARS能够通过屏幕截图识别和理解图形用户界面,并执行类似人类的键盘和鼠标操作,实现自动化任务。

-

跨平台支持:UI-TARS可以在不同平台(如移动设备、桌面应用和网络界面)上执行任务,适应各种操作系统和应用程序。

-

任务执行与推理:该模型能够进行多步任务执行,结合系统2推理能力,处理复杂的任务分解、反思思考和里程碑识别等。

-

自适应学习:通过迭代训练和反思调整,UI-TARS能够从错误中学习,不断优化其性能,适应新的环境和任务。

-

高精度定位:UI-TARS具备高精度的GUI元素定位能力,能够准确识别和交互特定的界面元素。

UI-TARS技术原理

-

增强感知能力(Enhanced Perception):

-

大规模数据集:利用大规模的GUI屏幕截图数据集,进行上下文感知的UI元素理解和精确描述。

-

多任务训练:通过元素描述、密集标注、状态转换描述和问答等任务,提升模型的感知能力。

-

-

统一动作建模(Unified Action Modeling):

-

标准化动作空间:将跨平台的语义等价动作标准化,例如在Windows上“点击”与在移动设备上“点击”进行统一处理。

-

多步动作轨迹:通过大规模的动作轨迹数据,训练模型执行多步任务,提升其系统1推理能力。

-

-

系统2推理(System-2 Reasoning):

-

任务分解:将复杂任务分解为可管理的子任务,逐步完成。

-

长远一致性:在整个任务过程中保持目标一致,避免偏离初始目标。

-

里程碑识别:识别任务执行中的关键步骤,确保任务进展顺利。

-

试错与反思:通过试错和反思机制,模型能够识别并纠正错误,提高决策的准确性。

-

-

迭代训练与反思调整(Iterative Training with Reflective Online Traces):

-

在线数据收集:在虚拟环境中自动收集新的交互轨迹,进行多级过滤和反思性优化。

-

错误纠正与反思调优:通过标注错误和纠正步骤,模型学习如何从错误中恢复,增强其适应性。

-

-

长期记忆(Long-term Memory):

-

短期记忆:存储任务特定的信息和当前状态,增强实时适应能力。

-

长期记忆:记录先前的交互和任务知识,支持未来任务的推理和决策。

-

UI-TARS应用场景

-

自动化办公任务:例如在Excel中自动填充数据、在PowerPoint中调整幻灯片布局或在Word中编辑文档格式,提高工作效率。

-

网页自动化操作:如自动登录网站、填写表单、搜索信息或进行网页导航,适用于数据采集和自动化测试。

-

移动设备自动化:在Android或iOS设备上自动执行任务,如打开应用、播放音乐、设置闹钟或浏览社交媒体。

-

软件测试与调试:自动执行软件功能测试,验证界面元素的交互是否正常,减少人工测试成本。

-

智能客服与辅助:通过界面交互帮助用户完成操作,如在软件中引导用户完成设置或解决常见问题。

-

自动化系统管理:例如在操作系统中自动安装软件、配置系统设置或管理文件,提升系统维护效率。

UI-TARS项目入口

- GitHub代码库:https://github.com/bytedance/UI-TARS

- HuggingFace:https://huggingface.co/bytedance-research/UI-TARS-7B-DPO

- arXiv技术论文:https://arxiv.org/pdf/2501.12326

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号