VideoChat-Flash 简介

VideoChat-Flash 是由上海人工智能实验室、南京大学和中国科学院深圳先进技术研究院联合开发的一种新型多模态大语言模型(MLLM),专门用于高效处理长视频内容。该模型通过层次化视觉压缩(HiCo)技术,显著降低了长视频处理的计算负担,同时保留了关键视觉信息。它采用多阶段短到长的学习方案,结合大规模真实长视频数据集 LongVid,能够有效理解和生成长视频内容。VideoChat-Flash 在长视频和短视频基准测试中均表现出色,尤其在多跳“针在视频堆中”任务中展现了卓越的长上下文理解能力。

VideoChat-Flash 主要功能

-

长视频高效处理:能够处理长达数小时的视频内容,通过层次化压缩技术大幅降低计算负担,同时保留关键视觉信息。

-

多模态理解与生成:支持视频字幕生成、视频问答、时间定位等任务,具备强大的多模态交互能力。

-

长上下文建模:通过多阶段短到长的学习方案,能够理解和生成长视频中的复杂事件和情节。

-

高分辨率视频理解:支持高分辨率视频输入,适应不同视频质量的需求。

-

强大的时间感知能力:能够准确理解视频中的时间信息,支持时间定位等任务。

VideoChat-Flash 技术原理

-

层次化视觉压缩(HiCo):

-

利用长视频中的视觉冗余信息,将长视频从片段级压缩到视频级。

-

通过动态视频采样和时间戳感知提示,增强模型对视频时间和内容的理解。

-

在片段级和视频级分别进行压缩,减少视觉令牌数量,降低计算量。

-

-

多阶段短到长学习方案:

-

阶段1:视频-语言对齐,训练模型对齐压缩后的视觉特征和语言。

-

阶段2:短视频预训练,增强模型对视觉概念的理解。

-

阶段3:联合短长视频指令微调,使模型能够处理多种视频任务。

-

阶段4:高分辨率后微调,提升模型对高分辨率视频的适应能力。

-

-

大规模长视频数据集(LongVid):

-

包含114,228个长视频和3,444,849个问答对,涵盖多种任务类型。

-

数据来源广泛,包括 Ego4D、HowTo100M、HD-VILA 和 MiraData 等,支持模型在多种场景下的学习。

-

-

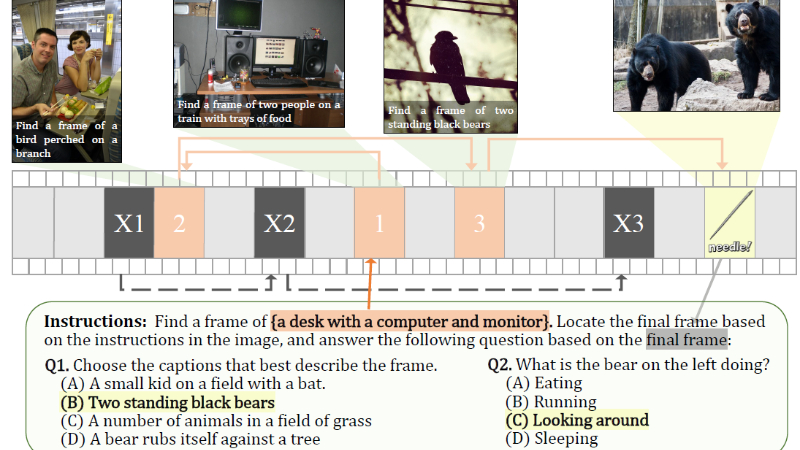

多跳“针在视频堆中”(NIAH)评估:

-

通过多跳任务评估模型的长上下文理解能力。

-

要求模型通过一系列指示图像找到目标图像,并回答相关问题,避免通过猜测获得高准确率。

-

-

高效计算与分布式训练:

-

采用分布式系统支持高序列并行计算,确保模型训练的高效性和稳定性。

-

视觉级压缩和渐进式视觉丢弃策略进一步优化了模型的计算效率。

-

VideoChat-Flash 应用场景

-

长视频内容理解与问答:自动回答用户关于长视频(如电影、纪录片)的提问,帮助用户快速获取关键信息。

-

视频字幕生成:为长视频自动生成精准字幕,支持多语言翻译,提升视频的可访问性。

-

视频内容编辑:辅助视频编辑人员快速定位关键帧或事件,提高剪辑效率。

-

在线教育与学习:帮助学生快速找到课程视频中的重点内容,提升学习效率。

-

视频监控与分析:在长时监控视频中快速定位异常事件,支持安防监控和智能分析。

-

视频推荐与搜索:通过理解视频内容,为用户提供精准的视频推荐和搜索结果,提升用户体验。

VideoChat-Flash 项目入口

- GitHub代码库:https://github.com/OpenGVLab/VideoChat-Flash

- arXiv技术论文:https://arxiv.org/pdf/2501.00574

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号