DiffSplat:北京大学联合字节推出的新型3D生成框架

DiffSplat简介

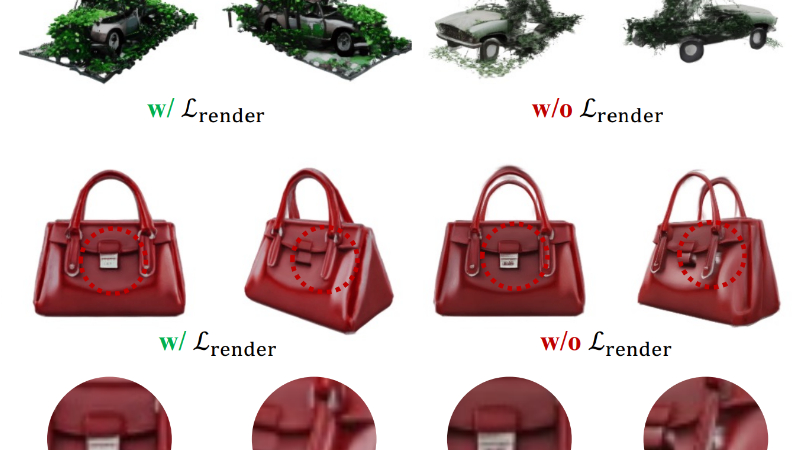

DiffSplat是由北京大学和字节跳动的研究团队共同开发的一种新型3D生成框架。它通过利用大规模的文本到图像扩散模型,直接生成3D高斯点阵(Gaussian splats),从而解决了从文本或单张图像生成高质量3D内容的难题。DiffSplat的核心在于将3D对象表示为结构化的2D网格上的点阵,并通过轻量级的重建模型和自编码策略,将这些点阵高效地转化为适合扩散模型处理的潜变量。该框架不仅有效利用了2D扩散模型的强大生成能力,还通过引入渲染损失确保了3D生成内容在不同视角下的一致性。DiffSplat在文本和图像条件生成任务中均展现出优越性能,为3D内容生成提供了一种高效且高质量的新方法。

DiffSplat主要功能

-

高效生成高质量3D内容:DiffSplat能够从文本描述或单张图像直接生成高质量的3D高斯点阵(Gaussian splats),支持复杂的3D场景和物体的生成,适用于游戏设计、虚拟现实、数字艺术等多种应用场景。

-

多视图一致性:生成的3D内容在不同视角下保持一致,解决了传统方法中多视图生成不一致的问题,确保从任意角度观察都能获得连贯的3D效果。

-

无缝适配多种预训练模型:DiffSplat能够无缝适配多种预训练的文本到图像扩散模型,如Stable Diffusion等,利用这些模型的强大生成能力,快速生成高质量的3D内容。

-

支持可控生成:结合ControlNet等技术,DiffSplat可以实现通过额外的控制信号(如深度图、法线图、边缘图等)引导生成,实现更灵活的3D内容创作。

-

高效的数据准备和训练:通过轻量级的重建模型快速生成“伪”3D数据集,结合渲染损失和扩散损失进行训练,大大提高了训练效率和生成质量。

DiffSplat技术原理

-

3D高斯点阵表示:使用3D高斯点阵(Gaussian splats)作为3D内容的表示方式,每个点阵包含颜色、位置、尺度、旋转和不透明度等属性,能够高效地表示复杂的3D场景和物体。

-

结构化点阵重建:通过一个小网络从多视图图像中快速回归出每个像素对应的点阵属性,生成结构化的2D网格表示,这些网格可以高效地用于训练和生成。

-

点阵潜变量编码:将高斯点阵网格编码到图像扩散模型的潜空间中,通过调整预训练的变分自编码器(VAE)来适应点阵属性的编码,并引入渲染损失以确保编码后的潜变量能够更好地反映真实3D对象。

-

扩散模型的微调:利用预训练的文本到图像扩散模型作为基础,通过微调使其能够直接生成3D高斯点阵。在训练过程中结合了扩散损失和渲染损失,以确保生成的3D内容在不同视角下具有一致性。

-

多视图处理方式:采用“视图连接”和“空间连接”两种方式处理多视图数据,确保模型能够灵活处理不同数量的视图,并在训练和生成过程中保持高效。

-

渲染损失的引入:在训练过程中引入渲染损失,通过从随机视角渲染生成的3D内容并与真实多视图图像进行对比,进一步优化生成模型的3D一致性。

DiffSplat应用场景

-

游戏设计:快速生成高质量的3D游戏模型和场景,支持从文本描述或概念图直接生成3D资产,提升开发效率。

-

虚拟现实(VR)和增强现实(AR):用于创建沉浸式的虚拟环境和3D对象,支持实时渲染和交互,增强用户体验。

-

数字艺术创作:艺术家可以利用DiffSplat从创意文本或草图快速生成3D艺术作品,探索更多创意可能性。

-

影视特效制作:生成高质量的3D场景和角色模型,减少手工建模的工作量,加快特效制作流程。

-

建筑设计与可视化:从设计草图或文本描述快速生成3D建筑模型,用于方案展示和客户沟通。

-

教育与培训:生成3D教学模型和虚拟场景,如人体解剖模型、历史场景重现等,增强教学的直观性和趣味性。

DiffSplat项目入口

- GitHub代码库:https://github.com/chenguolin/DiffSplat

- arXiv研究论文:https://arxiv.org/pdf/2501.16764

- Hugging Face模型:https://huggingface.co/chenguolin/DiffSplat

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号