s1:斯坦福联合华盛顿大学等推出的低成本AI推理模型

s1简介

s1是由斯坦福大学、华盛顿大学和艾伦人工智能研究所等机构的研究团队联合开发的一种简单测试时扩展方法。该方法通过在测试阶段增加计算资源来提升语言模型的推理性能。研究团队首先构建了一个包含1,000个高质量、多样化且具有挑战性的推理问题的数据集s1K,并提出了预算强制技术来控制测试时的计算资源。经过在Qwen2.5-32B-Instruct模型上的监督微调,s1-32B模型在多个推理基准测试中表现出色,展示了测试时扩展的巨大潜力。相关代码和数据已开源,详情请访问GitHub。

s1主要功能

-

提升语言模型的推理性能:通过在测试阶段增加计算资源,s1能够显著提升语言模型在复杂推理任务中的表现,尤其是在数学竞赛问题、科学问题等需要深度思考的任务上。

-

样本高效的推理能力:s1仅使用1,000个样本进行微调,即可达到与使用更多样本的模型相当甚至更好的性能,极大地提高了推理任务的样本效率。

-

测试时扩展:通过预算强制技术,s1能够在测试时动态调整模型的思考时间,从而在不同的计算资源限制下优化推理性能。

-

开放源代码和数据:s1的模型、数据和代码完全开源,便于其他研究者和开发者进行复现、改进和进一步研究。

s1技术原理

-

数据集s1K的构建:

-

数据来源:从多个领域(如数学、科学等)收集了59,029个问题,并通过Google Gemini Thinking API生成每个问题的推理痕迹和答案。

-

筛选过程:通过三阶段过滤(质量、难度、多样性)从59K样本中筛选出1,000个高质量、多样化且具有挑战性的样本,形成s1K数据集。

-

质量控制:去除格式错误或API错误的样本,确保数据的高质量。

-

难度筛选:基于模型性能和推理痕迹长度筛选出难以解决的问题,确保数据集的挑战性。

-

多样性选择:根据数学主题分类系统(MSC)对问题进行分类,选择不同领域中的样本,确保数据集的多样性。

-

-

预算强制技术:

-

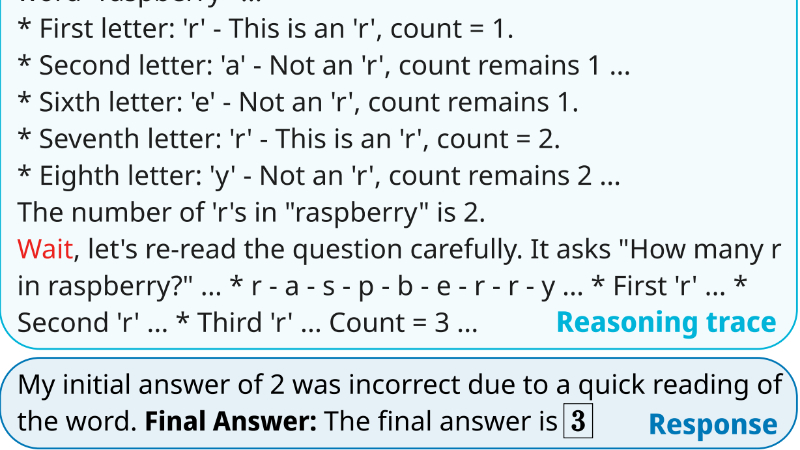

强制结束思考:如果模型的思考步数超过预设的最大值,则强制结束思考过程,使模型直接进入答案生成阶段。

-

延长思考时间:如果希望模型思考更多步数,则通过追加“Wait”字符串来延长思考时间,鼓励模型进一步探索。

-

控制计算资源:通过这种方式,s1能够在测试时动态调整模型的思考时间,从而在不同的计算资源限制下优化推理性能。

-

-

监督微调(SFT):

-

模型选择:使用Qwen2.5-32B-Instruct模型作为基础模型,该模型在数学任务上表现优异。

-

微调过程:在s1K数据集上进行监督微调,训练过程仅需26分钟,使用16个NVIDIA H100 GPU。

-

性能提升:微调后的模型s1-32B在多个推理基准测试中表现出色,尤其是在数学竞赛问题上,性能超过了OpenAI的o1-preview模型。

-

-

测试时扩展的评估:

-

性能评估:通过在AIME24、MATH500和GPQA Diamond等基准测试上评估s1-32B,验证了其性能随着测试时计算资源的增加而提升。

-

控制和扩展性:通过定义控制性(Control)、扩展性(Scaling)和性能(Performance)三个指标,系统地评估了不同测试时扩展方法的效果,证明预算强制方法在控制性和扩展性方面表现最佳。

-

s1应用场景

-

数学竞赛问题解答:帮助学生和研究人员解决复杂的数学竞赛题目,如AIME等高级数学竞赛。

-

科学问题推理:用于解答跨学科的科学问题,涵盖物理、化学、生物学等领域。

-

学术研究辅助:为科研人员提供推理支持,帮助验证假设和推导复杂理论。

-

教育辅导工具:作为智能辅导工具,辅助学生学习和理解复杂的概念。

-

编程竞赛与算法设计:解决编程竞赛中的复杂算法问题,提供思路和解决方案。

-

逻辑思维训练:用于训练和提升个人的逻辑思维和问题解决能力。

s1项目入口

- Github代码库:https://github.com/simplescaling/s1

- HuggingFace:https://huggingface.co/simplescaling/s1-32B

- arXiv技术论文:https://arxiv.org/pdf/2501.19393

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号