Ola简介

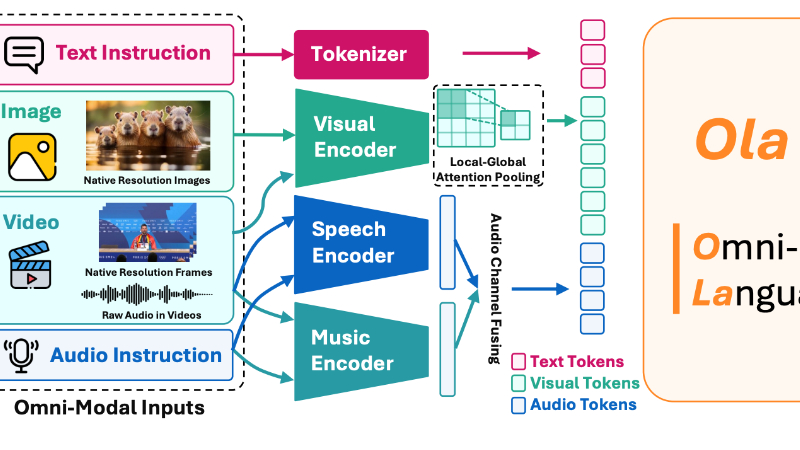

Ola是由清华大学、腾讯 Hunyuan 研究团队和南洋理工大学 S-Lab 联合开发的全模态语言模型。它通过渐进式模态对齐策略,能够同时处理图像、视频和音频等多种输入模态,并在理解任务上展现出与专门模型相媲美的性能。Ola的核心优势在于其创新的训练方法和架构设计,通过从图像和文本模态逐步扩展到视频和音频,实现了多模态之间的高效对齐。此外,Ola还支持实时流式解码,能够生成高质量的语音输出。开发团队致力于将Ola打造成一个完全开放的全模态理解解决方案,以推动未来在这一新兴领域的研究和应用。

Ola主要功能

-

多模态输入处理:Ola能够同时处理文本、图像、视频和音频等多种输入模态,提供全面的理解和生成能力。

-

高效的模态对齐:通过渐进式模态对齐策略,Ola在不同模态之间实现了高效的对齐,确保在所有支持的任务上都能取得平衡和竞争力的性能。

-

实时流式解码:Ola支持用户友好的实时流式解码,能够生成高质量的文本和语音输出,提升用户交互体验。

-

跨模态问答:Ola能够基于视频内容和对应的音频生成问答对,展示其在复杂多模态任务中的强大能力。

-

高质量语音合成:Ola集成了高质量的语音解码器,能够进行高质量的语音合成,支持流式语音生成。

Ola技术原理

-

渐进式模态对齐策略:

-

阶段1:文本-图像训练:

-

从预训练的大型语言模型开始,进行MLP对齐、大规模预训练和监督微调,建立基础的跨模态能力。

-

-

阶段2:图像和视频的持续训练:

-

在强大的文本-图像多模态LLM基础上,加入视频数据进行持续训练,增强视觉理解能力。

-

-

阶段3:通过视频桥接视觉和音频:

-

学习音频相关的任务,并将视觉和音频信息结合起来,形成一个全面的图像、视频和音频理解模型。

-

-

-

模型架构设计:

-

视觉编码器:

-

使用OryxViT作为视觉编码器,处理图像和视频帧,保留原始分辨率以获取更多细节。

-

-

语音编码器:

-

使用Whisper-V3作为语音编码器,处理语音输入,并将其转换为Mel谱图表示。

-

-

音乐编码器:

-

使用BEATs作为音乐编码器,处理原始音频输入,提供丰富的音频信息。

-

-

本地-全局注意力池化层:

-

通过本地-全局注意力池化层对视觉特征进行下采样,减少信息损失,提高效率。

-

-

联合对齐模块:

-

将特定模态的特征投影到统一的文本嵌入空间,实现模态之间的对齐。

-

-

-

数据准备与生成:

-

图像数据:

-

收集大量的图像-文本对齐数据进行预训练和微调,建立基础的视觉理解能力。

-

-

视频数据:

-

收集高质量的视频数据,设计清理流程,并生成问答对,增强视频理解能力。

-

-

音频数据:

-

收集语音和音乐相关的数据,设计多任务训练,包括ASR、音频字幕生成和音频问答,提升音频理解能力。

-

-

Ola应用场景

-

智能客服:能够实时理解客户通过文字、语音或视频提出的问题,并提供精准、及时的回答,提升客户满意度。

-

虚拟助手:在智能家居、办公环境中,通过语音指令或视觉识别,帮助用户完成任务,如查询信息、控制设备等。

-

教育辅导:为学生提供个性化的学习体验,通过语音讲解、图像展示和视频演示,帮助学生更好地理解和掌握知识。

-

内容创作:辅助创作者生成创意内容,如撰写文章、脚本,或根据文字描述生成图像、视频等,提高创作效率。

-

无障碍辅助:为视障或听障人士提供语音转文字、文字转语音等服务,帮助他们更好地获取和交流信息。

-

智能会议:实时转录会议内容,提取关键信息,甚至通过视频分析参会者的情绪和反应,为会议决策提供支持。

Ola项目入口

- 项目主页:https://ola-omni.github.io/

- Github仓库:https://github.com/Ola-Omni/Ola

- arXiv技术论文:https://arxiv.org/pdf/2502.04328

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号