LLaVA-Med:微软推出的生物医学领域的大型语言和视觉助手

LLaVA-Med简介

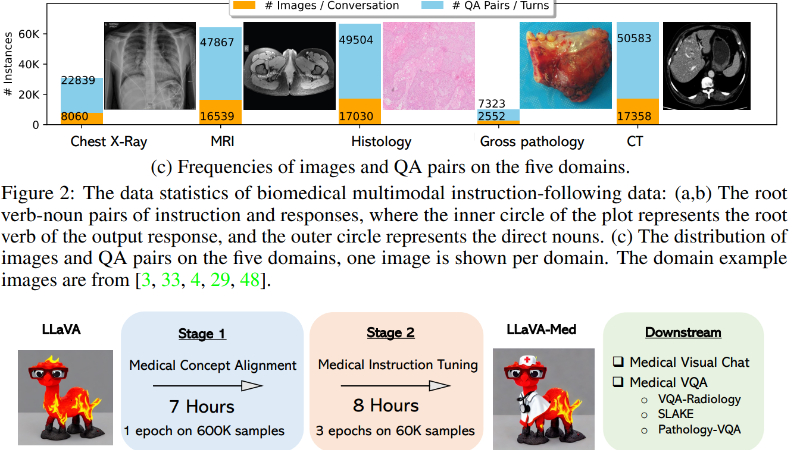

LLaVA-Med是由微软推出的一款针对生物医学领域的大型语言和视觉助手。该团队通过创新的方法,利用PubMed Central的海量生物医学图像-标题数据集,结合GPT-4生成的指令跟随数据,采用课程学习方法对模型进行微调。LLaVA-Med能够在不到15小时内完成训练,展现出强大的多模态对话能力,尤其擅长回答有关生物医学图像的开放式问题。在多个生物医学视觉问答数据集上,LLaVA-Med的性能超越了以往的最佳监督学习方法,证明了其在生物医学领域的应用潜力。开发团队还计划开源相关数据和模型,以推动生物医学多模态研究的发展。

LLaVA-Med主要功能

-

多模态对话能力:LLaVA-Med能够处理和理解生物医学图像和文本,回答关于生物医学图像的开放式问题。

-

生物医学视觉问答:在多个标准生物医学视觉问答数据集上,LLaVA-Med表现出色,能够提供准确的回答,支持临床医生和患者的需求。

-

开放式指令跟随:LLaVA-Med能够根据用户提供的指令生成详细的对话和解释,涵盖广泛的生物医学主题。

-

快速训练:LLaVA-Med可以在不到15小时内完成训练,展示了高效的训练能力。

LLaVA-Med技术原理

-

大规模数据集:利用PubMed Central中的PMC-15M数据集,该数据集包含1500万对生物医学图像-文本对,为模型提供了丰富的训练数据。

-

GPT-4生成指令数据:通过GPT-4从PMC-15M数据集中生成多样化的生物医学多模态指令跟随数据,无需手动注释,极大地丰富了训练数据的多样性。

-

课程学习方法:采用两阶段的课程学习方法,首先通过图像-文本对对齐生物医学词汇,然后使用生成的指令跟随数据学习开放式对话语义。这种方法模拟了普通人逐渐获取生物医学知识的过程。

-

模型架构:LLaVA-Med基于LLaVA模型,采用线性投影层连接视觉编码器和语言模型。在训练过程中,首先冻结视觉编码器和语言模型的权重,只更新投影矩阵,然后在第二阶段解冻语言模型的权重,进行端到端的指令调整。

-

开源计划:为了促进生物医学多模态研究,开发团队计划开源LLaVA-Med的指令跟随数据和代码库,使得更多研究人员能够利用这些资源进行进一步研究和开发。

LLaVA-Med应用场景

-

临床诊断辅助:帮助医生快速解读生物医学图像(如X光、CT、MRI等),提供诊断建议和可能的病理分析。

-

医学教育:为医学生和医学教育工作者提供图像解读和病例分析的辅助工具,增强教学互动性。

-

远程医疗:在远程医疗服务中,协助医生通过图像和文本信息为患者提供初步诊断和建议。

-

医学研究支持:辅助研究人员分析生物医学图像数据,快速提取关键信息,支持研究工作。

-

患者咨询:为患者提供对生物医学图像的通俗解释,帮助他们更好地理解检查结果和病情。

-

医疗数据分析:用于分析和整理大量的生物医学图像数据,为医院和研究机构提供数据支持和决策依据。

LLaVA-Med项目入口

- Github代码库:https://github.com/microsoft/LLaVA-Med

- arXiv技术论文:https://arxiv.org/pdf/2306.00890

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号