HumanDiT:浙大联合字节推出的人体运动视频生成的框架

HumanDiT简介

HumanDiT是由浙江大学和字节跳动联合开发的一种用于长时序人体运动视频生成的框架。该框架基于姿态引导的扩散变换器(Diffusion Transformer,DiT),能够在多样化场景中生成高保真度、长时序的人体运动视频。HumanDiT通过大规模数据集训练,支持多种分辨率和动态序列长度,并在姿态转移和视频延续方面表现出色。开发团队通过引入关键点DiT和姿态适配器等创新技术,显著提升了视频生成的视觉一致性和姿态准确性。HumanDiT在多项评估指标上超越了现有方法,展现了其在人体运动视频生成领域的先进性能。

HumanDiT主要功能

-

高保真度视频生成:HumanDiT能够生成高质量、细节丰富的长时序人体运动视频,特别是在手部和面部等细节部位的渲染上表现出色。

-

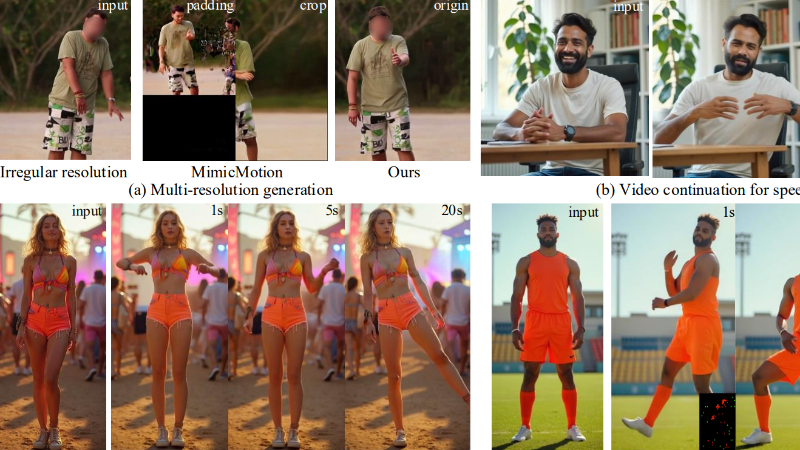

多分辨率支持:该框架支持多种视频分辨率,能够处理不同尺寸和长短的输入视频,而无需固定分辨率或填充。

-

姿态转移:HumanDiT可以从一个姿态序列生成对应的人体运动视频,实现姿态转移功能。

-

视频延续:能够从静态图像或现有视频中生成连续的运动序列,支持视频的延续生成。

-

多场景适应:通过大规模多样化数据集的训练,HumanDiT能够在多种场景和条件下生成高质量的人体运动视频。

HumanDiT技术原理

-

Diffusion Transformer(DiT):HumanDiT基于DiT架构,替代传统的U-Net扩散模型,利用扩散模型的稳定性和变换器的强大建模能力,处理多分辨率和长序列视频生成任务。

-

前缀潜在参考策略:通过3D全注意力机制,HumanDiT在扩展序列中保持个性化特征,从而在视频生成过程中保持视觉一致性。

-

Rotary Position Embedding(RoPE)和Patchify:利用RoPE和Patchify技术,DiT模型能够处理不同分辨率和序列长度的视频,增强了模型的灵活性。

-

关键点DiT(Keypoint-DiT):用于生成后续姿势序列,支持从静态图像或现有视频中继续生成视频,确保运动的连贯性。

-

姿态适配器(Pose Adapter):用于在给定序列中进行姿态转移,通过对初始姿态进行对齐和细化,提高面部和手部细节的准确性。

-

大规模数据集:开发团队收集了包含14,000小时高质量视频的大规模数据集,涵盖多种人类动作和场景,通过数据处理管道和评分模型筛选高质量样本,确保训练数据的可靠性和多样性。

-

序列并行化:通过Transformer架构和设计的姿态引导器,HumanDiT能够在时间维度上应用序列并行化,从而在多个设备上高效地训练和推理长视频序列。

HumanDiT应用场景

-

虚拟数字人:为虚拟主播、客服等生成自然流畅的动作和表情,提升交互体验。

-

动画制作:快速生成高质量的动画视频,降低制作成本,提高创作效率。

-

游戏开发:实时生成角色动作,丰富游戏中的角色表现,增强游戏的沉浸感。

-

教育与培训:创建虚拟教学场景,如医学手术模拟、体育动作教学等,提供直观的视觉辅助。

-

影视特效:辅助电影、电视剧等影视作品的特效制作,生成复杂的人体动作和场景。

-

广告与营销:制作个性化的广告视频,通过动态人物展示产品特点,吸引用户注意力。

HumanDiT项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号