WebLI100B:谷歌推出的超大规模视觉语言预训练数据集

WebLI100B简介

WebLI100B是由Google DeepMind团队开发的一个超大规模视觉语言预训练数据集,包含1000亿个图像-文本对。它是迄今为止最大的视觉语言数据集之一,旨在通过海量数据提升模型的文化多样性和多语言能力。与以往的数据集相比,WebLI100B不仅在规模上实现了突破,还通过减少数据过滤来保留更多的文化背景和低资源语言信息。这一数据集的开发为视觉语言模型的训练提供了更丰富的语料,有助于推动多模态人工智能的发展,特别是在文化包容性和多语言理解方面。

WebLI100B主要功能

-

大规模数据支持:

-

提供1000亿个图像-文本对,为视觉语言模型的预训练提供了前所未有的数据规模,有助于提升模型对复杂视觉和语言关系的理解能力。

-

支持从长尾概念到低资源语言的广泛覆盖,增强模型的文化多样性和多语言能力。

-

-

文化多样性增强:通过保留丰富的文化背景数据,提升模型在地理定位、跨文化分类等任务中的表现,减少因数据过滤导致的文化偏差。

-

多语言能力提升:包含多种语言的图像-文本对,尤其注重低资源语言的覆盖,帮助模型在多语言任务中表现出色,缩小不同语言之间的性能差距。

-

包容性系统开发:为构建真正包容的多模态系统提供基础,帮助减少模型在不同社会群体、收入水平和地理区域之间的性能差异,推动公平性和包容性的发展。

WebLI100B技术原理

-

数据收集与筛选:

-

数据来源于网络爬取的图像及其对应的文本描述(如alt-text和页面标题),通过简单过滤(如去除有害内容和隐私信息)保留数据的多样性和多语言特性。

-

避免使用可能导致文化偏差的复杂数据过滤器,如基于CLIP的过滤器,以保留更多长尾概念和文化背景。

-

-

对比学习框架:

-

使用对比学习方法对图像和文本进行联合预训练,通过大规模数据学习图像和文本之间的对齐关系,提升模型的泛化能力。

-

采用大批次训练和优化的学习率调度策略,确保模型在大规模数据上高效训练。

-

-

多语言和文化多样性优化:

-

通过语言再平衡技术,提升低资源语言在数据集中的比例,改善模型在多语言任务中的表现。

-

利用地理定位和跨文化分类等任务评估模型的文化多样性,确保数据集能够有效支持相关能力的提升。

-

-

性能与公平性评估:

-

在多个基准测试中评估模型性能,包括传统西方中心化任务、文化多样性任务、多语言任务和公平性任务,确保数据集的全面性和有效性。

-

通过分析模型在不同收入水平、地理区域和社会群体上的表现,优化数据集以减少性能差异,提升模型的公平性。

-

WebLI100B应用场景

-

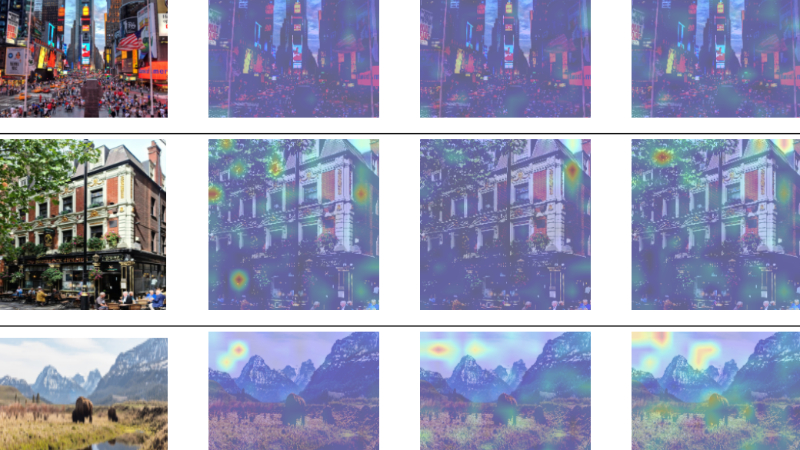

跨文化图像理解:通过丰富的文化背景数据,帮助模型更好地理解不同文化中的图像内容,例如识别具有地域特色的建筑、传统服饰或生活方式。

-

多语言图像描述生成:支持生成多种语言的图像描述,尤其在低资源语言中提升生成质量,满足不同语言用户的需求。

-

地理定位与文化分类:利用地理定位任务(如Dollar Street)评估和提升模型对不同国家或地区文化的识别能力。

-

多语言视觉问答:在多语言视觉问答任务中,模型能够理解并回答与图像相关的问题,支持多种语言的交互。

-

文化多样性评估:用于开发和评估模型在文化多样性方面的表现,帮助研究人员发现和改进模型的文化偏差问题。

-

公平性增强:通过大规模数据训练,减少模型在不同社会群体、收入水平或地理区域之间的性能差异,提升模型的公平性和包容性。

WebLI100B项目入口

- arXiv技术论文:https://arxiv.org/pdf/2502.07617

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号