AnyCharV:香中文等推出的新型可控角色视频生成框架

AnyCharV简介

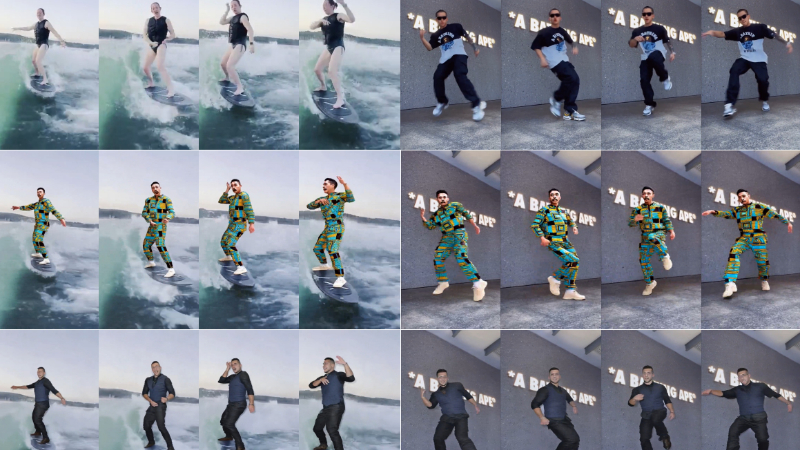

AnyCharV是由香港中文大学计算机科学与工程系、清华大学深圳国际研究生院以及香港大学统计与精算学系联合开发的一种新型可控角色视频生成框架。该框架通过细粒度到粗粒度的引导策略,实现了任意源角色到目标场景的灵活且高保真度的视频生成。开发团队提出了一种两阶段训练方法:第一阶段通过细粒度分割掩码和姿势信息将角色与场景整合,第二阶段则通过自增强机制和粗粒度掩码进一步优化生成结果,保留角色细节。AnyCharV在生成质量和效率上均优于现有的开源模型,并与领先的闭源工业产品相当,展现了强大的泛化能力和应用潜力。

AnyCharV主要功能

-

任意角色视频生成:AnyCharV能够根据给定的参考角色图像和目标驱动视频,生成高质量的角色视频,保留角色的细节和身份。

-

复杂场景合成:能够将角色自然地合成到复杂的背景场景中,处理复杂的人物与物体交互。

-

高保真度生成:通过细粒度到粗粒度的引导策略,生成的角色视频具有高保真度,避免了常见的模糊和伪影问题。

-

灵活控制:用户可以通过提供姿势信息和分割掩码,灵活控制生成视频中的角色运动和场景。

-

自增强机制:通过自增强训练策略,进一步优化生成结果,确保角色细节的保留和视频质量的提升。

AnyCharV技术原理

-

两阶段训练策略:

-

第一阶段:细粒度引导的自监督合成:

-

数据准备:从训练视频中采样参考图像和目标驱动视频,提取目标角色的分割掩码。

-

模型训练:使用分割掩码和姿势信息作为条件信号,训练模型将参考角色与目标场景进行合成。

-

细节处理:引入参考图像的CLIP特征和ReferenceNet提取的空间特征,以保留角色的外观和身份。

-

-

第二阶段:粗粒度引导的自增强训练:

-

数据对构建:通过基础模型生成视频对,包含不同角色但具有相同运动和场景。

-

自增强训练:使用粗粒度的边界框掩码代替细粒度掩码,减少掩码形状对生成结果的负面影响,增强角色细节的保留。

-

-

-

视频扩散模型(VDM):

-

通过逐步去噪生成视频,捕捉视频数据中的时间关系。

-

在每个时间步,视频扩散模型估计噪声,并通过迭代去噪过程生成高质量视频。

-

-

细粒度引导:

-

使用目标角色的分割掩码和姿势信息作为引导,确保角色在目标场景中的正确位置和运动。

-

对分割掩码进行增强处理,减少形状信息对生成结果的干扰。

-

-

粗粒度引导:

-

使用边界框掩码代替分割掩码,提供更宽松的引导,减少掩码形状对角色细节的影响。

-

通过自增强训练,进一步优化角色细节的保留。

-

-

参考特征保留:

-

引入CLIP图像编码器和ReferenceNet提取的空间特征,确保角色的外观和身份在生成过程中得以保留。

-

AnyCharV应用场景

-

影视制作:将特定角色快速合成到不同场景中,减少特效制作成本和时间。

-

动画创作:为动画角色生成自然流畅的动态视频,辅助动画师快速完成动画制作。

-

虚拟现实(VR)与增强现实(AR):为虚拟环境生成与现实场景互动的角色,提升沉浸感。

-

游戏开发:快速生成游戏中的角色动画,适应不同场景和剧情,提升开发效率。

-

广告与营销:根据需求生成特定角色的视频广告,提升内容的吸引力和个性化。

-

教育与培训:生成虚拟教师或培训角色,用于在线教育和专业技能培训,提供生动的教学内容。

AnyCharV项目入口

- 项目主页:https://anycharv.github.io/

- GitHub代码库:https://github.com/AnyCharV/AnyCharV

- arXiv技术论文:https://arxiv.org/pdf/2502.08189

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号