Step-Video-T2V:阶跃星辰开源的文本到视频预训练模型

Step-Video-T2V简介

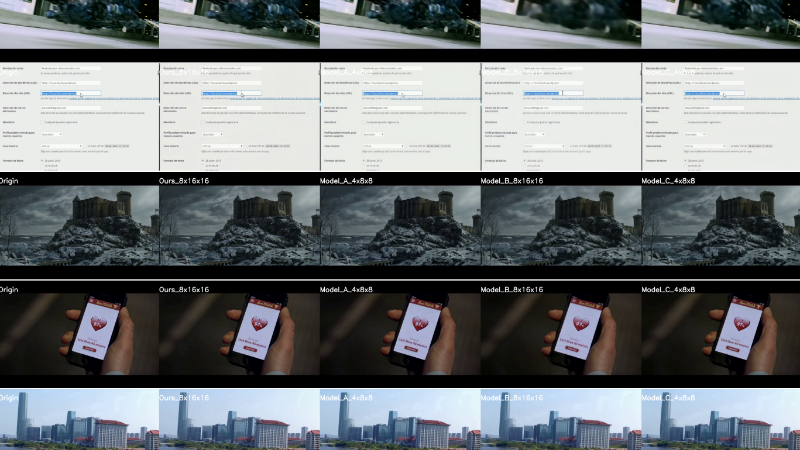

Step-Video-T2V是由阶跃星辰开源的文本到视频预训练模型,拥有300亿参数,能够生成长达204帧的高质量视频。该模型采用深度压缩的变分自编码器(Video-VAE),实现了16×16的空间压缩和8×的时间压缩,同时配备双语文本编码器,支持中文和英文提示。基于扩散的Transformer(DiT)架构和3D全注意力机制使其在生成具有强烈运动动态和高美学质量的视频方面表现出色。此外,Step-Video-T2V通过直接偏好优化(DPO)方法进一步提升了视频质量,减少了伪影并增强了视觉效果。开发团队通过级联训练策略和大规模数据预处理,确保了模型的高效训练和卓越性能。Step-Video-T2V的开源旨在推动视频基础模型的创新,并为视频内容创作者提供强大的工具。

Step-Video-T2V主要功能

-

文本到视频生成:Step-Video-T2V能够根据用户输入的文本提示生成高质量的视频,支持中文和英文提示。

-

高分辨率视频生成:模型可以生成分辨率高达544×992的视频,长度可达204帧。

-

多模态输入处理:除了文本输入,模型还能够处理视觉或多模态输入,生成相应的视频内容。

-

视频质量优化:通过直接偏好优化(DPO)方法,减少生成视频中的伪影,提升视觉质量,使视频输出更加平滑和真实。

-

开源和评估基准:Step-Video-T2V及其评估基准Step-Video-T2V-Eval均已开源,便于研究人员和开发者进行进一步的研究和应用。

Step-Video-T2V技术原理

-

深度压缩变分自编码器(Video-VAE):

-

压缩比:实现了16×16的空间压缩和8×的时间压缩,显著降低了视频生成任务的计算复杂度。

-

架构设计:采用双路径架构,在编码器的后期和解码器的早期阶段进行统一的空间-时间压缩。

-

-

双语文本编码器:

-

Hunyuan-CLIP:一个双向文本编码器,能够生成与视觉空间对齐的文本表示,但最大输入长度限制为77个标记。

-

Step-LLM:一个单向文本编码器,预训练任务为下一个标记预测任务,能够处理更长的文本序列。

-

-

基于扩散的Transformer(DiT):

-

3D全注意力机制:结合空间和时间信息,提供更高的建模能力,特别是在生成具有平滑和一致运动的视频方面表现出色。

-

交叉注意力层:在每个Transformer块中引入交叉注意力层,将文本提示与视觉特征相结合。

-

-

直接偏好优化(DPO):

-

人类反馈整合:通过人类反馈数据进行模型优化,提升生成视频的视觉质量和一致性。

-

训练过程:使用人类偏好数据和非偏好数据进行训练,调整模型生成偏好数据的能力,同时避免生成非偏好数据。

-

-

训练策略:

-

级联训练流程:包括文本到图像(T2I)预训练、文本到视频/图像(T2VI)预训练、文本到视频(T2V)微调和直接偏好优化(DPO)训练。

-

数据预处理:通过视频分割、质量评估、运动评估、字幕生成、概念平衡和文本对齐等步骤,将原始视频转换为适合模型预训练的高质量数据。

-

-

系统优化:

-

Step Emulator:用于估计资源消耗和端到端性能,优化模型架构和并行策略。

-

分布式训练:采用张量并行(TP)、序列并行(SP)和Zero1优化,实现高效的模型训练。

-

StepRPC:高性能通信框架,支持跨集群通信,优化数据传输效率。

-

StepTelemetry:双层监控系统,收集训练过程中的详细数据统计和性能指标,帮助识别潜在性能瓶颈。

-

Step-Video-T2V应用场景

-

视频内容创作:根据文本提示快速生成创意视频,帮助创作者节省时间和精力,降低视频制作门槛。

-

广告制作:为品牌和广告商生成个性化的视频广告内容,提升广告的吸引力和传播效果。

-

教育与培训:生成教学视频,帮助学生更好地理解和记忆知识,丰富教育资源。

-

娱乐与影视:为影视制作提供创意素材,辅助生成特效、动画或短剧片段,加速创作流程。

-

社交媒体:为用户提供个性化的视频生成工具,丰富社交平台的内容生态,提升用户互动性。

-

虚拟现实与游戏:生成虚拟场景、角色动画或游戏过场动画,增强沉浸感和用户体验。

Step-Video-T2V项目入口

- GitHub代码库:https://github.com/stepfun-ai/Step-Video-T2V

- arXiv技术论文:https://arxiv.org/abs/2502.10248

- Hugging Face模型:https://huggingface.co/stepfun-ai/stepvideo-t2v

- 在线体验:https://yuewen.cn/videos

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号