SongGen:通过文本输入实现歌曲生成

SongGen简介

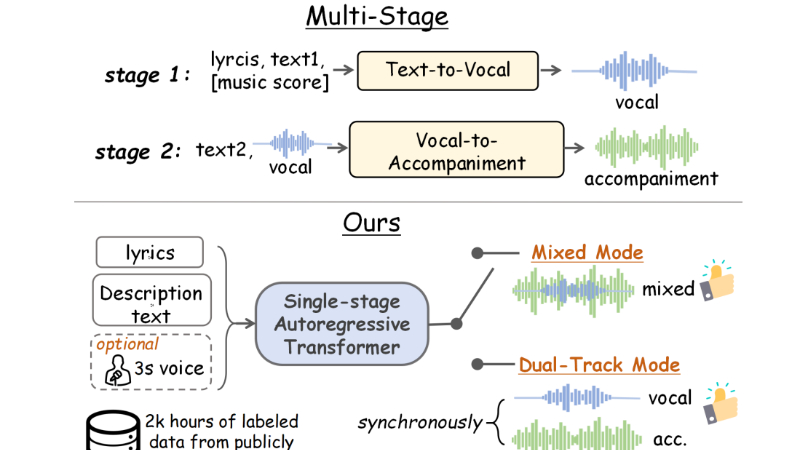

SongGen是由北京航空航天大学、上海人工智能实验室和香港中文大学联合开发的单阶段自回归Transformer模型,旨在通过文本输入实现歌曲生成。该模型支持混合模式和双轨模式,能够根据歌词、文本描述以及可选的参考声音生成人声和伴奏。开发团队通过创新的音频标记化策略和条件输入设计,实现了对歌曲风格、情绪和音色的细粒度控制,并开发了自动化数据预处理流程以解决数据稀缺问题。SongGen的开源特性为音乐创作提供了高效、灵活的解决方案,也为未来的研究奠定了基础。

SongGen主要功能

-

文本到歌曲生成:SongGen能够根据用户提供的文本描述(如歌词、音乐风格、情绪、乐器等)生成完整的歌曲,包括人声和伴奏。

-

细粒度控制:用户可以通过歌词、文本描述和参考声音对生成的歌曲进行细粒度控制,调整歌曲的风格、情绪、音色等属性。

-

支持多种输出模式:提供混合模式(直接生成人声与伴奏的混合音频)和双轨模式(分别生成人声和伴奏),满足不同场景下的需求。

-

零样本声音克隆:用户可以提供一个三秒的参考声音片段,模型能够克隆该声音的音色,生成具有相似音色的歌曲。

-

高质量数据预处理:开发团队设计了自动化数据预处理流程,确保生成的歌曲具有高质量和高保真度。

-

开源与社区支持:SongGen完全开源,提供模型权重、训练代码、注释数据和预处理流程,便于社区参与和未来研究扩展。

SongGen技术原理

-

单阶段自回归Transformer架构

SongGen基于自回归Transformer架构,通过单个模型直接生成歌曲,避免了传统多阶段方法的复杂性和效率问题。 -

音频标记化与编码

使用X-Codec将音频信号编码为离散的音频标记,这些标记能够同时捕捉音频的声学和语义信息,为Transformer模型提供输入。 -

混合模式与双轨模式

-

混合模式:直接生成混合音频标记,通过辅助人声标记预测目标增强人声学习,解决混合音频中人声信号弱的问题。

-

双轨模式:将人声和伴奏分开处理,并通过并行或交错的方式同步生成,确保两者在帧级别上的对齐。

-

-

条件输入与交叉注意力机制

将歌词、文本描述和参考声音分别通过编码器处理后,通过交叉注意力机制整合到模型中,实现对生成歌曲的细粒度控制。 -

自动化数据预处理

开发了自动化数据预处理流程,包括音频分离、语音活动检测、歌词识别和伪字幕生成,以解决公开数据稀缺的问题。 -

训练策略

采用分阶段训练策略,包括模态对齐、无参考声音支持和高质量微调,逐步提升模型性能。同时,引入课程学习策略调整音频标记的损失权重,优化训练过程。 -

高质量音频生成

使用X-Codec进行音频解码,确保生成的音频具有高保真度和自然性。

SongGen应用场景

-

音乐创作与制作:为音乐人和创作者提供高效工具,快速生成歌曲原型,节省创作时间和成本,激发灵感。

-

内容创作与视频配乐:为视频创作者生成与内容风格匹配的背景音乐或主题曲,提升视频的整体效果。

-

游戏与互动娱乐:为游戏生成符合场景氛围的音乐,增强玩家的沉浸感,甚至可以根据游戏情节实时生成音乐。

-

广告与营销:为广告和品牌宣传生成定制化歌曲,提升品牌吸引力和用户记忆度。

-

教育与培训:在音乐教育中辅助教学,生成不同风格和难度的歌曲,帮助学生练习和理解音乐创作。

-

个性化音乐体验:根据用户输入的歌词或风格偏好生成个性化歌曲,满足用户对独特音乐的需求。

SongGen项目入口

- GitHub代码库:https://github.com/LiuZH-19/SongGen

- arXiv技术论文:https://arxiv.org/pdf/2502.13128

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号