VideoGrain:悉尼科技大学等推出的视频编辑框架

VideoGrain简介

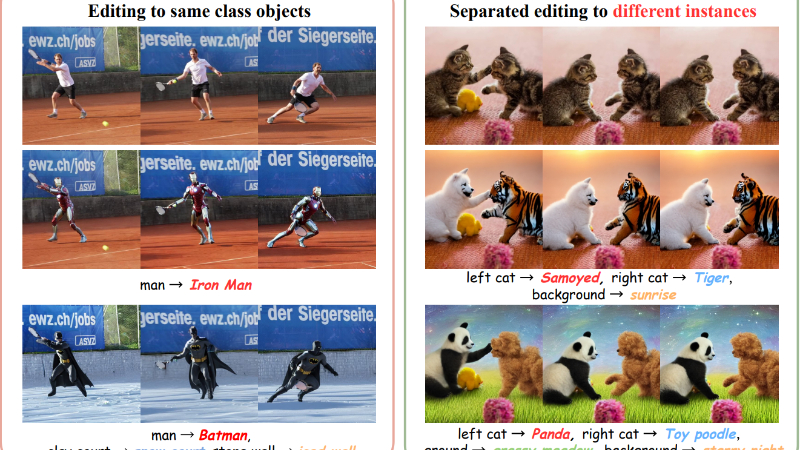

VideoGrain是由悉尼科技大学ReLER实验室和浙江大学ReLER实验室联合开发的一种创新的多粒度视频编辑框架。该技术通过调节时空注意力机制,实现了类别级、实例级和部件级的精细视频编辑。开发团队提出了一种名为“时空布局引导注意力(ST-Layout Attn)”的框架,通过增强文本到区域的控制和保持特征分离,解决了传统扩散模型在多粒度编辑中的语义对齐和特征耦合问题。VideoGrain无需额外参数调整,即可在多种基准测试和现实场景中实现高质量的视频编辑,展现了卓越的性能和效率。

VideoGrain主要功能

-

多粒度视频编辑:

-

支持类别级编辑,例如将视频中的所有“人”替换为“蜘蛛侠”。

-

支持实例级编辑,能够将视频中不同的实例分别替换为不同的对象,例如将“左边的人”替换为“钢铁侠”,“右边的人”替换为“北极熊”。

-

支持部件级编辑,可以在对象的局部进行修改,例如为人物添加“太阳镜”或改变服装颜色。

-

-

零样本编辑能力:

-

不需要对模型进行额外的参数调整或训练,直接基于预训练的扩散模型实现编辑,具有高效性和通用性。

-

-

时空一致性:

-

在编辑过程中保持视频的时间连贯性,避免出现帧之间的闪烁或不自然的过渡。

-

-

高精度文本到区域控制:

-

通过精确的注意力权重分布,确保文本提示能够准确地作用于指定的视频区域,避免特征混合。

-

-

特征分离:

-

在编辑过程中保持不同实例或区域之间的特征独立性,避免因类别相似而导致的特征耦合问题。

-

VideoGrain技术原理

-

时空布局引导注意力(ST-Layout Attn):

-

交叉注意力调节:通过增强局部提示对其对应空间区域的注意力,同时抑制对无关区域的注意力,实现文本到区域的精准控制。

-

自注意力调节:通过增加区域内注意力和减少区域间干扰,确保每个查询只关注其目标区域,避免特征混合。

-

-

注意力权重分布:

-

在交叉注意力层中,将文本提示与目标区域绑定为正对,与非目标区域绑定为负对,通过调整权重实现精准的区域控制。

-

在自注意力层中,通过增强正对的注意力和限制负对的交互,避免特征在不同实例之间的混合。

-

-

时空一致性增强:

-

将视频视为“更大的图像”,通过时空自注意力机制增强帧间交互,同时保持全局一致性,避免因局部编辑导致的帧间不连贯。

-

-

基于扩散模型的零样本编辑:

-

利用预训练的扩散模型(如Stable Diffusion),通过DDIM逆过程获取噪声潜变量,并在去噪过程中应用ST-Layout Attn进行编辑,无需额外训练。

-

-

实例分割与布局引导:

-

使用SAM-Track等实例分割技术获取视频中不同实例的掩码,结合自注意力特征聚类,为编辑提供精确的布局引导。

-

-

特征保持与背景保护:

-

通过Latent Blend技术,在编辑目标区域的同时保持背景或其他未编辑区域的原始特征,确保编辑的自然性和一致性。

-

VideoGrain应用场景

-

影视特效制作:快速替换或修改视频中的角色、场景元素,如将普通人物替换为超级英雄,或改变背景环境。

-

广告视频定制:根据不同的广告需求,快速调整视频中的产品、人物或场景,实现个性化定制。

-

视频内容创作:创作者可以轻松修改视频中的元素,添加创意元素或调整风格,提升内容吸引力。

-

教育视频制作:将视频中的教学对象替换为更具教育意义的内容,如将动物替换为濒危物种,增强教育效果。

-

游戏视频编辑:修改游戏视频中的角色外观或场景,用于游戏预告片制作或玩家自定义内容创作。

-

社交媒体内容优化:用户可以快速调整视频中的元素,如更换服装、背景或添加特效,提升视频的趣味性和吸引力。

VideoGrain项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号