ARTalk:通过语音输入实时生成逼真的3D面部动画和头部动作

ARTalk简介

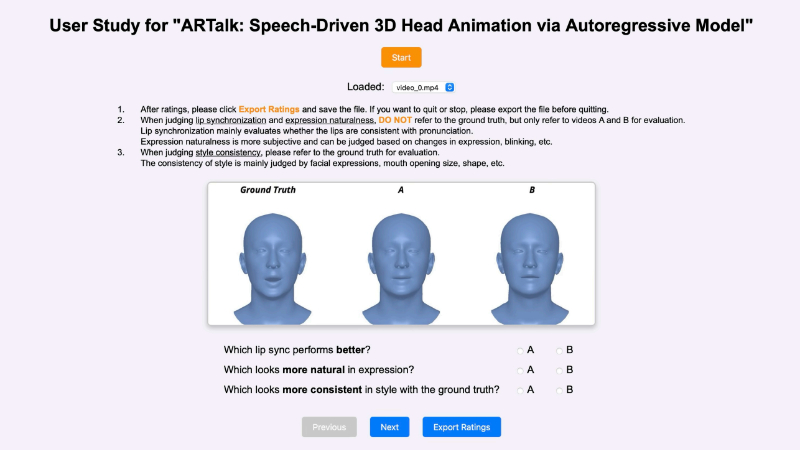

ARTalk是由东京大学和RIKEN AIP的研究团队共同开发的一种新型自回归模型,旨在通过语音输入实时生成逼真的3D面部动画和头部动作。该模型通过学习语音到多尺度运动码本的映射,能够生成高度同步的嘴唇动作、自然的面部表情以及逼真的头部姿态和眨眼动作。与现有方法相比,ARTalk不仅在嘴唇同步精度和表情自然性方面表现出色,还具备强大的风格适应能力,能够为未见过的说话风格生成个性化的动画。其高效的实时生成能力使其在虚拟现实、游戏动画、电影制作和人机交互等领域具有广阔的应用前景。

ARTalk主要功能

-

实时生成3D面部动画:ARTalk能够从任意音频片段实时生成逼真的3D面部动画,包括嘴唇动作、面部表情和头部姿态,适用于虚拟现实、游戏动画、电影制作和人机交互等场景。

-

高精度嘴唇同步:通过学习语音与面部动作的复杂映射关系,ARTalk可以生成高度同步的嘴唇动作,精确匹配语音中的音素变化,显著提升动画的真实感。

-

个性化风格适应:ARTalk能够适应未见过的说话风格,通过样本运动序列提取风格特征,为不同说话者生成具有独特个人风格的3D动画,而不仅限于训练时见过的身份。

-

自然的头部姿态生成:除了面部表情,ARTalk还能生成自然的头部动作和眨眼行为,进一步增强动画的真实性和自然感。

-

高效低延迟的实时性能:ARTalk采用自回归模型和多尺度编码技术,能够在保持高质量动画生成的同时,实现低延迟的实时渲染,适合对性能要求较高的应用场景。

ARTalk技术原理

-

时间多尺度VQ自编码器:ARTalk通过时间多尺度VQ自编码器将运动序列编码为多尺度离散码本,捕捉不同时间分辨率下的运动信息。这种多尺度表示能够有效处理复杂的语音到动作映射关系,同时保留运动的细节和风格特征。

-

自回归生成器:ARTalk的核心是自回归生成器,它基于当前时间窗口的语音特征和前一时间窗口的运动信息,逐步生成多尺度运动码。这种两层自回归机制确保了动作生成的时间连贯性和与语音的高度同步性。

-

因果推理机制:为了确保长时间序列的稳定性,ARTalk引入因果推理机制,通过因果掩码防止未来信息泄露,确保每个时间窗口的预测仅依赖于已观察到的信息,从而避免时间不连续性。

-

风格编码器:ARTalk通过Transformer风格编码器从样本运动片段中提取风格特征,将其融入运动生成过程中,从而实现个性化风格的适应。这一机制显著降低了语音与动作之间复杂映射的难度。

-

语音特征提取:ARTalk使用预训练的语音编码器(如HuBERT)从音频中提取特征,这些特征作为自回归生成器的条件输入,驱动3D面部动画的生成。语音特征的准确提取是实现高质量动画的关键。

-

FLAME模型:ARTalk基于FLAME(3D形变模型)表示面部运动,将复杂的网格顶点运动转化为低维的形变参数,简化了运动建模的复杂性,同时保留了表情和动作的细节。

ARTalk应用场景

-

虚拟现实(VR)与增强现实(AR):在VR/AR中,为虚拟角色实时生成逼真的3D面部动画,提升沉浸感。

-

游戏动画:用于游戏角色的实时表情生成,使角色反应更加自然和生动。

-

电影与影视制作:为动画电影或特效场景快速生成高质量的3D面部动画,节省制作成本。

-

虚拟主播与直播:为虚拟主播提供实时表情驱动,增强互动性和观众体验。

-

语言学习与教育:通过生成逼真的说话头像,帮助学习者更好地模仿发音和表情。

-

人机交互:在智能助手或客服场景中,为虚拟形象提供自然的表情和动作,提升交互的自然感。

ARTalk项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号