HumanOmni简介

HumanOmni是由阿里通义实验室联合中山大学ISEE团队和南开大学VCIP团队共同开发的人类中心视频理解多模态大模型。该模型专注于人类中心场景的理解,能够同时处理视觉和语音信息,通过创新的架构设计和大规模数据集训练,显著提升了对复杂人类行为和情感的识别能力。HumanOmni包含三个专门的分支,分别针对面部、身体和交互相关场景进行优化,并通过指令驱动的动态特征融合模块,根据任务需求灵活调整特征权重。开发团队通过构建超过240万段人类中心视频片段的数据集,并结合超过1400万条指令进行训练,使模型在情感识别、面部表情描述和行为理解等任务上达到行业领先水平。

HumanOmni主要功能

-

人类中心场景理解:能够同时处理视觉和语音信息,全面理解人类在视频中的行为、情感、表情以及与环境的交互。

-

多模态输入支持:支持视频、音频和文本的多模态输入,能够根据任务需求动态调整对不同模态的依赖程度。

-

情感与表情识别:通过分析视频中人物的面部表情和语音语调,准确识别情感状态(如快乐、悲伤、惊讶等)。

-

行为与动作理解:识别和描述人物在视频中的动作和行为序列,支持复杂行为的分析和理解。

-

交互分析:分析人物与环境或物体之间的交互关系,提供对场景的深度语义理解。

-

跨模态交互:整合视觉和听觉信息,支持多模态任务(如音频辅助的情感识别或视觉辅助的语音理解)。

-

指令驱动的动态调整:根据用户指令动态调整模型的特征融合权重,灵活适应不同任务需求。

HumanOmni技术原理

-

多分支架构:

-

设计了三个专门的分支(面部相关、身体相关、交互相关),分别提取不同类型的特征,以适应多样化的任务需求。

-

通过指令驱动的融合模块动态调整各分支的特征权重,实现灵活的特征融合。

-

-

多模态特征融合:

-

使用先进的视觉编码器(如SigLIP)和听觉编码器(如Whisper-large-v3)分别提取视觉和听觉特征。

-

通过投影器将视觉和听觉特征映射到统一的文本域,并与文本特征进行融合。

-

-

指令驱动的动态调整:

-

利用BERT对用户指令进行编码,提取语义信息。

-

通过多层感知机(MLP)根据指令生成动态权重,调整不同分支的特征贡献,以适应不同任务。

-

-

大规模数据集训练:

-

构建了超过240万段人类中心视频的数据集,并生成超过1400万条指令用于预训练。

-

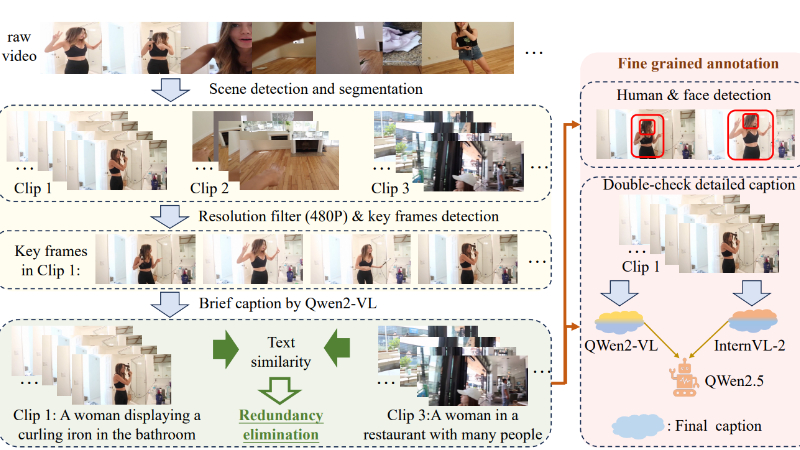

数据集经过场景分割、关键帧检测、去重和细粒度标注等处理,确保高质量和多样化。

-

-

跨模态交互训练:

-

结合视觉和听觉数据进行联合训练,增强模型对复杂场景的综合理解能力。

-

支持纯视觉、纯音频以及视听结合的输入,模型根据输入模态自动调整处理策略。

-

-

多任务适应性:

-

通过预训练和微调,使模型在情感识别、面部表情描述、行为理解等任务上表现出色。

-

支持跨模态任务,如音频辅助的情感识别或视觉辅助的语音理解。

-

HumanOmni应用场景

-

情感分析与心理健康监测:通过分析视频中人物的表情和语音语调,实时监测情绪状态,应用于心理健康评估、客服情绪管理等场景。

-

智能教育:识别学生在课堂视频中的注意力和情绪反应,帮助教师优化教学内容和方法,提升教学效果。

-

视频内容审核与推荐:分析视频中的人物行为和情感,用于内容审核(如识别不良情绪或不当行为)或个性化推荐(根据用户情绪偏好推荐内容)。

-

智能客服与虚拟助手:结合语音和视觉信息,提供更精准的客户服务,例如通过识别用户的情绪状态调整服务策略。

-

医疗辅助:在远程医疗中分析患者的表情和语音,辅助医生判断患者的情绪和身体状态,提升诊断效率。

-

智能安防监控:实时分析监控视频中人员的行为和情绪,及时发现异常行为或潜在风险,提高安防监控的智能化水平。

HumanOmni项目入口

- Github代码库:https://github.com/HumanMLLM/HumanOmni

- HuggingFace:https://huggingface.co/StarJiaxing/HumanOmni-7B

- arXiv技术论文:https://arxiv.org/pdf/2501.15111

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号