Distill Any Depth:知识蒸馏框架的单目深度估计方法

Distill Any Depth简介

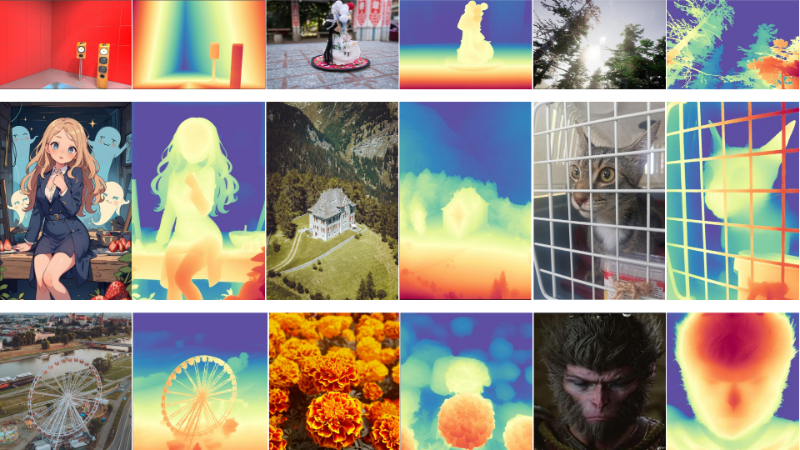

“Distill Any Depth”是由浙江工业大学、西湖大学AGI实验室、兰州大学和南洋理工大学联合开发的一种新型单目深度估计方法。该方法通过知识蒸馏技术,将多个深度估计模型的优势整合到一个高效的学生模型中,显著提升了深度预测的准确性和泛化能力。团队提出了一种跨上下文蒸馏框架,结合全局与局部深度线索,优化伪标签质量,并引入多教师蒸馏机制,利用不同模型的互补优势,进一步提高深度估计的细节表现和鲁棒性。该方法在多个基准数据集上取得了优异的性能,为单目深度估计领域提供了新的研究方向。

Distill Any Depth主要功能

-

提升单目深度估计的泛化能力:通过知识蒸馏技术,利用大规模未标注数据训练模型,使其能够更好地适应多样化场景和未知环境。

-

优化深度预测的细节与准确性:结合局部和全局深度信息,生成更精细的深度细节,同时保持整体深度结构的准确性。

-

整合多种深度模型的优势:通过多教师蒸馏框架,融合扩散模型和编码器-解码器模型的优点,兼顾细节表现和计算效率。

-

零样本学习能力:无需大规模标注数据,直接利用未标注数据进行训练,显著降低对标注数据的依赖,提升模型在新场景下的适应性。

Distill Any Depth技术原理

-

深度归一化策略:

-

提出混合归一化(Hybrid Normalization)和局部归一化(Local Normalization),结合全局和局部深度信息,优化伪标签的质量,避免全局归一化带来的噪声放大问题。

-

通过分段归一化或局部区域归一化,减少深度预测中的误差传播,提升细粒度深度细节的表现。

-

-

跨上下文蒸馏(Cross-Context Distillation):

-

共享上下文蒸馏(Shared-Context Distillation):教师和学生模型使用相同的局部裁剪图像作为输入,使学生模型学习局部深度细节。

-

局部-全局蒸馏(Local-Global Distillation):教师模型预测局部深度,学生模型预测全局深度,通过监督学生模型的全局预测与教师模型的局部预测一致,实现细粒度细节与整体结构的结合。

-

-

多教师蒸馏(Multi-Teacher Distillation):随机选择多个预训练的深度估计模型(如扩散模型和编码器-解码器模型)生成伪标签,利用不同模型的优势,提升学生模型的泛化能力和深度预测精度。

-

零样本学习与伪标签生成:利用大规模未标注图像,通过教师模型生成伪深度标签,指导学生模型的训练,避免对标注数据的依赖,提升模型在未见场景下的性能。

-

损失函数设计:结合多种损失函数(如局部-全局一致性损失、特征对齐损失和梯度保持损失),优化学生模型的训练过程,确保深度预测的准确性和鲁棒性。

Distill Any Depth应用场景

-

自动驾驶:用于实时感知车辆周围环境的深度信息,辅助车辆进行障碍物检测、路径规划和安全驾驶。

-

机器人导航:帮助机器人在复杂环境中进行自主导航,识别地形和障碍物,实现精准避障和路径规划。

-

增强现实(AR):为 AR 设备提供场景深度信息,增强虚拟物体与现实环境的融合效果,提升用户体验。

-

无人机飞行:辅助无人机进行地形测绘和避障,确保飞行安全,同时可用于环境监测和目标跟踪。

-

3D 场景重建:通过单目图像生成高精度深度图,用于室内建模、文化遗产保护和虚拟现实(VR)内容创作。

-

智能安防监控:在监控系统中实时分析场景深度,实现目标检测、行为分析和异常事件预警,提升安防效率。

Distill Any Depth项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号