X-Dancer:从单张静态图像生成与音乐同步的全身舞蹈视频

X-Dancer简介

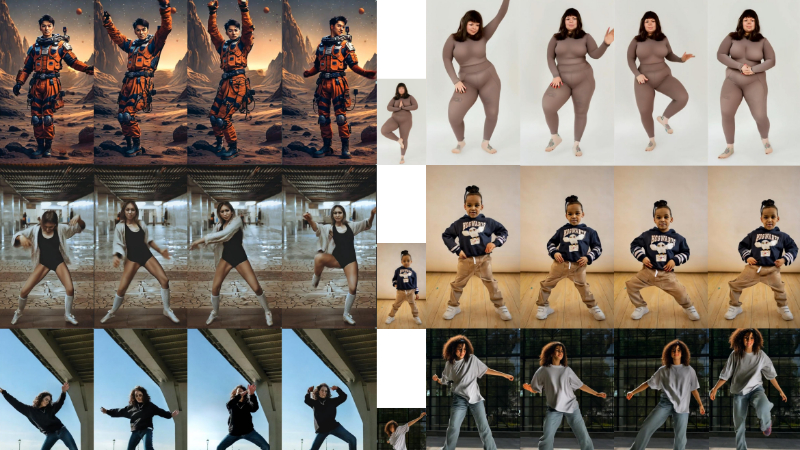

X-Dancer是由字节联合加州大学圣地亚哥分校和南加州大学推出的创新框架,旨在从单张静态图像生成与音乐同步的全身舞蹈视频。该框架结合了自回归Transformer和扩散模型,通过2D人体姿态建模,利用广泛可用的单目舞蹈视频数据,生成高质量、多样化的舞蹈动作,并将其转化为逼真的视频内容。X-Dancer在运动多样性、音乐对齐和视频质量方面均达到行业领先水平,同时具备强大的可扩展性和适应性,能够通过少量样本微调以生成特定风格的舞蹈编排。

X-Dancer主要功能

-

从单张静态图像生成舞蹈视频:X-Dancer能够以单张人物静态图像作为输入,并结合音乐,生成与音乐节奏同步的全身舞蹈视频。生成的视频不仅包含丰富的舞蹈动作,还能保持与输入图像中人物的外观和背景一致。

-

多样化和富有表现力的舞蹈动作生成:该框架可以生成高度多样化的舞蹈动作,涵盖全身各个部位(包括头部、手部和身体),并根据不同音乐风格和节奏生成具有表现力的舞蹈编排。

-

零样本(Zero-shot)生成能力:X-Dancer无需针对特定人物或舞蹈风格进行预训练,即可直接生成舞蹈视频,具有很强的泛化能力,能够适应各种输入图像和音乐。

-

支持个性化编舞生成:通过少量样本舞蹈视频的微调,X-Dancer能够快速适应特定的舞蹈风格或编舞,生成符合特定需求的舞蹈视频。

X-Dancer技术原理

-

Transformer-Diffusion框架:X-Dancer结合了自回归Transformer和扩散模型(Diffusion Model)。Transformer用于生成与音乐同步的2D人体姿态序列,捕捉复杂的舞蹈动作与音乐节奏的非线性关系;扩散模型则负责将生成的姿态序列转化为逼真的视频帧,确保视频的质量和连贯性。

-

2D姿态建模与多部分标记化:该框架采用2D姿态建模,利用单目视频数据中的姿态信息,避免了3D姿态估计的复杂性和误差。同时,通过多部分标记化(如身体、头部、手部分别编码),捕捉不同频率和幅度的运动细节,增强生成动作的多样性和表现力。

-

音乐特征嵌入与同步:使用预训练的Jukebox模型和Librosa工具提取音乐特征,包括旋律、节奏和节拍信息,并将其嵌入到舞蹈动作生成过程中,确保生成的舞蹈动作与音乐节奏精确对齐。

-

可训练的运动解码器:通过一个可训练的运动解码器,将生成的1D姿态标记隐式转换为2D空间引导信号,直接融入扩散模型的特征空间,避免了传统方法中因显式姿态可视化导致的信息丢失和不连贯性。

-

端到端可微分框架:X-Dancer实现了从姿态生成到视频合成的端到端可微分训练,使得模型能够在全局优化过程中学习到最优的运动和视觉生成策略,同时保持生成内容的高质量和一致性。

X-Dancer应用场景

-

社交媒体娱乐:用户可以上传自己的照片,结合喜欢的音乐,快速生成个性化的舞蹈视频,用于分享到TikTok、抖音等平台,增加互动性和趣味性。

-

虚拟形象与数字人:为虚拟主播、数字人生成与音乐同步的舞蹈动作,丰富虚拟形象的表现力,提升用户体验。

-

在线教育与健身:生成舞蹈教学视频,帮助用户学习舞蹈动作和节奏感,也可用于健身操视频的创作,增加趣味性和吸引力。

-

广告与营销:品牌可以利用X-Dancer生成与产品相关的创意舞蹈视频,用于广告宣传,吸引年轻用户群体,提升品牌影响力。

-

游戏与互动娱乐:在游戏场景中,为角色生成舞蹈动作,增强游戏的趣味性和沉浸感,也可用于互动娱乐应用,如音乐节奏游戏。

-

影视与动画制作:为影视作品或动画生成舞蹈片段,快速生成创意草稿,辅助导演和动画师进行创作,节省时间和成本。

X-Dancer项目入口

- arXiv技术论文:https://arxiv.org/pdf/2502.17414

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号