Nexus-O简介

Nexus-O是由HiThink Research联合多家知名机构共同开发的多模态交互模型,旨在通过整合音频、图像/视频和文本数据,实现高效的人机交互和多模态理解。开发团队汇聚了来自Imperial College London、University of Manchester、浙江大学、复旦大学、微软、Meta AI等顶尖高校和企业的人工智能专家。Nexus-O基于视觉-语言模型设计,通过高质量合成音频数据的预训练,实现了三模态感知和交互能力。该模型不仅在视觉理解、音频问答、自动语音识别等任务中表现出色,还通过创新的音频数据合成和测试集开发,提升了模型在真实场景中的鲁棒性。开发团队致力于将Nexus-O打造成推动多模态人工智能发展的前沿平台。

Nexus-O主要功能

-

多模态感知与交互:Nexus-O能够处理音频、图像/视频和文本的任意组合输入,并以音频或文本的形式输出,支持端到端的交互方式。它适用于多种场景,如视频会议、直播、语音助手等。

-

强大的语言和视觉理解能力:模型在视觉理解(如图像和视频分析)、语言处理(如文本生成、对话交互)以及音频处理(如语音识别、语音生成)等任务上表现出色,能够处理复杂的多模态任务。

-

高质量语音合成与识别:Nexus-O具备先进的语音合成和自动语音识别(ASR)能力,能够将文本转换为自然语音,或将语音转换为文本,支持多种语言和方言。

-

多模态对齐与推理:模型通过视觉、语言和音频模态的对齐,实现跨模态的理解和推理,例如通过语音描述图像内容或根据图像生成语音说明。

-

适应真实场景的鲁棒性:Nexus-O通过高质量的合成数据和真实场景数据训练,具备在复杂环境(如会议、直播)中稳定运行的能力。

Nexus-O技术原理

-

基于视觉-语言模型的架构:Nexus-O以视觉-语言模型Qwen2.5-VL为基础架构,通过引入音频模态,实现三模态的对齐和交互。模型包含视觉编码器、音频编码器/解码器和语言模型,支持多模态输入和输出。

-

多阶段预训练策略

-

音频对齐阶段:通过大规模双语语音-文本对进行预训练,使模型能够理解语音输入并生成相应的文本。

-

指令跟随阶段:通过冻结视觉和音频编码器,解冻适配器和语言模型,增强模型对多模态指令的理解能力。

-

语音输出调整阶段:训练音频解码器,实现端到端的语音生成。

-

-

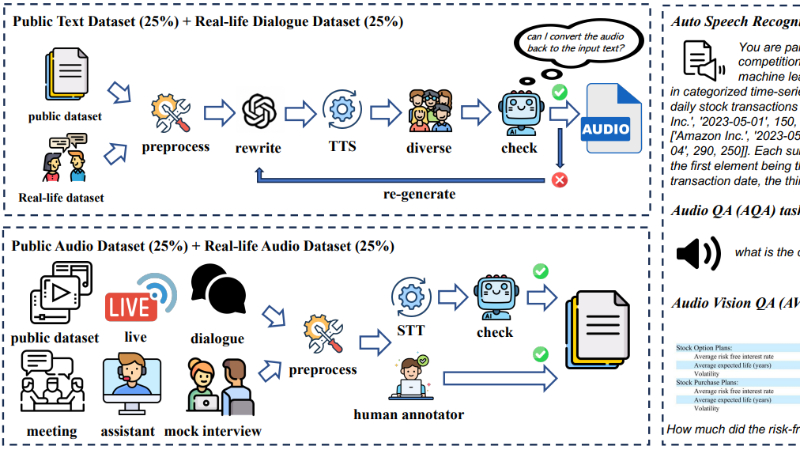

高质量语音数据合成:开发团队设计了语音数据合成管道,通过公共数据集和真实对话数据生成高质量的语音训练数据,覆盖多种真实场景(如会议、直播)。

-

表示空间对齐技术:Nexus-O通过核对齐度量评估视觉、语言和音频模态在解嵌阶段和嵌入阶段的表示对齐,通过引入音频模态增强视觉和语言模态的对齐效果。

-

多模态任务的深度评估:模型通过多种基准测试(如视觉理解、音频问答、自动语音识别)验证其性能,并通过自研的Nexus-O-audio测试集评估模型在真实场景中的鲁棒性。

-

端到端的语音处理能力:Nexus-O的音频解码器采用自回归方式生成离散语音代码,并通过预训练的生成器合成最终音频输出,支持高质量的语音合成和交互。

Nexus-O应用场景

-

基于视觉-语言模型的架构

Nexus-O以视觉-语言模型Qwen2.5-VL为基础架构,通过引入音频模态,实现三模态的对齐和交互。模型包含视觉编码器、音频编码器/解码器和语言模型,支持多模态输入和输出。 -

多阶段预训练策略

-

音频对齐阶段:通过大规模双语语音-文本对进行预训练,使模型能够理解语音输入并生成相应的文本。

-

指令跟随阶段:通过冻结视觉和音频编码器,解冻适配器和语言模型,增强模型对多模态指令的理解能力。

-

语音输出调整阶段:训练音频解码器,实现端到端的语音生成。

-

-

高质量语音数据合成

开发团队设计了语音数据合成管道,通过公共数据集和真实对话数据生成高质量的语音训练数据,覆盖多种真实场景(如会议、直播)。 -

表示空间对齐技术

Nexus-O通过核对齐度量评估视觉、语言和音频模态在解嵌阶段和嵌入阶段的表示对齐,通过引入音频模态增强视觉和语言模态的对齐效果。 -

多模态任务的深度评估

模型通过多种基准测试(如视觉理解、音频问答、自动语音识别)验证其性能,并通过自研的Nexus-O-audio测试集评估模型在真实场景中的鲁棒性。 -

端到端的语音处理能力

Nexus-O的音频解码器采用自回归方式生成离散语音代码,并通过预训练的生成器合成最终音频输出,支持高质量的语音合成和交互。

Nexus-O项目入口

- arXiv技术论文:https://arxiv.org/pdf/2503.01879

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号