GEN3C:英伟达等推出的新型生成式视频模型

GEN3C简介

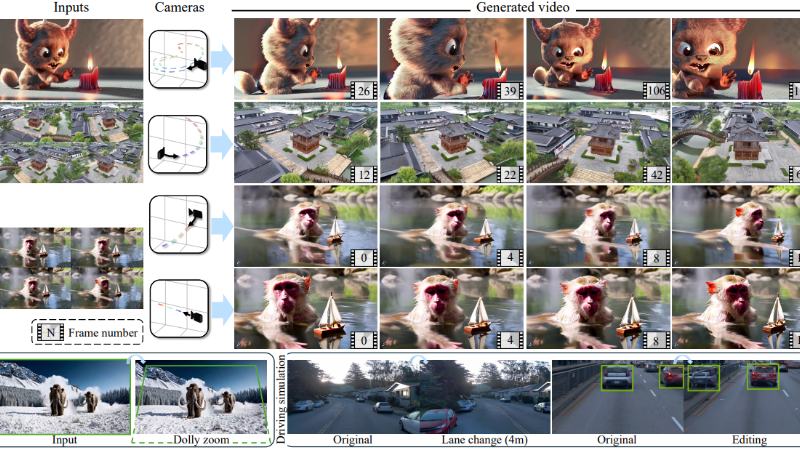

GEN3C是由NVIDIA、多伦多大学和向量研究所联合开发的一种新型生成式视频模型。它通过构建一个显式的3D缓存来指导视频生成,实现了精确的相机控制和时间一致性的3D视频生成。GEN3C利用预测的像素深度信息将输入图像或视频帧反投影到3D空间,形成点云,并根据用户指定的相机轨迹渲染这些点云,为视频生成提供强大的条件信号。这种方法不仅解决了传统视频生成模型中因缺乏3D信息而导致的不一致性问题,还支持稀疏视图新视图合成、动态视频新视图合成以及驾驶模拟等多种应用场景。GEN3C在生成质量和相机控制精度上均优于现有方法,为视频生成领域带来了新的突破。

GEN3C主要功能

-

精确的相机控制:GEN3C能够根据用户指定的相机轨迹生成视频,精确控制相机的运动,包括平移、旋转和焦距变化等,实现高质量的视图合成。

-

稀疏视图新视图合成:即使输入视图非常稀疏(如单视图或多视图),GEN3C也能生成高质量的新视图,填补视图间的空白。

-

动态场景合成:对于包含动态对象的视频,GEN3C能够生成符合新相机轨迹的动态视频,同时保留场景的动态内容。

-

3D编辑与场景操作:通过修改3D缓存(如移除或添加对象、调整轨迹),GEN3C可以实现对场景的编辑和重模拟。

-

长视频生成:通过自回归生成和3D缓存更新,GEN3C能够生成长视频,同时保持时间一致性,避免内容丢失或不一致。

-

支持多种应用场景:GEN3C适用于多种领域,包括电影制作、VR/AR、自动驾驶模拟和机器人视觉等。

GEN3C技术原理

-

3D缓存构建:

-

GEN3C通过深度估计将输入图像或视频帧反投影到3D空间,形成点云作为3D缓存。

-

3D缓存可以来自单视图、多视图或动态视频,支持不同应用场景。

-

通过显式的3D表示,GEN3C能够更好地处理视图变化和动态内容。

-

-

相机轨迹驱动的渲染:

-

用户指定的相机轨迹用于渲染3D缓存,生成与新视图对齐的2D视频。

-

渲染过程中会生成遮挡区域的掩码,用于指示需要填充的区域。

-

-

视频生成与融合:

-

渲染后的视频作为条件输入,注入到视频扩散模型中。

-

通过最大池化等策略融合多视图信息,避免因深度不一致或光照差异导致的错误。

-

视频扩散模型被微调以纠正渲染过程中的伪影,并填充缺失信息。

-

-

自回归生成与3D缓存更新:

-

长视频生成时,GEN3C将视频划分为重叠的块,逐块生成。

-

每生成一块后,更新3D缓存以包含新生成的视图信息,确保后续生成的一致性。

-

-

基于扩散模型的视频生成:

-

GEN3C利用预训练的视频扩散模型(如Stable Video Diffusion或Cosmos)作为基础,通过微调实现高质量视频生成。

-

扩散模型通过逐步去噪生成视频,支持高分辨率和长序列的视频生成。

-

-

鲁棒性与泛化能力:

-

GEN3C对深度估计的噪声具有一定的鲁棒性,即使在深度信息不完美时也能生成高质量的视频。

-

模型通过在真实世界和合成数据上训练,具备良好的泛化能力,能够处理多种场景和视图变化。

-

GEN3C应用场景

-

电影制作与特效:用于生成逼真的场景过渡、虚拟镜头和特效镜头,降低拍摄成本,提升创作灵活性。

-

自动驾驶模拟:模拟真实驾驶场景,生成不同视角的驾驶视频,用于训练自动驾驶系统,提升其对复杂场景的适应能力。

-

虚拟现实(VR)和增强现实(AR):创建沉浸式的虚拟环境,支持用户自由切换视角,增强用户体验。

-

游戏开发:快速生成高质量的游戏场景和动画,支持动态视角切换和实时渲染,提升游戏的视觉效果。

-

建筑设计与可视化:从单张建筑图像生成多视角视频,帮助设计师和客户更好地预览建筑效果。

-

机器人视觉与导航:为机器人生成不同视角的场景视频,用于路径规划、目标识别和环境交互,提升导航能力。

GEN3C项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号