Aya Vision简介

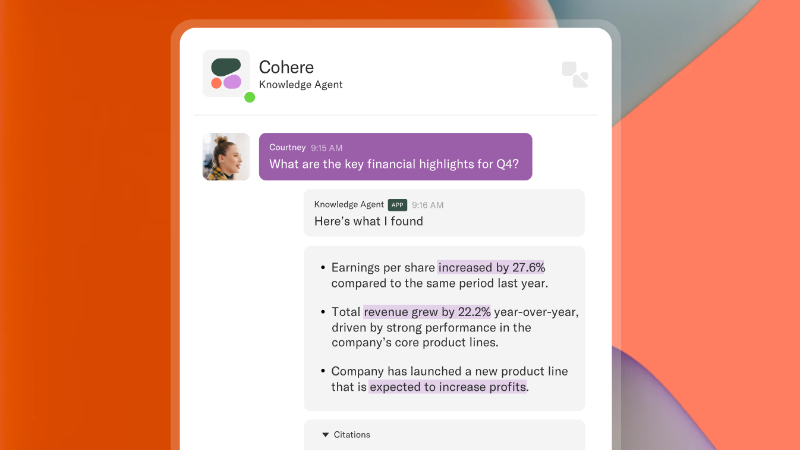

Aya Vision 是由 Cohere 团队开发的先进多模态、多语言视觉模型,旨在提升全球多语言场景下的视觉和文本理解能力。该模型支持 23 种主要语言,具备图像描述生成、视觉问答、文本翻译和多语言摘要生成等功能。开发团队通过创新的多模态架构和高效的数据增强技术,使 Aya Vision 在性能上超越了部分体量更大的模型,同时提供了 32B 和 8B 两种版本以满足不同需求。其高效计算性能和广泛语言支持,为跨文化交流、视觉障碍辅助和多语言研究等场景带来了新的可能性,成为多模态 AI 领域的重要突破。

Aya Vision主要功能

-

图像描述生成:Aya Vision能够根据输入的图像内容,生成清晰、准确的文字描述,帮助用户快速理解图像所表达的信息。

-

视觉问答(VQA):它结合图像识别和语言理解能力,能够回答用户关于图像内容的问题,提供更深入的视觉信息解读。

-

多语言支持:该模型支持23种主要语言,能够处理多语言的输入和输出,有效打破语言障碍。

-

文本翻译与摘要生成:Aya Vision可以将文本从一种语言翻译成另一种语言,并生成简洁的文本摘要,帮助用户快速获取关键信息。

-

跨模态交互:它能够将视觉信息与语言信息相结合,实现图像与文本之间的无缝交互,为用户提供更丰富的信息体验。

Aya Vision技术原理

-

多模态架构设计:Aya Vision采用了一种分层的多模态架构,包括视觉编码器、视觉语言连接器和语言模型解码器。视觉编码器负责提取图像的关键特征,连接器将图像特征与语言模型的嵌入空间对齐,而解码器则用于生成自然语言输出。

-

合成标注与数据增强:为了提升模型的多语言能力,开发团队使用AI生成的合成标注数据进行训练,并通过翻译和重述技术增强数据的多样性和质量。此外,模型还通过动态调整图像分辨率和像素混洗技术,进一步提高计算效率。

-

两阶段训练策略:第一阶段,视觉和语言组件被冻结,仅训练视觉语言连接器,以确保视觉和语言信息的有效对齐。第二阶段,通过在23种语言的多模态任务上进行联合训练,进一步优化连接器和语言模型的性能。

-

高效计算优化:尽管Aya Vision的参数规模较小(8B和32B),但通过优化架构和训练策略,其性能在多个基准测试中超越了更大规模的模型。这种高效的设计使其在实际应用中更加灵活和高效。

Aya Vision应用场景

-

辅助教育:帮助学生理解复杂的图像或艺术作品,通过生成描述来解释图像内容,提升学习体验。

-

内容优化:为多语言网站或社交媒体生成图像描述,增强内容的可访问性和吸引力。

-

安防监控:分析监控视频,快速识别异常情况,提高安全监控的效率和准确性。

-

医疗辅助:帮助医生解读医学影像,快速定位问题,提升诊断效率。

-

电商体验:通过图像分析为用户推荐相关商品,提升购物体验和转化率。

-

客户服务:在多语言环境中,帮助客服快速理解用户问题,提供更精准的解决方案。

Aya Vision项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号